Deve ter sido por volta de setembro de 2003, que eu havia resolvido assistir ao seminário do diretor de fotografia norte-americano Gary Graver, no Festival Internacional de Cinema do Rio de Janeiro, sobre a restauração dos filmes do lendário cineasta Orson Welles, com quem Graver havia trabalhado.

Embutida na palestra, estava também acontecendo a reunião anual do Centro de Pesquisadores do Cinema Brasileiro, que eu não conhecia, e que previa também a apresentação do projeto de recuperação local de um filme em ruínas. Esta apresentação estava a cargo de um restaurador que, depois vim a saber, trabalhava para o Labocine, especializado em recuperação de filmes.

Terminada esta apresentação, foi dado à plateia o direito de participar, com opiniões e perguntas. Uma pessoa próxima pergunta ao restaurador local sobre a possibilidade de lançamento em DVD do filme por ele restaurado, e eu, puxando um gancho na pergunta, perguntei se o estúdio deles teria interesse em transferir o filme restaurado para fita master de alta definição, como já vinham fazendo os estúdios em Hollywood.

E foi neste momento, que o meu ilustre interlocutor e palestrante me interpelou, afirmando que “no Brasil, não havia TV de alta definição”. Mas, acontece que eu tinha acabado de comprar uma, e de repente ficou um mal estar momentâneo no ar, por conta do meu comentário contestatório.

Mesmo em 2003, quando não se falava abertamente sobre alta definição no Brasil, o formato em si já estava para lá de estabelecido, e vinha contribuindo muito para os esforços de restauração de filmes clássicos, primeiramente em escala de laboratório, depois a nível de mídia para o consumidor.

Por outro lado, 2003 foi o ano em que as primeiras telas 16:9 de alta definição estavam chegando ao mercado brasileiro. Sony, Philips e Toshiba lançaram modelos, todos acima de 12 mil reais, preparados para receber sinais de vídeo em 480p, 720p e 1080i.

Naquela época, eu tinha alguns bons contatos na divisão de engenharia da Sony, e com isso eu recebi a minha TV Sony 36XBR800 direto da Sony Manaus. No dia em que a TV chegou, eu participei a convite, por coincidência, de um congresso do setor, promovido pela Sociedade de Engenharia de Transmissão (SET).

Na exposição do congresso, duas coisas aconteceram: a primeira, que eu pude ver a presença de diversos grupos de pesquisadores e empresários brasileiros, com tudo pronto para gerar alta definição no Brasil, e a segunda, o meu testemunho do desânimo geral do setor, fruto da política torta do governo brasileiro, que impedia que a alta definição e a transmissão digital pudessem se tornar realidade.

Diante disso, de nada adiantava que os expositores, como por exemplo Sony e cia., tentassem convencer às emissoras em investir em equipamento novo, como câmeras, gravadores, etc. Nem a Rede Globo, que mais tarde iria implementar seu próprio núcleo de experimentação e geração de programas em alta definição, havia comprado nada.

Alguns dos meus amigos achavam, na época, uma temeridade que eu driblasse o meu sofrido orçamento para investir numa TV de alta definição, diante do cenário que se apresentava. Mas eu tinha convicção de que era tudo questão de tempo, não que eu acreditasse nos políticos e nas agências reguladoras, mas na caminhada inexorável do vídeo doméstico de alta definição.

Naquela época, eu já me contentava em ser capaz de ligar o meu aparelho reprodutor de DVD e mudar a configuração do mesmo para 16:9, com isso eliminando a conversão interna para 4:3 e ganhando 33% a mais de resolução, e de poder usar um circuito inovador, do tipo filtro correlacional, chamado de DCDi, e gerando com isso uma imagem a 480 linhas em varredura progressiva.

Os anos se passaram, e a minha convicção de que o futuro da alta definição estava nas mídias a serem vendidas diretamente ao público, na forma de arquivos ou discos, aumentou, e a prova está aí, apesar desse clima de incerteza sobre o futuro do broadcasting digital no país. Não há, até agora, nenhuma evidência concreta de que as transmissões digitais locais cheguem a algum lugar, apesar do interesse imediato dos provedores em tornar o sinal prontamente disponível nos telefones celulares.

E mesmo se houvesse, seria para ver exatamente o quê? O público que normalmente se pendura em novelas, telejornais e seriados por acaso sabe, tem interesse, ou pretende investir uma nota preta, em alta definição? Eu tenho cá as minhas mais profundas dúvidas!

O recente imbróglio causado pela devolução das TVs de plasma mostra claramente este despreparo: nem mesmo aqueles que estão envolvidos, por hobby ou por lazer, com assuntos de home theater, aqui e lá fora, tinham ideia de como iria ser a reação do consumo de massa, com o investimento neste tipo de tecnologia.

E, diante disso, cabe fazer uma pergunta, creio eu, relevante para o momento: o que é que ainda vem pela frente, que nos permitirá avançar na reprodução do chamado vídeo doméstico de alta definição? E para responder a esta pergunta, sem sermos necessariamente analistas de mercado, é preciso fazer uma introspecção no passado mais recente, e tentar analisar o que existe de perspectiva, em termos da tecnologia existente no mercado e no laboratório, com base nas informações recentemente divulgadas pela Internet, que é o que eu agora me proponho a fazer. Mas, antes, cabe perguntar:

De onde vieram os padrões de tela usados nos televisores?

E a resposta é: vieram do cinema! Depois de um início hesitante, os projetistas de televisores transformaram os cinescópios para acomodar o formato padrão do filme plano, com a relação de aspecto (“aspect ratio”) de 1,33:1, que é o chamado “Academy Ratio”, neste caso, referente à Academia Americana de cinema. E para conseguir esta acomodação, sem grandes traumas, as telas de TV passaram a ter o formato em 4:3, ou seja, uma relação de 4 de largura, para cada 3 de altura. Note-se que, como filme “plano”, define-se aquele feito com o uso de lentes esféricas (não anamórficas) e com relação de aspecto em 1,33:1 ou próximo desse valor. Com a evolução dos métodos de filmagem, esta relação foi progressivamente alterada para 1,66:1 (que não chega a ser considerada “widescreen”), 1,77:1, e 1,85:1, todos eles com lentes esféricas.

Na década de 1950, Hollywood começou a sentir o declínio da presença de público nos cinemas, e a conseqüente queda de renda de bilheteria, por culpa do aumento de aceitação dos programas de televisão. O golpe de misericórdia foi dado, quando uma lei americana “anti-trust“, impediu os estúdios de manter os direitos de exibição em cinemas exclusivos. Aqui no Brasil, por exemplo, nós tínhamos os cinemas Metro (três só no Rio de Janeiro), que exibiam filmes MGM exclusivamente. Para manter o lucro na produção de filmes, é necessário garantir a distribuição e a exibição, depois do filme produzido. Com a lei e o desmonte das cadeias exibidoras exclusivas, a maioria dos estúdios se viu em grande dificuldade financeira. Para tentar contornar isso, apelou-se para dois recursos até então subutilizados: telas de projeção brutalmente mais largas e som estereofônico (multicanal).

Para alargar as telas, recorreu-se primeiramente ao filme plano, porém numa mesma câmera, com três negativos, que eram depois projetados numa tela tripla, angulada, chamada de Cinerama, numa relação de aspecto entre 2,59:1 e 2.65:1, nos cinemas com capacidade para uma tela mais alta.

O impacto maior e melhor sucedido comercialmente, foi conseguido logo a seguir, com o uso de lentes anamórficas: primeiramente, a Fox, que lançou o CinemaScope (2,55:1 e depois 2,35:1), e depois com o uso de negativos mais largos, com uma bitola de 65 mm: Todd-AO (2,20:1), e a MGM com a chamada Camera 65 (2,75:1). Finalmente, apareceram algumas variações do Todd-AO, como o Super Panavision (2,20:1) e um monte de outros formatos widescreen.

A figura abaixo, tirada do site Wikipedia, mostra dois fotogramas, um deles com método widescreen fotografado com lente esférica e o outro, com uma lente anamórfica:

Na filmagem anamórfica, a imagem é comprimida verticalmente e depois “descomprimida” na projeção, na mesma proporção. Com isso, obtém-se uma tela larga, no tamanho desejado pelos cineastas. N.B.: este princípio foi depois reaproveitado nos DVDs realçados para telas 16:9, chamados, por causa disso, de DVDs anamórficos.

Como se pode perceber, a reprodução de um fotograma “widescreen”, numa tela de TV em formato 4:3 só é possível com uma perda considerável na amplitude da imagem. No início, os fabricantes de vídeo recorreram a um truque sórdido, chamado de “pan & scan” (movimento horizontal da câmera, seguido da transferência para o vídeo das partes do fotograma escolhidos). Mas depois, se veio com a idéia do “letterbox”, que consiste em transferir todo o fotograma para a tela 4:3, com a inserção de barras pretas no topo e na base, tal qual o fotograma widescreen, fotografado com lente esférica, mostrado acima.

Este processo gerou forte resistência daqueles consumidores que achavam que parte da imagem estava sendo “roubada” na tela da TV, quando na realidade era exatamente o oposto. Por causa disso, a grossa maioria dos vídeos em letterbox ficaram restritos aos usuários de laserdiscs, enquanto que o pan & scan dominava o mercado de massa dos videocassetes.

A solução definitiva foi mudar o padrão da tela de vídeo, e no caso, chegou-se ao consenso de que o formato ideal seria a tela de relação 16:9, que corresponde exatamente a 1,78:1 do fotograma do cinema. Mas porque 16:9?

Se nós formos a um moderno cinema multiplex, do tipo “stadium”, poderemos notar que a largura da tela é a mesma, para qualquer tipo de filme exibido. Os exibidores, com o objetivo de acomodar filmes mais largos, como por exemplo, Panavision a 2,35:1, fazem rolar coberturas em cima ou em baixo, que modificam a relação de aspecto verticalmente.

Através desta mesmíssima adaptação, só que o auxílio das barras pretas, mencionadas anteriormente, a tela 16:9 é capaz de acomodar praticamente todas relações de aspecto, a saber: 1,66:1 (com a inclusão de barras laterais), 1,77:1, 1,85:1, e todas as variantes do widescreen anamórfico, acima mencionadas.

A adoção da tela 16:9 leva, obviamente, a uma diminuição física, da exibição do formato antigo da academia, que é 1,33:1 (“full-frame” ou “standard”). Para compensar esta deficiência, o tamanho da tela das TVs foi obrigado a aumentar significativamente, primeiro com a retro projeção, depois com a projeção frontal, e agora com os painéis em estado sólido.

Para ver os prós e contras de cada um, eu irei comentar alguns aspectos das respectivas tecnologias, a seguir. Para tornar a exposição um pouco mais simples, eu pretendo dividir as tecnologias em uso em dois grupos: o primeiro, baseadas na excitação e emissão de luz de moléculas de fósforo, e o segundo, baseadas na transmissão da imagem por luz.

Telas baseadas na luz das partículas de fósforo

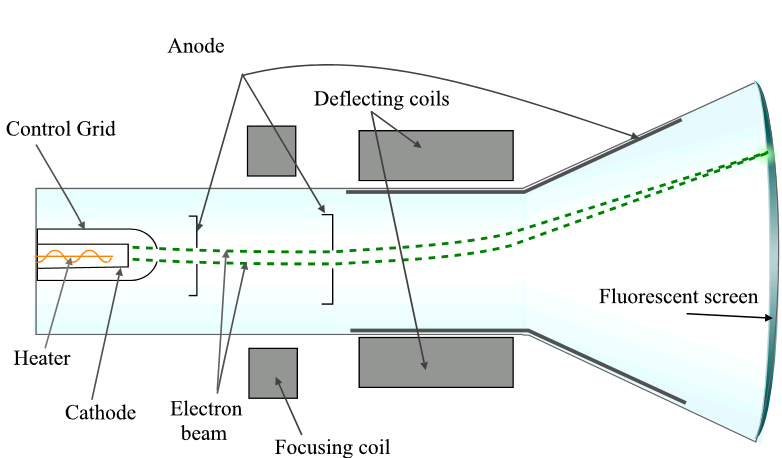

1. O tubo de imagem ou cinescópio de raios catódicos

O tubo de raios catódicos (em inglês, Cathode Ray Tube ou CRT) é a base da TV que todo mundo conhece. Já faz muitos anos, que a TV de tubo está com os dias contados, mas houve uma época gloriosa para o uso do tubo em projetores frontais e retro projetores. O empecilho maior desses últimos é a necessidade urgente de mantê-los devidamente calibrados, coisa que exige um técnico especializado ou um hobbyista dedicado. Sem esta calibração, estes aparelhos mostram deficiências de geometria e convergência assustadoras, sem falar na dificuldade de se acertar contaste, brilho e cor, sem passar por modificações internas nos modelos de retro projeção ou do seu menu de serviço. Se levarmos em consideração que existem hoje opções muito mais vantajosas no mercado, como LCD e DLP, mesmo necessitando algum tipo de calibração, o investimento neste tipo de equipamento só faria sentido, debaixo de alguma necessidade específica e premente!

Por outro lado, as TVs de tubo, apesar de populares e mais baratas, trazem alguns inconvenientes sérios, entre eles o do efeito de centelhamento (“flicker”), que é resultado da varredura do canhão de elétrons, bombardeando, em cadência de 50 ou 60 Hz, a camada de fósforo contido na superfície do tubo:

O centelhamento diminui muito nos tubos de alta definição, mas nos tubos convencionais ele castiga a visão do usuário de maneira significativa. Além disso, a maioria dos tubos não tem uma imagem plana, nem mesmo aqueles vendidos como tal, e em decorrência disso, é muito comum se observar erros como o de convergência (caso em que o feixe de elétrons erra o alvo, e excita a molécula de fósforo errada, mostrando uma sombra colorida na imagem), e o de geometria, onde as linhas retas nos cantos aparecem distorcidas. Finalmente, existe um problema grande de foco na imagem, e, neste ponto, quanto mais barato for o tubo, menos resposta para foco ele tem, motivo pelo qual muita gente que compra um leitor de DVD nunca consegue uma imagem decente, mesmo depois dos dois equipamentos regulados.

2. Os painéis de plasma

O painel de plasma foi inventado na Universidade de Illinois, por Donald Bitzer, Gene Slottow e colaboradores, em 19641. Um dos seus objetivos foi a eliminação do centelhamento, acima mencionado, e da correção geométrica e de foco da imagem, o que é conseguido pela excitação individual das camadas de fósforo na tela.

A imagem é composta por milhões de pequenas células, que contém um gás inerte, que emite luz ultra-violeta (UV) sob a passagem de corrente elétrica. A luz UV excita o fósforo, que produz assim a imagem. Tipicamente, um painel com 1024 x 768 pontos (ou pixels) conterá 1024 x 768 x 3 = 2.359.296 células, que são dispostas numa matriz. Note que, para cada ponto ou pixel, é necessário subdividir em 3 subpixels, correspondendo às cores Vermelho (Red), Verde (Green) e Azul (Blue). Cada ponto da matriz é eletricamente acionado por barras de endereçamento, uma vertical e outra horizontal.

Os painéis de plasma atraem adeptos, por causa do nível de contraste que se consegue para imagens de cinema. Em contrapartida, são altamente suscetíveis a marcas ou manchas. Quando temporárias, essas manchas podem ser removidas pela repolarização das moléculas de gás dentro das câmeras. Mas, outro efeito, pior e praticamente difícil de corrigir, é a queima desigual das partículas de fósforo, chamado genericamente de efeito de “burn-in”.

Ninguém, que eu saiba, conseguiu, até hoje, explicar por que os painéis de plasma são mais suscetíveis ao burn-in do que as telas CRT. Uma explicação possível se refere ao fato de que a descarga de luz UV pode perfeitamente afetar permanentemente a estrutura química das moléculas de fósforo do painel. Normalmente, a incidência de energia luminosa excita os elétrons da substância desta camada, que pulam para um orbital de maior energia. Cessada a excitação, os elétrons voltam aos seus orbitais nativos, mas ao fazer isso, emitem luz, fenômeno chamado de fotoluminescência.

No caso de partículas de fósforo (geralmente sais de zinco ou cádmio), a emissão é fosforescente, ou seja, ela continua por mais tempo (por exemplo, 200 nanosegundos), mesmo depois de cessada a excitação. É possível que, dependendo da intensidade da radiação UV incidente nessas moléculas, elas venham a se alterar estruturalmente, e deixem de emitir luz na mesma intensidade de antes. Este fenômeno, chamado de extinção, é particularmente verdadeiro para moléculas de materiais orgânicos. Pelo mesmo motivo, existe a chance de que os painéis de plasma venham a diminuir a sua vida útil, ao longo dos anos, tal qual os tubos do tipo CRT.

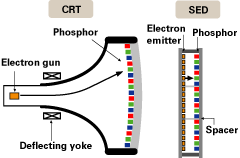

3. SED ou Surface-conduction Electron-emitter Dis

Toda vez que surge uma tecnologia nova, a gente fica esperando um novo milagre acontecer, e, se depender, dos seus proponentes, não vai ter espaço para mais ninguém. Na prática, porém, a gente só pode tirar conclusões com o correr do tempo, de forma a verificar outros aspe ctos que não só a performance, como por exemplo, durabilidade. A tecnologia SED2 se baseia na emissão de elétrons por uma superfície condutora de eletricidade. A concepção é extremamente atraente, porque, ao contrário do tubo de raios catódicos, é possível aproximar o emissor da camada de fósforo, na forma de um painel, bastante fino e eletricamente econômico. Na realidade, a alimentação elétrica pode ser individual para cada pixel, com isto garantido uma performance livre de erros de geometria, tal como nos painéis de plasma, sem ter, supostamente, os efeitos de queima, por causa da baixa amplitude da emissão.

ctos que não só a performance, como por exemplo, durabilidade. A tecnologia SED2 se baseia na emissão de elétrons por uma superfície condutora de eletricidade. A concepção é extremamente atraente, porque, ao contrário do tubo de raios catódicos, é possível aproximar o emissor da camada de fósforo, na forma de um painel, bastante fino e eletricamente econômico. Na realidade, a alimentação elétrica pode ser individual para cada pixel, com isto garantido uma performance livre de erros de geometria, tal como nos painéis de plasma, sem ter, supostamente, os efeitos de queima, por causa da baixa amplitude da emissão.

Telas baseadas na transmissão de luz por um meio sólido

1. O painel de cristal líquido ou Liquid Crystal Display

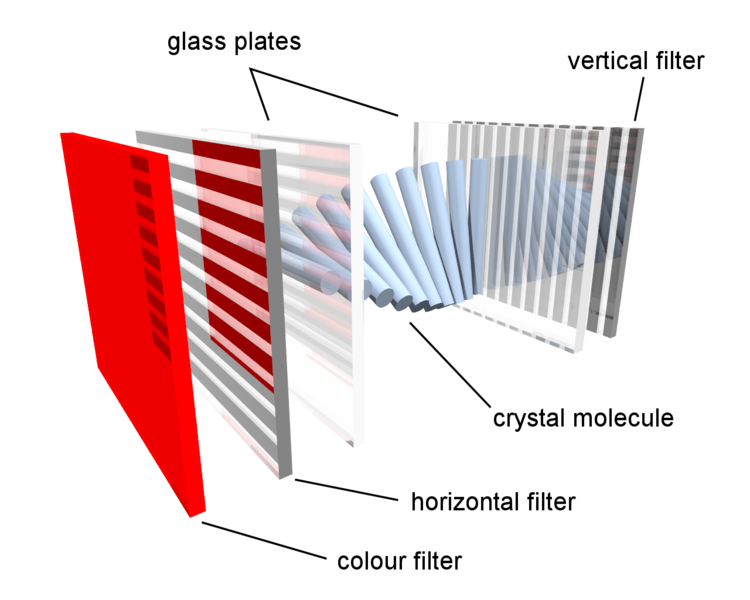

Como “cristal líquido” se define uma substância cujo estado físico está entre as fases sólida e líquida. Os cristais líquidos do tipo nemático são capazes de deixar passar luz como se fossem um pequeno filtro polarizador (filtro que permite a passagem de somente um dos vários planos de vibração da energia luminosa). Para construir um painel de cristal líquido, é preciso ter três elementos básicos: uma fonte de luz (geralmente do tipo fluorescente, na região de emissão da luz visível), dois painéis de polarização, sendo que um deles fica disposto a 45º do outro, e finalmente, uma camada de cristais líquidos nemáticos:

A luz passa pelo primeiro filtro polarizador, e depois é “conduzida” pelos cristais líquidos, de tal forma que, quando ela chega no segundo filtro, ela está exatamente a 45º do plano de vibração original, e assim passa sem problemas pelo mesmo, indo incidir na superfície externa, geralmente composta de um filtro colorido, como na figura acima. Com isso, é possível construir um subpixel, nas cores fundamentais do espectro RGB, que compõem as imagens coloridas dos painéis.

Quando cada conjunto desses é alimentado eletricamente, os cristais desviram da posição indicada acima, bloqueando totalmente a passagem da luz polarizada no meio. Quando a corrente é cortada, os cristais voltam à posição de relaxamento, ou seja, desviram de forma a deixar a luz passar, de acordo com a figura acima.

A modulação deste relaxamento, através da aplicação de corrente elétrica adequada, permite determinar o grau de contraste da imagem desejada. O tempo gasto em qualquer estágio desta operação é chamado de “tempo de resposta” e determina, em última análise, a velocidade na qual o painel de LCD reage às variações de corrente elétrica que o alimenta. Na prática, quanto mais rápida for esta resposta, mais precisa será a reprodução de imagens em movimento.

Valores típicos para painéis rápidos estão na faixa de 12 ms ou menos, geralmente entre 10 e 8 ms. Painéis mais recentes exibem tempo de resposta em torno de 6 ms, quando então a mudança de quadros se torna virtualmente imperceptível ao olho humano. Por outro lado, o brilho da imagem que chega à superfície do painel é determinado pela amplitude da intensidade da luz na fonte, o que é conseguido variando-se a corrente em cima da lâmpada que alimenta o painel.

A expectativa de duração de uma lâmpada usada em painéis LCD, em condições normais de uso, é de cerca de 60,000 horas. Em princípio, seria possível substituir esta lâmpada, o que daria vida ilimitada aos painéis.

O grande trunfo das telas LCD é que não existe excitação de qualquer substância, para se conseguir contraste, tal como acontece nas telas à base de fósforo. Por causa disso, não é possível haver queima do painel, da mesma forma como os de plasma ou CRT. Por outro lado, existe a chance de que os cristais líquidos não respondam aos estímulos elétricos aplicados, e isso os torna “permanentemente acesos”. Se, ao contrário, a alimentação elétrica impede o seu relaxamento, eles ficam “permanentemente apagados”.

Um pixel com este tipo de problema, não é necessariamente resultado de alteração dos cristais líquidos. Os painéis LCD em uso nas instalações de home theater são do tipo “matriz ativa”, com uma alimentação feita por um transistor muito fino (TFT, ou Thin Film Transistor). Se o transistor estiver em curto, o pixel respectivo apresentará “defeito”, e neste caso, nada mais se poderá fazer.

A maior crítica, que eu já li em fóruns de usuários para o LCD, é a ausência do chamado “preto absoluto”. Embora não seja possível garantir que o preto neste nível possa existir, é bastante provável que ele não atrapalhe a exibição de material de cinema, da maneira como os seus críticos alegam. Além disso, é muito mais fácil se conseguir alta resolução plena (1980 x 1080 pixels) num painel de LCD, do que, por exemplo, num painel de plasma.

Além disso, o aumento do contraste, que pode ser uma imensa dor de cabeça com outros painéis, tem fácil controle nos painéis LCD, sem prejuízo algum ao mesmo. Os atuais painéis têm uma relação de contraste (diferença entre os níveis máximos de partes claras e escuras da tela) em torno de 800:1 e acima, o que é suficiente, por exemplo, para dar uma aparência de filme de cinema na imagem obtida.

Painéis de LCD em tamanho grande têm aparecido mais recentemente, nas faixas de 70 a 100 polegadas. Estas telas são, em geral, fruto das parcerias entre os fabricantes Philips e LG, e Sony e Samsung. O mercado de telas em cristal líquido tomou grande impulso com o seu uso como monitores de computadores, mas alcança rapidamente o espaço deixado pelos televisores de painel e projetores, principalmente após a recente queda de preço do produto final.

2. Cristal Líquido em sistemas de projeção

O cristal líquido pode também ser usado, com grande aplicabilidade, tanto em projetores frontais como em retro projetores. No caso dos retro projetores, o LCD veio substituir com muitas vantagens os antigos sistemas, a base de CRT. Entre essas vantagens, está a construção do sistema ótico com menos distorção geométrica, mais leve e de fácil manutenção. O sistema ótico tanto pode ser de 1 ou 3 cristais em linha.

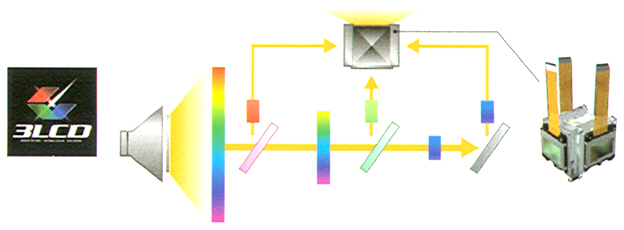

No caso de 3 cristais, o sistema ótico passa a ser composto por filtros nos comprimentos de onda das três cores fundamentais (RGB), como mostrado abaixo, no design usado pela Sony:

Os 3 LCD são justapostos de maneira a que não haja necessidade de realinhamento mecânico e, no caso, a lâmpada é posicionada de forma a ser facilmente substituída pelo próprio usuário. Para compensar dinamicamente o contraste, a Sony implementa uma íris (diafragma) automática, que deixa passar mais ou menos luz, dependo da análise em tempo real da imagem a ser projetada. Este mesmo sistema de íris é também usado nos projetores frontais.

Uma variante mais atual deste design é o LCoS (Liquid Crystal on Silicon), que é o depósito de cristais líquidos num chip dedicado, no qual a fonte de luz incide. O sistema é portanto reflexivo por natureza, semelhante, no caso, ao DLP (ver abaixo), e projetado comercialmente para competir com o mesmo.

A própria Sony manufatura o LCoS com o nome de SXRD3, e no caso, somente usado em retro projetores. O SXRD tem recebido críticas severas, de alguns analistas, quanto à desobediência do padrão ANSI, para contraste e nitidez, mas este problema, na realidade, é resultado direto do uso do LCoS, que gera, segundo se observa, uma imagem mais “flu” (fora de foco).

3. DLP (Digital Light Processing)

A tecnologia DLP é proprietária da Texas Intruments4, e tem aplicações domésticas e principalmente profissionais, com 1 e 3 microprocessadores DLP, respectivamente. O método consiste basicamente na inserção de micro espelhos, cuja inclinação consegue modular a passagem ou não da luz incidente:

Como este sistema só é capaz de gerar tons de cinza, é necessário acoplar uma série de filtros coloridos, nas regiões do vermelho (R), verde (G) e azul (B), o que é feito de duas maneiras: no sistema de apenas 1 DLP, cada filtro é intercalado numa roda, que gira em sincronismo com o processamento da imagem. Já no sistema de 3 DLP, os filtros podem ser implementados separadamente, evitando, desta forma, qualquer atraso de processamento, que, aparentemente, resulta no chamado “efeito de arco-íris” (do inglês, “rainbow effect“), que alguns usuários conseguem perceber, em alusão à separação das cores na composição das imagens, particularmente no contorno das mesmas.

Por outro lado, o sistema com DLP tem grande reputação entre os entusiastas, pelo excelente nível de preto e contraste que ele gera. O uso profissional do DLP pode ser visto nos cinemas que usam projeção digital de alta definição.

Não há dúvida de que, ao longo desses últimos anos, a tecnologia de monitores e televisores tomou um impulso nunca antes visto, e a cada dia, mais novidades tendem a sair dos laboratórios, em direção às fábricas e aos usuários. Há algum tempo atrás, era mais fácil fazer a distinção entre monitores e televisores, já que os primeiros eram construídos sem circuitos de sintonia, e dedicados à alta qualidade da imagem. Hoje em dia, no entanto, essa distinção não é mais possível: as telas de plasma e LCD ganharam sintonizadores, enquanto que os monitores para computadores se tornaram veículos multimídia, com a inclusão de alto-falantes e outros acessórios.

Além disso, até certo tempo atrás, o processamento de imagens só era possível através de programas escritos para ambientes e sistemas operacionais existentes em computadores pessoais. Um exemplo típico é o remapeamento e/ou interpolação de pixels, necessários hoje dia à adaptação de imagens digitais ou analógicas em telas digitais, como plasma ou LCD, e para a melhoria da definição nativa das mídias, respectivamente. A ponte para a implementação desses algoritmos é possível, pela inserção de novos circuitos integrados e softwares, encontrados nos televisores e reprodutores de vídeo, como os leitores de DVD.

A concretização deste objetivo torna agora imperativa a atualização dos softwares internos dos aparelhos que os utilizam, conhecidos, nestes casos, genericamente, como “firmwares”. A implementação de portas de conexão, assemelhadas às dos computadores, como por exemplo, USB ou outra serial, é, portanto, compreensível e necessária para esta finalidade.

Por outro lado, eu acho pertinente a observação de que alguns conceitos, relativos às mídias propriamente ditas, continuam sem nenhuma modificação. Por exemplo: o filme 35 mm ainda é um padrão intocável, e é usado como referência do que se convencionou chamar de “alta definição” em vídeo. Uma vez transformado em “vídeo”, o filme muda de características, de tal maneira que ele não é mais reconhecido como “filme”.

E o dito “cinema digital”, que claramente está bem mais próximo do “vídeo” do que do “filme”. Entre os entusiastas e hobbyistas, encara-se o meio de reprodução da mesma forma, já que todas as comparações ainda são feitas ao filme projetado. Para o cinéfilo, no caso, interessa que o sistema de reprodução de vídeo seja o mais próximo possível do filme, e é possível que algum dia isso venha de fato a ser conseguido. Como eventualmente, também, é bastante provável que o filme convencional venha a ser usado apenas como fonte de arquivamento.

No que concerne aos displays e monitores, eu, pessoalmente, vejo pouco futuro nas telas de plasma, por causa das limitações de uso com imagens estáticas. E, neste particular, se os novos painéis e sistemas, que ainda se baseiam na excitação de fósforo para criar imagens, não derem certo, é bastante provável que o uso de substâncias à base de fotoluminescência seja descartado por completo, ao longo dos anos. Neste caso, os processadores de imagens, à base de transmissão de luz, se tornarão prevalentes na fabricação e no consumo.

As fontes de luz estão sofrendo, e deverão sofrer mais ainda, modificações no sentido da economia e durabilidade. Isto já conseguido nas lâmpadas fluorescentes, usadas nos painéis de LCD e dos LEDs implementados em retro projetores, no lugar da lâmpada de halogênio, que tem durabilidade relativamente curta.

Finalmente, não creio que a tela em formato 4:3 tenha algum futuro. Na realidade, a imagem 1,33:1 em 4:3 sofre, via de regra, da omissão da reprodução de parte do fotograma, em virtude do “overscanning” (linhas da varredura nos tubos de imagem que ficam para fora da visão do usuário). A tela 16:9, entretanto, pode reproduzir 4:3 sem nenhum overscanning, e assim, ironicamente, é a melhor opção até mesmo para a imagem padrão de 4:3. [Webinsider]

………………………………………………………………..

Referências:

1 – http://www.ece.uiuc.edu/alumni/w02-03/plasma_history.html.

2 – http://www.canon.com/technology/canon_tech/explanation/sed.html.

3 – http://www.sonystyle.com/is-bin/INTERSHOP.enfinity/eCS/Store/en/-/USD/SY_ViewStatic-Start?page=static%2farticles%2fsxrd%2eisml.

4 – http://www.dlp.com/dlp_technology/dlp_technology_overview.asp?bhcp=1.

.

Paulo Roberto Elias

Paulo Roberto Elias é professor e pesquisador em ciências da saúde, Mestre em Ciência (M.Sc.) pelo Departamento de Bioquímica, do Instituto de Química da UFRJ, e Ph.D. em Bioquímica, pela Cardiff University, no Reino Unido.