Ciência e tecnologia, com as suas respectivas áreas de pesquisa, andam de mãos dadas faz tempo! Descobertas científicas ajudam a impulsionar a tecnologia e esta última ajuda a ciência, quando cria instrumentos sofisticados de medida.

Pesquisadores, inventores e descobridores, entretanto, raramente têm vida fácil. Dezenas de descobertas legítimas são desacreditadas ou se situam fora do contexto ao qual elas se encaixam, deixando assim de serem notadas pela comunidade que as aplicaria eventualmente. E quando se trata de tecnologia baseada em um fato científico, muitas vezes quem cria ou desenvolve se vê às voltas com a incredulidade alheia.

Frequentemente, é preciso tempo, muito tempo, eu diria, para as coisas se assentarem e serem colocadas nos seus devidos lugares. A ciência, por exemplo, se baseia na observação, levantamento de hipóteses capazes de explicá-la e posteriormente testes para provar ou desmentir as mesmas.

O problema é que a grande maioria dos testes científicos se respalda na análise estatística das medidas efetuadas pelo pesquisador. Assim, o máximo que se consegue é atingir um resultado que aumente o grau de probabilidade de que o fenômeno observado possa ser verdadeiro ou falso. O teste estatístico depende de um cálculo matemático preciso e aplicado caso a caso. Se o teste escolhido for errado, toda a análise conseguida ficará automaticamente nula, e não se chega à conclusão nenhuma. Além disso, existe um fator limitante a qualquer estatística, que se refere ao número de observações: quando maior for este número, maior será a veracidade do resultado dos testes. Por isto, em ciência as comprovações se tornam fato somente depois de um número significativo de constatações e testes sucessivos!

A bioquímica, que era o meu campo de trabalho, elucidou a maneira como a vida celular é possível, particularmente as transformações químicas nas reações do metabolismo intermediário. Depois das primeiras descobertas, conceitos sobre o que é um organismo vivo tiveram que ser mudados. Observações que datam do fim do século 17 e início do século 18 já mostravam a percepção de que estas transformações existiam no meio biológico. Estudos sobre a fermentação de oses (conhecidas popularmente como açúcares) indicavam que havia uma transformação deste tipo de substância em derivados alcoólicos.

Na época, se acreditava que a presença de células íntegras era necessária para que a fermentação acontecesse. Daí ter nascido o conceito de que a vida não é possível fora das células. Até que em 1897 o químico alemão Eduard Büchner demonstrou que isto não era verdade. Büchner consegue fazer um extrato de leveduras mortas e com ele a fermentação do açúcar. Alguns anos antes, outro químico alemão, Wilhelm Kühne, com base em estudos similares, propôs que substâncias isoladas de organismos vivos participam ativamente do processo de fermentação. E sugeriu para elas o nome “enzima” (“ein zyme”, ou o que vem da levedura), e para o fenômeno da fermentação, o termo “fermento”, usado até hoje. Na verdade, o fermento em tablete, obtido nas padarias, nada mais é do que um pacote com células de levedura resfriadas.

No entanto, décadas se passaram até que alguém pudesse isolar e identificar o que era uma “enzima”. Em 1926, o químico norte-americano James B. Sumner conseguiu isolar a enzima urease e tentou demonstrar que era uma proteína pura. O seu trabalho foi desacreditado pelos seus pares durante anos, e ficou assim até que dois bioquímicos, os americanos John Northrop e Wendell Stanley, provaram que as enzimas eram de fato proteínas, com o uso de cristalografia de raios-X.

Sem estes trabalhos pioneiros feitos teria sido impossível entender como uma enzima funciona. E o que tudo isto nos mostra é que a ciência caminha a passos lentos propositalmente, porque ela precisa de comprovação. A tecnologia, em contrapartida, desde que devidamente amparada por conhecimento e recursos, caminha a passos largos, porque os resultados costumam ser binários: dão certo ou fracassam. No campo da microeletrônica, por exemplo, caminhou-se mais e mais rápido do que em toda a evolução da eletrônica convencional reunida.

No campo da informática, a evolução foi inicialmente muito lenta

Charles Babbage, um matemático da Inglaterra vitoriana, teria se sentido frustrado e insatisfeito com a falta de precisão mostrada nas tabelas de cálculos e sonhou em construir uma máquina a vapor capaz de fazer cálculos com a devida exatidão. Visionário, mas empreendedor de poucos recursos, Babbage morreu sem ver o seu principal projeto levado a termo. Na época, o renomado astrônomo George Airy, consultor real, classificou o projeto de Babbage como inútil e sem futuro.

Charles Babbage teve em Ada, Condessa de Lovelace, uma parceria que resultou na criação de um conjunto de instruções operacionais, considerado depois como o primeiro programa de computador jamais criado. A máquina de Babbage previa a construção de um processador central, armazenamento e até impressão dos resultados, portanto tudo o que um computador moderno viria a ser.

É preciso notar que a preocupação destes pioneiros era com as falhas de cálculo originadas dos erros introduzidos pelo elemento humano. O termo “computador”, referente a quem faz cálculos, traduz com precisão este sentimento. Mas, as ideias de Babbage não frutificaram. E se passaram cem anos, até que o projetista alemão Konrad Zuse partisse da mesma ideia e construísse com sucesso um computador (calculador) elétrico, que trabalhava com relés de telefonia. Zuse descobriu também a noção de que cálculos em notação binária eram mais fáceis de executar eletricamente, e ele teria criado o primeiro computador a válvula (infinitamente mais rápida do que um relé para a mesma função), se não fosse a deflagração da segunda guerra mundial.

Por conta da segunda guerra mundial também foi que os trabalhos revolucionários do matemático inglês Alan Turing só ficaram devidamente conhecidos e divulgados muitos anos depois. Turing é considerado com inteira justiça o pai da chamada inteligência artificial. Ele idealizou a “máquina de Turing” para computações sofisticadas e adaptáveis a qualquer algoritmo.

O tempo iria mostrar que as ideias de Turing dariam a base para a moderna computação de dados. O computador de hoje é uma daquelas raras máquinas capazes de desempenhar múltiplas funções e tarefas: com ela você desenha, escreve, projeta, grava áudio ou vídeo, se comunica, e sim, também faz cálculos de grande precisão e em alta velocidade.

Mas Turing não viveu o suficiente para ver o seu sonho concretizado. Atormentado constantemente pela ameaça de punição à sua homossexualidade, ele morreu próximo de completar 42 anos de idade, em 1954, vítima de envenenamento por cianeto. O resultado do inquérito policial, apontando um possível suicídio, até hoje é questionado, talvez por conta do envolvimento do cientista em altos segredos do governo inglês durante a guerra.

O áudio é um exemplo de que nem toda tecnologia consegue alcançar unanimidade

O registro de vozes e música por métodos mecânicos possibilitou a documentação e a reconstrução da história, ao longo dos tempos. A música, em particular, deve muito à invenção da gravação de áudio. A tecnologia permitiu o registro de compositores e intérpretes pioneiros ou famosos, em estágio precoce de suas existências. O ouvinte pode hoje, por exemplo, ouvir a gravação de 1902 do lendário tenor Enrico Caruso, feita em Milão, com a interpretação de “E Lucevan Le Stelle”, trecho da ópera “Tosca”, de Puccini. Segundo historiadores, foi esta gravação que impulsionou a fama mundial do artista.

Ao ouvir agora a gravação de Enrico Caruso é possível aquilatar não só os alegados méritos do cantor, mas também como a captura e a reprodução do som evoluíram através das décadas. E, no entanto, nada que impedisse, durante décadas, grupos de usuários de formar correntes contra e a favor de certas transformações da tecnologia de gravação, ao invés de se proporem a entender como elas aconteceram. No bojo destas disputas de gosto e de ego sobre a reprodução do áudio, ainda estão por aí as seguintes correntes: a favor da válvula e contra o transistor, a favor do transistor e contra o circuito integrado, a favor do vinil e contra o CD, a favor do analógico e contra o digital, LPCM versus DSD, e vai por aí. Estas disputas de opinião transformaram-se em guerras. Com o aparecimento da internet, elas saíram das páginas de revistas especializadas, para alcançar um público que usa a rede para guerrear diariamente, mesmo no mais civilizado dos fóruns.

Curiosamente, a gravação de áudio já nasceu polêmica: Thomas Edison se debateu contra o disco fonográfico, inventado por Berliner. Teóricos do assunto reclamam que a modulação lateral (horizontal) de sulcos (usada nos discos) é inferior à modulação vertical (usada no registro dos cilindros). No livro “From Tin Foil To Stereo”, dos autores pró-Edison Oliver Read e Walter Welch, há uma defesa arraigada sobre a modulação vertical usada nos cilindros. Mas, nenhum deles conseguiu explicar porque nada disto prejudica o disco estereofônico analógico, cujo sulco usa ambas as tecnologias, por motivos técnicos.

O disco analógico de corte direto

Na década de 1970, alguns donos de selos de audiófilo argumentaram que os estúdios estavam exagerando no uso de fitas magnéticas, e tinham razão: para chegar ao disco final, e com a mixagem e a equalização desejada na sala de corte do acetato, a fita matriz analógica (1ª geração) é reprocessada várias vezes, com perda de qualidade entre uma geração e outra.

O processamento do original se justifica pela necessidade de edição e remixagem. Em última análise, o estúdio prefere criar uma fita matriz de um ou dois canais, já preparada para as características e especificações dos tornos usados no corte do acetato que será enviado para a estamparia (duplicação) dos discos.

Por causa disso e se valendo deste argumento, foram criados discos fonográficos em tornos de corte modernos com eliminação da fita magnética como veículo de captura, o chamado disco de corte direto (“direct-cut”). O processo é conseguido com a alimentação do torno com pré-amplificadores customizados. O resultado é habitualmente excelente.

Nada, entretanto, que impedisse críticas ao processo quando os discos de corte direto foram lançados, chamando-o de “back to basics”, pela impossibilidade de usar o principal recurso das fitas magnéticas, que é a edição do original. Outra crítica, neste caso bastante pertinente, é sobre a limitação da estamparia: uma madre só deve ser duplicada um certo número de vezes, se for para garantir a qualidade do disco estampado. Demorou um pouco, mas os selos que aderiram ao corte direto acabaram revelando que eles faziam “fitas de referência”. Na época, muita gente se sentiu traída com a noção de “número limitado de edições” e um aumento de preço no produto por conta disto.

Os críticos do corte direto não deixam também de terem suas razões no embasamento técnico: existe uma miríade de parâmetros no ajuste correto do corte de acetato, que nada têm a haver com a qualidade da fita magnética que entra na sala de corte. O assunto, em se tratando de uma mídia fono-mecânica, é mais polêmico do que se imagina. N.B.: Este problema é hoje possível de ser avaliado pelo usuário estudioso, na audição de SACDs da série Living Stereo, transcritos (sem qualquer pós-processamento) a partir dos originais de três canais direto para o DSD, e já comentados nesta coluna.

A evolução do “long playing”

O disco de 33 1/3 rpm (rotações por minuto) teve dois momentos distintos na história do mercado fonográfico. O primeiro deles data do final da década de 1920, quando os laboratórios da Western Electric usaram o formato para a reprodução de trilhas sonoras de filmes (Vitaphone). A RCA aproveitou a ideia e lançou o disco para o consumidor de música gravada com esta rotação em 1931, mas foi um fracasso de aceitação e vendas, e o disco, logo a seguir, abandonado. Uma série de fatores técnicos, limitantes da qualidade do som, ajudaram a impulsionar esta queda.

É difícil precisar porque as rotações dos discos fonográficos ficaram estabelecidas como 78, 45, 33 1/3 e 16 rpm (velocidade angular medida em rotações por minuto), ao longo do tempo. Historiadores apontam o fato de que Emile Berliner, inventor do Gramofone, havia estabelecido um tamanho de disco de 10 polegadas, e calculado a velocidade entre 70 e 90 rpm, que ele teria que usar para poder gravar e reproduzir cerca de três minutos de áudio. O objetivo deste design seria competir com o cilindro de Edison.

Berliner conseguiu inventar uma maneira de duplicar seus discos, o que lhe deu uma enorme vantagem de mercado, visto que os cilindros de Edison nunca conseguiram tal façanha. Com o passar do tempo, motores para corrente alternada são então acoplados aos pratos dos toca-discos. Berliner teria antes avaliado empiricamente que 78 rpm daria a melhor relação qualidade do som/tempo de duração por disco. Em 1925, a produção em massa de um motor rodando a 3600 rpm, em rede de 60 Hz, poderia ser usado em conjunto com uma engrenagem de acoplamento com redução de 46:1, girando o disco no prato a exatos 78.26 rpm (3600 ÷ 46), velocidade que se tornou padrão desde então.

Discos de 78 rpm, mesmo depois de aumentado o tamanho para 12”, não conseguiam reproduzir mais do cinco minutos de gravação. Para o processo Vitaphone, a Western Electric teve que arrumar uma solução para que um rolo de filme rodasse por típicos 10 a 11 min, sem que os discos precisassem ser trocados. E isto só foi possível pela redução da velocidade do disco, calculada em princípio em 32 rpm. Com o acoplamento de motor elétrico de 3600 rpm e com uma engrenagem de acoplamento a 108:1, consegue-se exatamente 33 1/3 rpm (3600 ÷ 108).

O interessante na velocidade de 33 1/3 é que a diferença de ciclagem dos motores de corrente alternada é incapaz de alterar esta velocidade, coisa que não acontecia com os discos de 78 rpm. Explicando melhor: motores AC têm a sua velocidade final sincronizada à ciclagem exclusivamente e independem da variação da voltagem da rede. Na América do Norte, a ciclagem gerada é de 60 Hz, enquanto na Europa a ciclagem é de 50 Hz. Com 60 Hz na rede elétrica, obtém-se 33 1/3 rpm com acoplamento ao prato na relação de 108:1, como mostrado acima. Já na rede de 50 Hz, o mesmo motor rodará a 3000 rpm, mas aí basta alterar a engrenagem de acoplamento para 90:1 (3000 ÷ 90 = 33 1/3). Isto conferiu ao disco de 33 1/3 rpm uma enorme vantagem na sua comercialização.

No Brasil, quando a ciclagem passou de 50 para 60 Hz, durante a década de 1960, todas as polias de motor de toca-discos tiveram que ser trocadas pelos técnicos. Em dois cinemas que eu frequentei, as polias foram trocadas anos depois, e enquanto sem troca e com o motor dos projetores rodando mais rápido, o som das vozes dos atores era ridiculamente mais fina!

Limitações eletro-mecânicas

A indústria fonográfica passou anos investigando o formato dos sulcos e a rotação dos discos, de modo a aumentar a qualidade do som. Algumas destas noções se tornaram óbvias com o correr do tempo. Berliner havia padronizado um disco com rotação tangencial constante. Nele, um sulco conduz a agulha da borda para o centro. A velocidade linear de percurso da agulha varia de acordo com o raio do disco. Esta velocidade diminui significativamente, na medida em que a agulha se aproxima do centro do disco. Com a diminuição da velocidade linear, a amplitude do som gravado precisa diminuir drasticamente, sob pena de causar distorção mecânica e sonora.

A prática veio demonstrar que, mesmo nos melhores tornos de corte da matriz do disco, a distorção dos sulcos mais próximos do centro é inevitável. Por causa disto mesmo, selos de audiófilo determinaram o tempo de 15 minutos por lado como o mais próximo do limite físico da introdução de distorção sonora, em discos de 33 1/3 rpm.

Nos selos comerciais, a solução para aumentar o tempo de reprodução foi modificar o torno de corte do sulco para variar o passo da agulha, em função da amplitude do som gravado.

Outra solução foi encontrada pela RCA por volta do final da década de 1940, quando a empresa se lançou em pesquisas no laboratório para tentar resolver o problema da falta de qualidade dos discos de 33 1/3 rpm de então. Para aumentar a velocidade linear da agulha e diminuir a distorção, aumentou-se também a sua velocidade tangencial do disco, simples assim! A melhor velocidade encontrada foi de 45 rpm. E ninguém sabe com certeza como ela foi determinada. Alguns argumentam que a RCA teria tentado provar que a velocidade ótima é aquela que produz a última linha de corte em um diâmetro metade do diâmetro da primeira linha (a mais externa do disco). Outros dizem simplesmente que 45 rpm é resultado do cálculo para os mesmos três minutos de duração de um disco 78 rpm, porém em um disco bem menor (7”).

Seja como for, a diferença de qualidade de um disco rodando a 45 rpm é notoriamente superior à do Lp em 33 1/3, daí selos como a Crystal Clear terem feito discos em corte direto, nesta velocidade, em discos de 12”, com excelentes resultados, no tocante a som e dinâmica. Só o aumento da qualidade do som justifica o uso de 45 rpm, porque o tempo de gravação praticamente se reduz à metade.

Durante anos, RCA e Columbia brigaram pela hegemonia de qualidade versus conveniência em discos fonográficos, a chamada “guerra das rotações”. Porque, em 1948, a Columbia conseguiu aperfeiçoar o sulco do disco 33 1/3, aliando o avanço no corte dos sulcos ao emprego de um plástico mais silencioso, ao invés da tradicional laca (“shellac”). O resultado é um disco de alta fidelidade e de longa duração por lado.

O maldito som digital

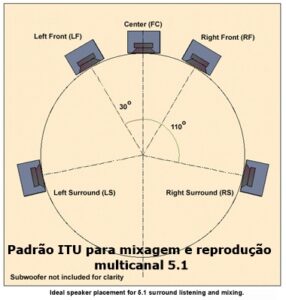

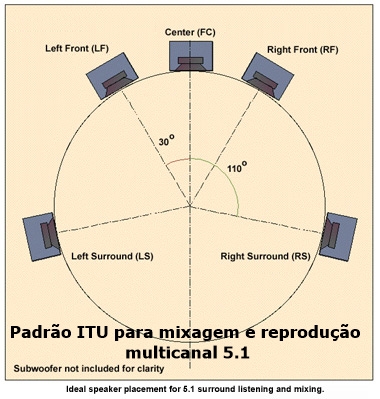

A diminuição da velocidade linear no rastreamento do pick-up de áudio analógico (conjunto agulha e cápsula) não existe em ambiente digital. O primeiro protótipo que a Philips fez para o Compact Disc era analógico, herança da tecnologia dos videodiscos, mas esbarrou neste e em outros tipos de problema. Ao optar pelo uso de áudio digital, a Philips conseguiu armazenar metadados na forma de subcódigos, em 8 subcanais distintos. Com estes códigos é possível determinar os parâmetros de reprodução e dar ao equipamento leitor informações sobre as faixas.

Na reprodução de áudio do CD, a transmissão de dados é constante: 1.4 Mbps. A velocidade do pick-up ótico é tornada linear, variando-se a velocidade tangencial do disco, de 210 rpm na borda para 480 rpm no centro. O sincronismo é informado por um dos subcódigos.

Antes de prosseguir, um parêntese e uma nota com um tom de ironia: o cilindro de Edison também tinha velocidade linear constante e, portanto, capaz de produzir som com a mesma qualidade, ao longo da duração da gravação, seja lá qual fosse.

O motivo principal pelo qual o cilindro não prevaleceu parece estar ligado ao fator conveniência: no disco fonográfico é bem mais fácil dividir o programa em faixas e ter acesso às mesmas mecanicamente. Em ambiente digital, este acesso é instantâneo, o que dá uma vantagem ao disco insuperável! Não é à toa que o uso de discos de dados em informática superou o uso de fitas magnéticas em relativo curto espaço de tempo.

Uma gravação analógica otimizada, não importa se por fita ou corte direto, alcança níveis satisfatórios de qualidade em torno de 65 dB de dinâmica, dependendo da frequência. Em ambiente digital a relação entre amplitude e frequência é irrelevante. A dinâmica de uma gravação é somente limitada pela captura do som gravado e jamais na mídia propriamente dita. A medição desta última, usando tons de referência, mostra números em torno de 90 a 95 dB, com uma relação sinal/ruído próxima deste valor. Mesmo no CD, que trabalha com 16 bits de resolução, ambas as especificações são respeitadas.

Também no som digital nunca houve consenso entre engenheiros e proponentes. Basta dizer que até recentemente as gravações eram feitas em fita magnética e alguns sistemas mais antigos apresentavam problemas, como perda de dados e apagamento da fita depois de um tempo de armazenamento. Durante vários anos, não houve consenso sobre a melhor frequência de amostragem para a gravação. E quando o CD saiu, com a frequência padronizada em 44.1 kHz, alguns estúdios se queixaram de deterioração de sinal, durante o processo de interconversão destas frequências. Nota: este problema não existe na conversão de PCM para DSD. Os ouvintes que quiserem comparar os resultados poderão fazê-lo com a audição do CD contra o SACD da mesma gravação.

Na década de 1990, a Meridian e o selo Hyperion gravaram peças clássicas usando o conversor analógico digital modelo 607 e um gravador de CD-R. Trata-se, portanto, da repetição do conceito do corte direto, em ambiente digital. Hoje em dia, com o uso disseminado de sistemas com o uso de discos rígidos, não se tem mais notícia, pelo menos que eu tenha notado, dos mesmos problemas de antigamente.

A ciência e a tecnologia avançam, mas as pessoas não

A enxurrada de tecnologia ao dispor do usuário atual e a necessidade que o mesmo tem de aprendê-la corretamente é uma luta desigual. Chega ser desumano obrigar uma pessoa que não tem interesse algum em entender como a tecnologia funciona se virar para usar máquinas dentro ou fora de casa.

Infelizmente, o dia a dia atual pune severamente quem não o faz. É só entrar em uma agência bancária e observar que mesmo aqueles que são experimentados têm dificuldades em usar os terminais de caixa eletrônico. Agora, quem nem experimentado é, a tendência é padecer até arrumar socorro. Isto ocorre principalmente porque qualquer interface com o usuário, e aí se incluem também os websites, devem ser bem desenhadas. Se não forem, levam à confusão na escolha de opções, sem falar que estas últimas nem sempre são intuitivas.

Outro lado ruim do avanço da tecnologia é o de afastar as pessoas dos conceitos básicos, que explicam o que ela está usando. Uma pessoa jovem usa hoje com certa facilidade um computador com interface gráfica (GUI) e pode perfeitamente não ter a mínima noção do que é, por exemplo, “salvar um arquivo”, e por que isto tem que ser feito. Existe aí claramente uma contradição entre tornar o computador “fácil de usar” e a ausência de formação de base de uma tecnologia de tamanha complexidade. E este raciocínio se aplica a tudo que a gente usa.

Sem querer ser mago, eu diria que caso a formação de base não se modifique nas escolas do ensino fundamental, corre-se o risco de se ver gerações de usuários semianalfabetos ou iliteratos no que concerne à tecnologia de qualquer coisa. Uma das consequências deste erro pedagógico é o emprego sistemático da receita de bolo, isolando a pessoa em um mar de ignorância, no qual ela terá dificuldades de nadar.

Quanto aos insatisfeitos, o sentimento que me sobra é o de lamentar que muito dos avanços conquistados não tenham sido percebidos com a devida atenção ou complacência, mas cabe a cada um a liberdade de decidir o que é melhor para si. E por isto, não há nada que se possa fazer, a não ser esperar que um dia as pessoas descontentes mudem de opinião por conta própria. [Webinsider]

Paulo Roberto Elias

Paulo Roberto Elias é professor e pesquisador em ciências da saúde, Mestre em Ciência (M.Sc.) pelo Departamento de Bioquímica, do Instituto de Química da UFRJ, e Ph.D. em Bioquímica, pela Cardiff University, no Reino Unido.

8 respostas

Andre Felipe,

Acho também que foi um erro colossal o virtual abandono das especificações do DVD-Video, que previa a transcrição da master em 96/24. Existe fidelidade neste tipo de PCM para uma filtragem melhor, mesmo em equipamentos bem mais antigos.

A única solução hoje em dia é você dar a sorte de achar um download com conteúdo a 96/24 e dar a ele o destino que lhe interessar: disco, flash-drive, streaming, etc.

O resto é por conta do seu equipamento de reprodução. Quanto mais robusto e veloz, e com caixas decentes, maiores são as chances de você ouvir ouvir boas transcrições em PCM ou DSD, quando elas estão disponíveis.

Concordo inteiramente com sua opinião, que na época do lançamento do CD este usurpou muito rapidamente o lugar do LP o que irritou aqueles audiófilos tradicionais. Não vejo nada melhor no horizonte hoje que um arquivo hd de 96 K . Infelizmente não há um suporte único, digo, mídia física, que o represente a preço popular como era o CD ou LP. Talvez por isso esteja havendo este revival de vinil por um setor jovem do público, que anseia por um suporte que represente seu gosto musical e que seja colecionável. É uma espécie de saudade de algo não vivido.

Oi, Andre Felipe,

Eu só poderia te dar uma opinião baseado na minha experiência como ouvinte: possível até é, mas por questões meramente subjetivas, porque as limitações do ambiente analógico são bastante óbvias. Em tese, o som de um Lp tem tudo para dar errado, independente da cápsula que você usa.

Uma coisa que me causou estranheza quando o CD saiu, e poucos de nós tínhamos acesso a um disco, foi que a carga contra daqueles que tiveram acesso naqueles dias era algo incompreensível. Eu, por acaso, conhecia um dos técnicos de manutenção da antiga Rádio JB, que me convidou para escutar um CD logo que saiu. A JB importou um Sony CDP-101, aquele mesmo com filtro de barreira, e que deveria soar super mal, e no entanto no estúdio ele soou muito bem. Anos depois, eu ouvi este mesmo player na casa de um amigo, com um equipamento de referência, e o resultado foi o mesmo.

Houve um momento em que eu me dei conta de que grande parte daquela raiva contra o CD nada mais era do que a turma que gastava fortunas com cápsulas esotéricas e que não gostou da “popularização” de um front-end infinitamente mais barato e com melhor qualidade. Ou seja, acabou o status quo.

O áudio é para ser apreciado, e não deveria ser usado para competição ou disputa de ego. O bom áudio, analógico ou digital, deve ser reconhecido pelos seus méritos ou virtudes. Dependendo do tipo de música que você ouve, é bastante possível que as melhores gravações nunca tenham visto a luz do dia em ambiente digital.

E não é este senão o motivo pelo qual eu venho me batendo que para se ter um som digital decente da master analógica não se pode usar equipamento de transcrição que acabe filtrando os méritos destas fontes. Infelizmente, na ânsia de fazer um CD soar igual ao Lp, é o que os estúdios mais fazem. E se algum dia você entrar em um estúdio e pedir para ouvir uma master analógica de primeira geração bem gravada, se dará conta de que você nunca ouviu um Lp na sua vida soando daquela maneira!

Finalmente, eu nunca usei, mas tive muitas chances de ouvir sistemas esotéricos, alguns soando mal outros muito bem. Estes últimos têm inegável mérito, mas a relação custo/benefício é fantasiosa. De dependesse de mim exclusivamente, eu jamais gastaria hoje um centavo do meu bolso para investir em um sistema desses!

Fiquei curioso Paulo Elias; afinal você acredita que o som de um vinil pode ser melhor do que o digital? Minha experiência nos anos 80 com vinil diz que não, mas também eu usava toca-discos baratos. É mesmo possível obter um bom som do vinil se usado um toca-discos calibrado, com contrapesos e mecânica aprimorada ou isso é mito?

Tresse,

O Zuse de fato tinha um ajudante, me parece um colega e amigo. E agora que você mencionou o Schreyer, eu acho que era ele mesmo.

Foi a esta pessoa que o Zuse teria afirmado o desejo de trocar relés por válvulas, inclusive, segundo ele mesmo afirma em uma entrevista antiga para a BBC.

Oi, Nolan,

Acho muito difícil, mas nunca se sabe o dia de amanhã.

Muito bom,Paulo.Teu livro em breve ganhará um segundo tomo!

Parabens

Paulo, como sempre leio seus textos e sempre aprendo algo com êls. NÃO PARE DE ESCREVER. Agora você falou na evolução dos Computadores, citou o Suze, mas eu não vi o nome do Helmut Theodor Schreyer. Pelo que sei êle é um dos pais dos nossos atuais computadores? Estou certo nisso?