Nós estamos atravessando uma fase na linha do tempo em que as calibrações de telas de TV não são radicalmente necessárias como fazem entender os especialistas no assunto, e por um motivo muito simples: as TVs saem de fábrica com os pré-ajustes necessários, capazes de atender a todo tipo de consumidor.

O aperfeiçoamento dos pré-ajustes aumentou mais ainda com o advento das telas com 4K (2160 linhas) de resolução. E chegou a um momento interessante, com a necessidade de tornar a tela de TV de ser capaz de reproduzir HDR com 10 bits de resolução de cor na imagem.

Eu creio, salvo melhor juízo, que ninguém precisa me explicar a importância que tem um processo de calibração, porque eu passei anos da minha vida profissional tendo que alinhar equipamentos de medida espectrofotométrica, usados em análise espectral ou de determinação da concentração de substâncias em solução.

Na década de 1970, o nosso departamento tinha em seu poder um espectrofotômetro Cary modelo 118C, comprado por sugestão de um colega já falecido, que era um dos melhores jovens cientistas que eu conheci naquela época. Este equipamento era tão avançado que nós recebíamos visitas de outros colegas, alguns que vieram do Centro de Pesquisas da Petrobras, para ver o que aquele “Rolls-Royce” era capaz de fazer. E, no entanto, devido a limitações eletrônicas da época, para se levantar um espectro de absorção como se devia, era preciso antes alinhar toda a linha de base da faixa espectral manualmente.

Da mesma forma, as antigas TVs de retroprojeção necessitavam ajustes de convergência e crominância constantemente. E nesta época, que eu me lembre, os técnicos trabalhavam com valores elétricos de componentes descritos nos manuais de serviço. Eu nunca vi ninguém usar algum tipo de fotocolorímetro para calibrar uma TV daquelas.

As TVs de tubo eram terríveis neste e em outros particulares, e um dos motivos era a forma como os cinescópios eram fabricados: nenhum deles era plano, até mesmo os anunciados como tal.

Fazendo hoje uma retrospectiva sobre os primeiros backlights de telas construídas com LCD, descobrimos que o espectro de emissão das fontes de luz fluorescentes de cátodo frio (CCFL) era perfeitamente capaz de iluminar a tela com ampla escala de cores, o que hoje perseguimos com o nome WCG (Wide Colour Gamut). Mas, as telas propriamente ditas eram muito ruins na construção do pixel e a eletrônica usada era um importante fator limitante.

Hoje em dia, a situação se inverteu: a estrutura do pixel LCD é exemplar, não importam as suas variantes (TN, IPS, etc.), e a eletrônica faz milagres na construção do bitmap da imagem final!

Limitação dos calibradores

Calibradores custam caro, não são simples de usar, e exigem um conhecimento prévio do que se está ajustando. O uso de calibradores faz muito sentido no uso profissional de técnicos especializados, ou de usuários preocupados com a qualidade da imagem, como por exemplo, em fotografia ou cinema.

Existem vários tipos de calibradores no mercado, e até onde eu tenha percebido, nenhum fabricante dá detalhes sobre a veracidade dos resultados obtidos. Monitores de referência são citados, mas isso pode não ser a referência que se quer obter em algum uso específico.

Aqui é preciso abrir um parêntese, para explicar as diferenças em resultados que nos interessam: no laboratório de análise, por exemplo, os métodos usados podem ser precisos, mas não necessariamente exatos.

Um método é classificado como “preciso” quando medidas repetidas de uma mesma amostra dão sempre o mesmo resultado. Isso é muito importante em clínica médica, ao se analisar um estado de doença. É possível estudar qualquer doença com um método preciso, bastando comparar resultados com o uso de testes de estatística, tendo ao alcance populações de pacientes confiáveis e que não são portadores daquela doença, o chamado grupo controle.

Em contrapartida, um método de dosagem é reconhecido como “exato” quando todos os valores medidos refletem a concentração real da substância estudada.

Se eu comparar grupos de pacientes com um método preciso mas não exato eu não estarei errando no diagnóstico, desde que o método seja sempre o mesmo. Existe de fato um erro, mas ele se torna um erro sistemático, por força da comparação.

Se nós transportarmos estes conceitos para a tela de TV, poderíamos afirmar com segurança que uma tela pode ser precisa, mas não necessariamente exibindo uma imagem próxima da real.

Na realidade, é muito complicado, talvez impossível, se obter uma “imagem de referência”. Seria preciso estar na frente da imagem capturada, para então observar como ela aparece na tela analisada.

Nas emissoras de televisão, isso é feito o tempo todo, mas e quanto aos usuários domésticos?

A calibração sem calibradores

Eu me arrisco ao prognóstico de que talvez a maior parte dos usuários domésticos pouco se importa se a imagem que ele ou ela estão vendo é real ou apenas visualmente atraente, e provavelmente é neste último aspecto que as telas de TV são julgadas boas ou ruins.

Vale a pena mencionar que para ajustar uma tela de TV os dois requisitos básicos são os controles de brilho (“Brightness”) e de contraste (“Contrast”), muitas vezes chamado de “Picture”. Esses dois controles estipulam aproximadamente o nível máximo de preto e de branco, respectivamente, ou seja, a diferença na faixa de exibição de toda a escala de cinza. Os dois controles têm enorme influência sobre a reprodução correta das cores e, portanto, devem ser feitos antes de qualquer outro ajuste.

Ao fazer os ajustes de brilho e contraste é preciso desligar todos os recursos de aprimoramento de imagem, particularmente qualquer coisa com o nome de “contraste dinâmico”.

O teste do fórum da AVS, chamado de AVS HD 709, pode ser baixado em diversos formatos, gratuitamente. No YouTube existem tutoriais de como usar. Para o leitor ter uma ideia de como funciona, basta dar uma olhada no vídeo abaixo:

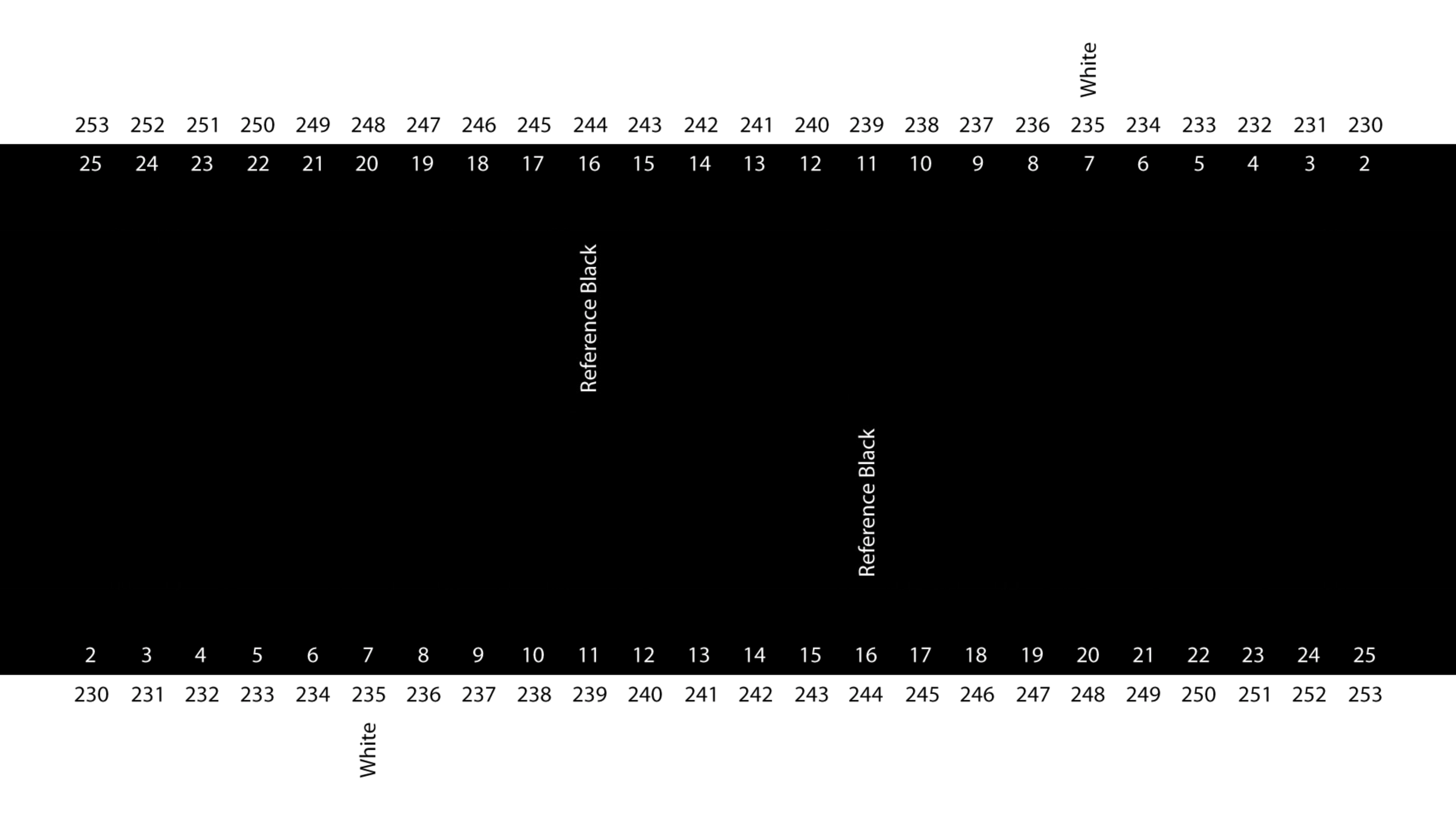

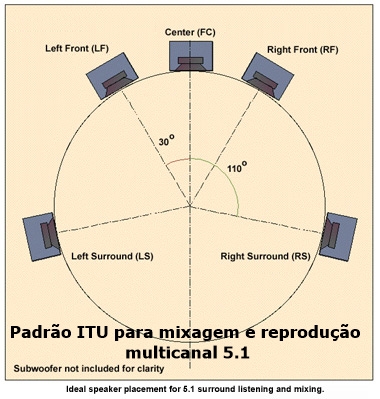

As telas de ajuste de preto (brilho) e de branco (contraste) delimitam as áreas de distorção (“clipping”) para o preto e o branco, na forma de pulsos de luz. Para o nível de preto (ajuste de brilho) o limite é 16 e para o de branco o limite é 235, ambos assinalados na figura abaixo.

Nem toda tela de TV permite usar estes ajustes. Algumas pulsam todas as barras no ajuste de contraste, tornando a calibração impossível.

Não podendo recorrer a um teste deste tipo, pode-se partir para os antigos macetes usados há décadas: um deles, consiste em colocar o ajuste de brilho no meio da escala, e o de contraste no máximo. Depois, com o uso de uma imagem conhecida, ir descendo o ajuste de contraste, até que a imagem fique sem níveis de branco exagerados. O ajuste do contraste, se excessivo, é capaz de obliterar as zonas de sombra, a ponto de não permitir a visualização de detalhes. Em algumas telas, entretanto, o ajuste ao máximo já vem de fábrica, e neste caso, deve-se observar os resultados com mais cuidado, porque muitas vezes é o ajuste correto.

Depois de ajustados brilho e contraste, é preciso acertar a cor, novamente sem qualquer controle de aprimoramento acionado. São várias as TVs que deixam o usuário desligar os sinais RGB individualmente e deixar somente um operando. Normalmente, deixa-se a emissão de azul funcionando e desligam-se as outras. Neste modo de operação, pode-se recorrer ao padrão do disco da AVS, mas se este não estiver presente, recorre-se a um padrão de cores com intercalação de azul (a Internet tem este tipo de quadro, que pode ser baixado em jpeg e reproduzido na TV, se for possível). Aí, se tudo deu certo, é só comparar visualmente os níveis de azul perante as outras barras de cor do padrão. Alguns discos de calibração enviam óculos com um filtro de cor azul que pode ser usado sem desligar a emissão de cores.

Não é possível neste espaço ir muito adiante neste assunto. É suficiente dizer que o ajuste de gama, que as melhores TVs todas têm, afeta a escala de cinza e a reprodução das cores. Se o usuário não sabe usá-lo é preferível mudar a escala observando o resultado ou então deixar o ajuste no meio da escala.

Além deste ajuste, o de temperatura de cor também afeta demais a qualidade da imagem. Na maioria das vezes, nem gama nem temperatura têm escala que diga algo de útil. Neste caso, procura-se ajustar para cores mais “quentes” (que puxam para o vermelho), ao invés de cores mais “frias” (que puxam para o azul), mas é preciso tomar cuidado para não alterar a escala sem antes passar um tempo para acostumar a vista.

Tenha em mente que telas com profusão de tons azulados costumam cansar a vista, e devem ser evitadas.

Alguns mitos que podem ser derrubados

A imagem exibida gloriosamente em uma TV moderna pode não ser o espelho de uma imagem real ou fiel às origens da captura. Na realidade, a maioria dos aparelhos embeleza ou aprimora uma imagem, na tentativa de “aumentar a realidade”, mas na prática este aprimoramento realça detalhes da imagem fonte ao invés de torna-la mais “real”. Nos televisores antigos, a recomendação (correta, por sinal) era observar o rosto das pessoas, particularmente o tom da pele, que deveria ser o mais natural possível. Este ajuste de saturação de cor, embora grosseiro, funcionava razoavelmente. Nas telas atuais, é raro se ver tom de pele adulterado, a não ser que o usuário o faça propositalmente e, portanto, continua ser um parâmetro interessante no julgamento se a imagem está correta ou não.

Realidade é outra coisa, e acho difícil uma imagem ser “real”, inclusive nos exemplos com HDR, que se propõem, entre outras coisas, ser mais “real” do que a imagem convencional. Em uma tela com imagem bem calibrada, o que se quer é evitar o mínimo de intrusão na adulteração da imagem original. Por exemplo, eu quero assistir “The Matrix” como foi filmado, então eu não devo permitir que a TV destrua o matiz esverdeado da imagem como foi filmada. Em outras palavras, dentro do possível a imagem calibrada tem que ser “neutra” ou não realçar nada. Muitos conhecidos meus preferem não usar nenhum controle de aprimoramento de imagem justamente por causa disso.

HDR em fotografia nada mais é do que a combinação de capturas com exposição diferente, com o objetivo de aumentar a faixa do nível de exposição, em última análise da capacidade do sensor da câmera em capturar detalhes nas fotografias. Na TV, HDR tem um significado um pouco diferente, que é a procura de aumentar a distância dos níveis de luminosidade que a tela pode atingir. Em TVs mais novas a diferença entre os níveis de preto e de branco aumentou significativamente. Assim, o que uma imagem HDR objetiva é fazer o máximo uso em dinâmica de brilho, para aproveitar esta diferença.

Não existe esta coisa de imagem “film like” (parecida com cinema) como objetivo de conseguir calibrar uma imagem e considera-la perfeita para a reprodução de filmes. Os diretores de fotografia abusam do direito de usar filtros de tudo quanto é tipo, e por incrível que pareça, com o advento da filmagem digital eles se esforçam para ajustar as câmeras para emular a cinematografia convencional, ou seja, continuam aplicando filtros.

Filtros foram (e ainda são) classicamente usados na confecção da chamada “noite americana”, conhecida também pelo termo em inglês “day for night” (o dia pela noite): os planos são filmados durante o dia, com sol a pino, mas o filtro joga um tom azulado na imagem, como se o dia fosse noite.

Então, é quase impossível ter uma referência do que seria uma “imagem de cinema” em uma tela de TV. Quando a gente conhece muito o filme, pode-se se dar ao luxo de ajustar a TV para o mais próximo possível da imagem originalmente vista na tela do cinema.

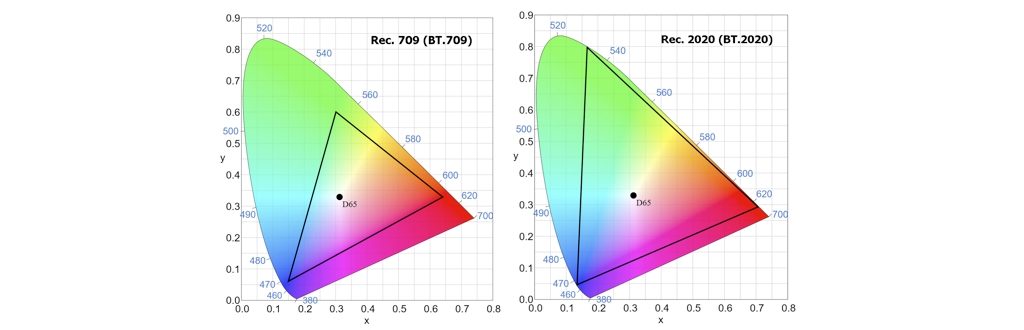

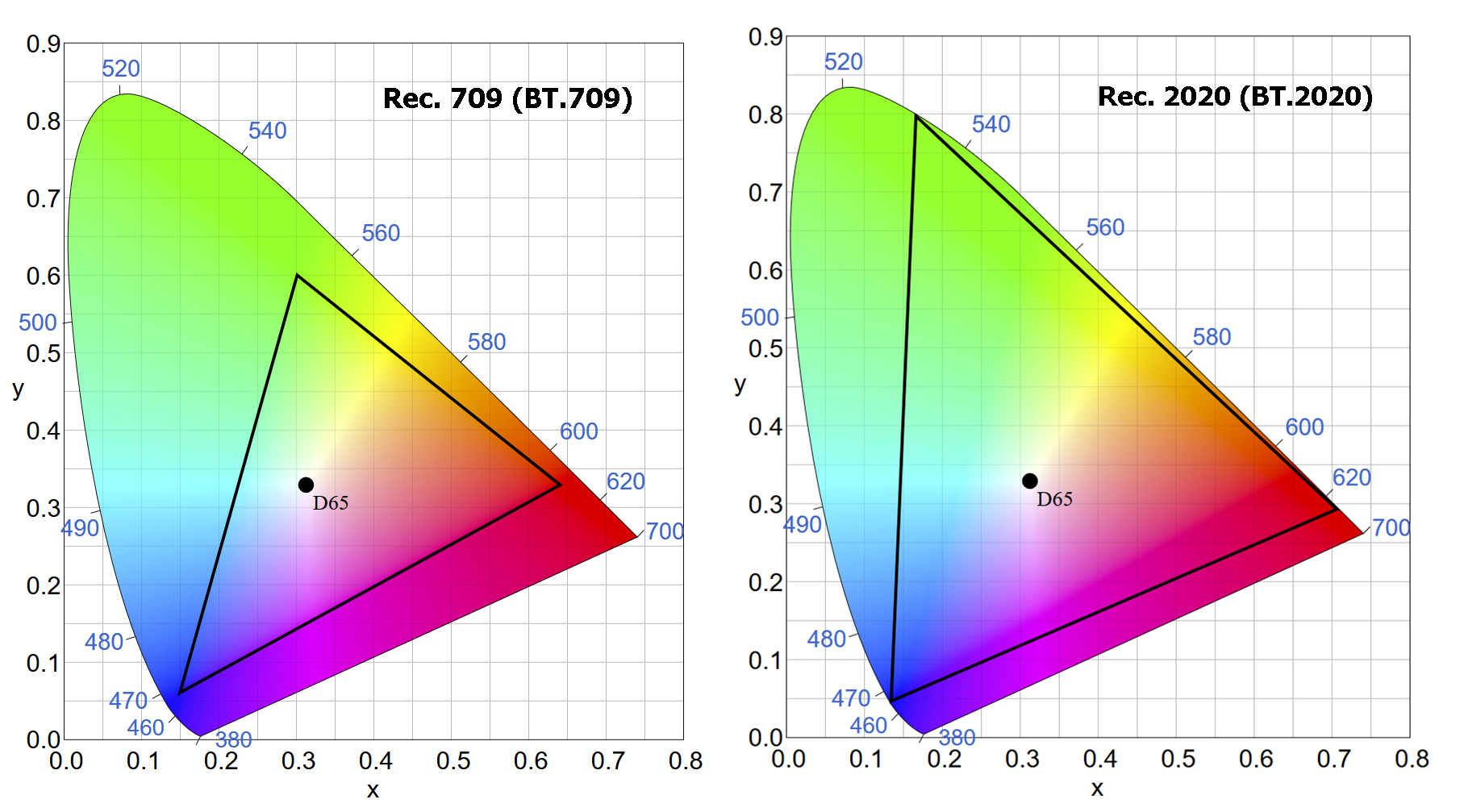

Os padrões de imagem para o que se chama de HDTV incorporam uma escala de cores (“Colour Gamut”) chamado de Rec. 709 ou BT.709. A escala propõe a posição exata do ponto D65 (ou D650), que é o tom da luz branca ao meio dia. Entretanto, nota-se que a escala em si tem extensão relativamente limitada. Tanto assim, que para o padrão UHD a escala foi mudada para o chamado BT.2020:

Veja com atenção as pontas mostrando os vértices dos triângulos dentro da ferradura gráfica que descreve o espaço de cores CIE 1931: o ponto superior revela o ponto máximo de alcance da cor verde, o da esquerda, o da cor azul e o da direita o da cor vermelha. A distância entre eles dá uma ideia gráfica da extensão da reprodução de cores de uma determinada escala de cor. A distância entre os vértices e o D65 dá uma ideia de quantos tons de cor são teoricamente possíveis com cada escala de cores.

A diferença de escala entre ambos é enorme, entretanto quando existe um ajuste para Rec. 709 ou sRGB em separado, nota-se que a imagem vinda de um Blu-Ray player convencional ou das emissoras de TV ou por assinatura é significativamente melhor do que pelo ajuste em Rec. 2020. Motivo: a fonte da maioria dos programas é feita com Rec. 709, com todas as possíveis limitações de cor. E se isso não bastasse, o sRGB (praticamente idêntico ao Rec. 709) é a base na qual quase todas as imagens divulgadas on-line, em fotografias ou cinema são realizadas.

E a pergunta que fica no ar é: seria possível ver de fato esta diferença de escala?

Se o usuário conseguir ao menos acertar o ponto onde fica o D65 (ou D650, mostrada na imagem acima) ele terá certeza de que a escala de cores está correta, ou próxima do que deveria estar. Normalmente, o ajuste para chegar lá é acertar a temperatura da imagem na TV, muitas vezes colocando em “Quente”, ao invés de “Normal” ou “Frio”.

Muito poderia ser dito aqui como calibração de imagens de TV, mas eu prefiro acreditar que grande parte dos usuários irá usar os pré-ajustes do fabricante e não há nada de errado nisso. Um desses pré-ajustes, constantemente recomendados por analistas, é o do modo “Movie”, ou “Cinema”, porque normalmente quem desenha a tela na fábrica joga no ajuste uma imagem mais próxima do D65 e do ponto de gama ideal para aquela tela.

No final, o que importa mesmo é a satisfação com o que se está vendo. Usuários avançados irão fuçar todos os ajustes, para saber concretamente o que pode se esperar deles ou lançarão mãos de calibradores ou discos afins. Outros irão seguir religiosamente os ajustes propostos por analistas, enquanto que a maioria não passará nem perto deste tipo de preocupação.

Se alguém me perguntasse se calibrar vale a pena, eu não hesitaria dizer que sim, nem tanto pelos métodos com medidores, que podem não ser exatos, mas com os critérios brevemente expostos acima. Em última análise, pode-se aproximar a imagem na tela do que foi pretendido por quem a gerou, e isso já é um grande avanço. [Webinsider]

http://br74.teste.website/~webins22/2016/11/08/hdr-no-computador-de-mesa/

. . . . .

Leia também:

- HDR e pontos quânticos em busca da TV perfeita

- Pontos quânticos

- Fabricantes de TVs com HDR abandonam o suporte a 3D

- HDR avança nas telas de TV feitas no Brasil

- Mais textos de Paulo Roberto Elias

http://br74.teste.website/~webins22/2016/11/01/alternativas-inovadoras-para-a-iluminacao-de-telas-lcd/

Paulo Roberto Elias

Paulo Roberto Elias é professor e pesquisador em ciências da saúde, Mestre em Ciência (M.Sc.) pelo Departamento de Bioquímica, do Instituto de Química da UFRJ, e Ph.D. em Bioquímica, pela Cardiff University, no Reino Unido.