Os computadores poderosos do passado foram paulatinamente substituídos por máquinas de capacidade de integração antes inimaginável.

A obsolescência é uma decorrência natural da superação de métodos tecnológicos desenvolvidos anteriormente, e que são depois suplantados pela perda de eficiência ou versatilidade.

E a informática está cheia de exemplos deste tipo, mas só quem pode testemunhar isso foram os que se envolveram com o início da microinformática e com a mudança das plataformas, ao longo do tempo.

Antes disso, no áudio já se tinha visto muita coisa nesta direção, como por exemplo, as fitas de rolo substituídas por fitas cassete, o elepê substituído pelo CD, e vai por aí. Mas, foi na informática que máquinas antes consideradas revolucionárias caíram em desfavor pelo usuário em espaço de tempo muito curto.

Antes da microinformática explodir, os chamados mainframes, verdadeiros armários que ocupavam uma sala toda, ainda prevaleciam. Nesta época teria sido difícil imaginar a miniaturização de hardware e mídia, que pudesse substituir a potência de processamento conseguida até então.

Mas, foi com a adesão de entusiastas e jovens programadores, que viram nos microprocessadores uma possibilidade real de que isto fosse possível, que a microinformática foi aos poucos saindo de uma caixa preta para um computador que qualquer um pudesse usar. E isso foi só o início!

Dos 8 aos 16 bits, sem traumas

Em microcomputadores de 8 bits, a memória RAM usava 64 kbytes para rodar o CP/M, um sistema operacional de disco, desenvolvido por Gary Kildall, homem que perdeu a chance de ficar rico, ao deixar nas mãos de Bill Gates o seu desenvolvimento para o sistema operacional das plataformas IBM.

Por causa disso, o MSX-DOS, versão resumida do MS-DOS, era capaz de rodar qualquer programa CP/M, como dBase, SuperCalc, etc. Além disso, arquivos de texto ou aqueles obedecendo aos códigos ASCII, também migraram do MSX-DOS para o MS-DOS sem erro de leitura pelo sistema.

Como se pode perceber, 64 kbytes de RAM é uma quantidade irrisória de memória. Na época, com dois drives 5 ¼” era possível rodar dBase, por exemplo, sem perder dados, porque os discos eram automaticamente usados para salvar informações daquele tipo de banco de dados.

Pensando bem, era uma solução genial: um disquete rodava o programa, o outro armazenava dados na mídia. Com isso, nada era perdido.

No Brasil, as máquinas de 8 bits ainda duraram bastante tempo à venda no mercado, e nós inclusive pagamos um preço alto pela famigerada lei de reserva da informática, resquício pseudo protecionista dos regimes militares, que ainda durou muito tempo.

Tudo no início era muito difícil, um caminho penoso de se trilhar. Eu terminei o meu curso de programação no Núcleo de Computação Eletrônica da UFRJ em 1984, quando eles lá desenvolveram um computador de 8 bits, que usava disquetes flexíveis de 8 polegadas, já obsoleto. A intenção deles era a de fabricar e vender este computador, mas o projeto não foi adiante.

Para nós, alunos, a única coisa que nos restou foi aprender CP/M, decorando aquelas chaves tipo <control> + C, <control> + V, <control> + X, <control> + H, etc., que se pode usar em ambiente Windows até hoje. E, sim, aprender a usar um disquete, que nos foi útil em anos subsequentes.

Ainda em 1984, o colega professor da Matemática que nos deu aula não tinha plena certeza de que as rotinas escritas por ele no quadro iriam funcionar, e ele nos dizia, brincando, para a gente testar no laboratório. Aquela tecnologia era quase inexpugnável para quem era incipiente, o computador uma autêntica caixa preta.

O primeiro desses cursos do NCE foi destinado aos professores. Dos mais de 50 colegas inscritos, na segunda semana só sobraram pouco mais de 20. Logo na primeira aula, eu ouvi colegas do Centro de Ciências da Saúde me dizerem que nunca iriam conseguir aprender aquilo. E como o curso incluía três trabalhos e uma prova, aqueles colegas pularam fora! E eu nunca os culpei, porque a informática apresentada a nós leigos era obscura por natureza!

Logo de cara, ficou claro que quando os microcomputadores começaram a ser usados, quem quisesse ser usuário teria que aprender programação, daí o enorme esforço de quem não era da área. Os visionários que perceberam isso foram aqueles que começaram a escrever e depois vender programas aplicativos para qualquer tipo de usuário. Mas, em alguns casos, a curva de aprendizado ainda era íngreme e os comandos complexos, o que continuou a forçar os usuários finais a fazer outros cursos, para poderem usar aplicativos.

Eu, que, por força da pressa em avançar no domínio de muitos programas, fui autodidata por anos a fio, tive que fazer cursos de vários aplicativos, para poder ter um título capaz de provar no curriculum vitae que eu era capaz de usá-los.

Os cursos eram dados por técnicos, e eu então tomei o cuidado de conversar com eles, mencionando os meus objetivos curriculares. Havia, é claro, um constrangimento implícito. Em um dos cursos, sobre planilha, um deles chegava a se dirigir a mim dentro da sala de aula, para perguntar se o comando que ele estava escrevendo não tinha erro.

Ao final da década de 1980, os computadores de 16 bits “fabricados” (leia-se “montados”) no Brasil eram notoriamente dirigidos para um público de maior poder aquisitivo. Eu me lembro de estar em uma feira de informática, com meu irmão e um amigo, quando vimos o lançamento de um micro com 256 kbytes de memória RAM, que custava uma fortuna! Os hard drives da época, com tecnologia MFM, eram caros e ruins! Assim, o custo dessas máquinas exigiria constante manutenção e despesa.

Por causa disso, muita gente continuou a usar 8 bits, não só usuários domésticos, mas programadores montando sistemas com linguagens tipo dBase, por exemplo.

Eu nunca tive poder aquisitivo no início para migrar para as plataformas de 16 bits, mas, tendo que viajar para a Grã Bretanha, enfrentei uma outra realidade, porque lá os micros de 8 bits não eram mais vendidos, e com razão. A minha sorte foi a de que o MSX me permitiu levar meus disquetes de 5 ¼” e conseguir lê-los nos drives de 16 bits, rodando em ambiente MS-DOS, do qual o MSX-DOS fora criado.

Para esta adaptação bastava aprender uns comandos a mais. Meu primo e sua família, que estavam morando em Warwick para o doutorado dele, já havia comprado um segundo micro e me vendeu o antigo. Foi assim que eu me virei em casa. No trabalho, o que nunca faltou foram computadores dentro dos laboratórios.

A mudança dos sistemas operacionais e aplicativos

Eu fiquei surpreso ao constatar que no ambiente de trabalho em Cardiff um número enorme de professores não havia se dado ao trabalho de estudar informática, alguns se tornaram usuários incipientes, pedindo ajuda a todo momento, outros, como um dos meus orientadores, não queria nem chegar perto de um computador. Por causa disso, eu me dispus a orientar os meus colegas alunos de doutorado que enfrentavam eventuais dificuldades no uso de aplicativos.

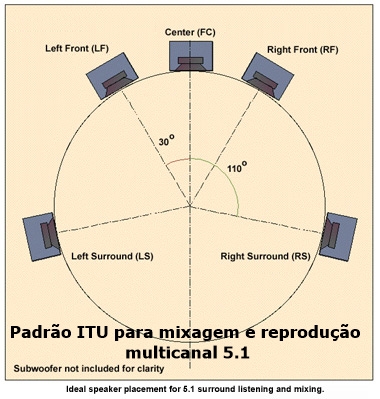

Nós ainda rodávamos tudo em ambiente MS-DOS, e alguns aplicativos ainda trabalhavam com comandos na linha do prompt. O Windows 3.0 veio depois, mas continuou rodando DOS. Um dos meus orientadores, que não usava um computador pessoal, precisava prestar conta em contratos que ele tinha com a indústria farmacêutica, e como ele me ajudou muito no desenvolvimento da minha tese eu o ajudei também, ensinando os seus assistentes a montar planilhas e gráficos, colocando os resultados em um arquivo de texto, em ambiente Windows usando um recurso chamado de OLE (Object Linking and Embedding).

Isto dinamizou o trabalho de todo mundo. Na época, este orientador, vendo os resultados assim obtidos, me pediu para mandar comprar uma impressora a laser, e aí os relatórios ficaram impecáveis! Em ambiente Windows a interface gráfica com o usuário teve finalmente expressão, bem como as impressoras deste tipo.

Os super computadores

Quando o Intel 80486 foi colocado no mercado, as revistas inglesas o chamaram de “The Dream Machine” (“A Máquina dos Sonhos”), um processador lançado inicialmente em computadores que custavam cerca de 7 500 libras!

Esta CPU jogou no lixo todos os processadores Intel anteriores, tipo 8086, 80286, 80386, da noite para o dia. Mas, logo depois aconteceu algo inesperado. Primeiro, os preços de componentes caíram; segundo, apareceram os montadores de computadores de mesa, que usavam uma arquitetura que depois viria se tornar padrão e ficou assim até hoje, que consistia em expandir a placa-mãe com componentes discretos, através dos slots inclusos na mesma.

Este tipo de montagem deu ao dono da loja a chance de escolher com o cliente que tipo de componentes ele poderia usar e o cliente conseguir comprar, sem precisar ficar com uma dívida impagável.

Entre um computador de marca e outro montado por uma loja daquele tipo a diferença de preço compensava amplamente o da loja, com a possibilidade de customizar a montagem. Alguns fabricantes de computadores de marca passaram também a fazer isso, instalando ou trocando componentes a pedido do cliente, mas os preços continuavam elevados!

O conceito de super computador, construído com o uso de múltiplos processadores na mesma plataforma operacional, migrou para a microinformática muitos anos depois, devido ao aparecimento de processadores dotados de mais de um núcleo de processamento. Por isso, tanto os 80486 quanto depois os Pentium ou similares foram destronados do rótulo de máquinas poderosas e eficientes. Na década de 1990 em diante, eu mesmo montei o meu computador doméstico, seguindo a receita dos lojistas lá de fora, escolhendo componentes e montando em casa. Na época dos Pentium, quando eu precisava editar áudio, a aplicação de algum filtro demorava alguns minutos. Com os processadores com múltiplos núcleos este tempo se reduziu significativamente.

No computador pessoal, em vez de mais uma CPU, que tornava a montagem cara, foram introduzidas uma única CPU com mais de um chiplet, unidade lógica independente dentro do mesmo processador, formando assim os núcleos de processamento necessários. No meu computador atual, a CPU AMD trabalha com 12 núcleos de processamento, cada um deles compartilhando memória, portanto seriam 12 “computadores” trabalhando ao mesmo tempo. Eu posso então dizer que tenho um super computador dentro de casa? Claro que não, porém eu consigo realizar as tão prometidas multitarefas do Windows, rodando múltiplas operações ao mesmo tempo, sem sobrecarregar a memória instalada e sem travar o sistema, mesmo com tarefas demandantes ou que exigiriam exclusividade de uso da CPU.

A ideia de coprocessamento, antes restrita a alguns poucos coprocessadores, se estendeu muito na arquitetura mais recente dos computadores de mesa. Mas, não é de hoje. Ela se estendeu para todos os componentes ativos, como GPU e CPU. A gente vê, todo dia, na Internet, máquinas caríssimas da década de 1990, tipo Silicon Graphics, que tinham uma performance fora de série para a época, mas não tinham a mesma capacidade.

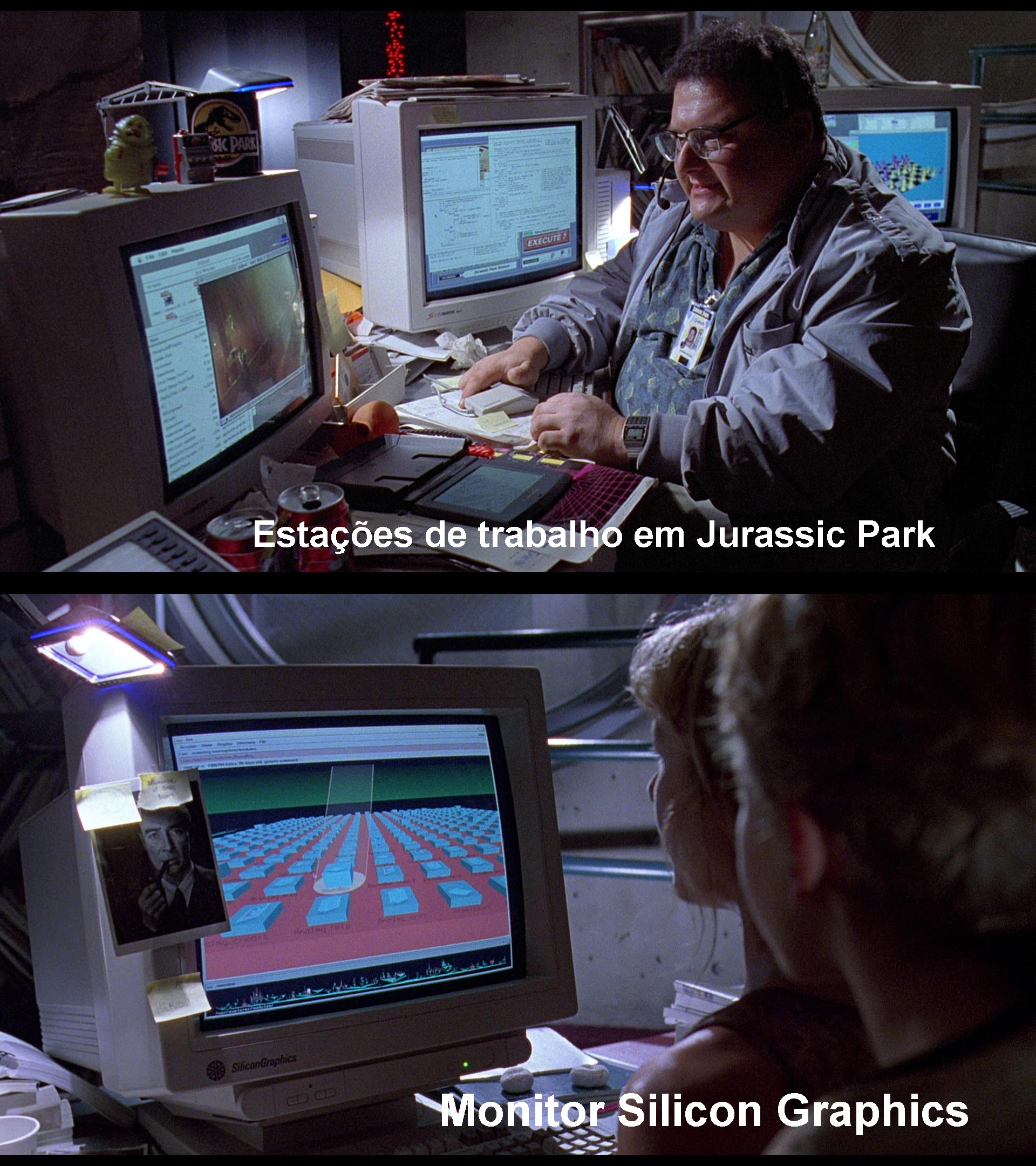

Vendo essas máquinas por dentro, a gente entende porque motivo elas eram tão caras. Quem nunca viu uma delas, mas assistiu ao filme Jurassic Park, vai notar várias estações de trabalho com computadores Apple e componentes Silicon Graphics um pouco mais discretos, que fizeram muito sucesso entre os entusiastas nesta época.

Fãs do filme conseguiram ver nos cantos das imagens os modelos Silicon Graphics Iris Indigo e Crimson. Um monitor Silicon Graphics, modelos que na década de 1990 já tinha entrada RGB e era usado para modelagem molecular no campo científico, pode ser visto em uma das cenas do final do filme:

O preço de um computador Silicon Graphics usado hoje, não dá nem ideia de como eles eram caros na década de 1990. E hoje, com o efeito implacável do avanço da tecnologia, essas máquinas maravilhosas, que rodavam programas gráficos de renderização de qualquer coisa, ficaram totalmente obsoletas.

Afinal, o que diabos é um “PC Gamer”?

Entre todas as classificações sem sentido que eu já vi, esta aí bate o recorde. Primeiro, porque a expressão “PC Gamer” está enunciada de forma errada: se fosse em língua inglesa teria que ser o contrário, “Gamer PC” (PC para jogador); segundo, se fosse em duas línguas deveria ser composta como “PC para Gamer”, e não “PC Gamer”.

Seja lá como for, o significado do que é um computador para jogadores é muito vago. Vejam, por exemplo, em uma matéria de um jornal paulista: se alguém ler com cuidado o jornalista está na verdade dizendo que o jogador deve construir ou comprar um computador de alta performance, no pressuposto de que para rodar um jogo é preciso ter muita potência de processamento. Mas, não me parecem claramente delimitados os limites do mínimo requerido para alcançar tal objetivo.

Historicamente, quando um usuário final monta um PC e vai escolher componentes, a primeira coisa que ele pensa é na relação custo/benefício, e para isso é necessário saber a quê o computador se destina. E nem sempre o componente mais caro irá fazer grande diferença, dependendo da carga de uso da máquina. E é por isso que, se um determinado projeto específico for planejado, o montador deve ter noção do desempenho mínimo de cada peça, o que nem sempre é fácil.

E então, qual é o mínimo de desempenho para se classificar um computador como “PC Gamer”? Estas especificações não aparecem claramente na mídia, porque na realidade, tudo se resume a uma campanha comercial, para vender componentes. Há anos que os fabricantes de placas gráficas e principalmente de CPUs se balizam em desempenho em jogos, para poder afirmarem que o seu novo produto é melhor!

O que eu vejo mesmo é que a única forma de se poder classificar uma máquina como destinada para jogos é ver como os consoles do tipo Xbox ou Play Station são montados, porque eles são, na realidade, computadores dedicados para este fim. Só que não faz muito sentido desmontar um console desses para identificar componentes, até porque muitos são proprietários. Se alguém quiser montar um computador para jogar somente, existem pilhas de processadores e placas gráficas que possibilitam rodar qualquer coisa nesta direção.

Entre a obsolescência e a inutilidade

Com a proliferação dos chamados “Apps”, programas que qualquer um pode instalar em um celular ou tablet, a era dos computadores super potentes chegou ao fim, ficando restrita aos fãs ou entusiastas, ou àqueles que tem uma demanda média ou alta de carga de trabalho.

Sinceramente, não é mais concebível imaginar como a gente rodava DOS com 64 kbytes de RAM, ou salvava arquivos em fita cassete ou discos flexíveis. Eu perdi muitos amigos nesses últimos anos, que compartilhavam suas experiências em montagem comigo, mas bem antes disso eles já tinham capitulado em montar uma máquina mais nova, porque as últimas já sobravam em capacidade de processamento bem maior do que delas era exigido.

Eu, felizmente e por sorte, estou no grupo dos que não podem se queixar. Com o esforço desprendido em tempos mais áridos, eu consegui programar ou usar recursos que muito me ajudaram no trabalho de pesquisa. Há muito tempo eu não preciso mais fazer isso.

Hoje, como aqueles meus saudosos amigos, posso me dar ao luxo de ser um mero observador do que vem por aí e usar o que for necessário. Talvez, a minha maior recompensa foi a de ter sido testemunha deste avanço e de ter aprendido muita coisa útil que me ajudou a atravessar as décadas de uso contínuo com produtividade.

Quanto aos demais usuários, a maioria dos que eu conheço não viveu e nem quer saber do que aconteceu em todas essas etapas, e quem irá culpa-los disso, se tudo o que eles precisam ou querem está por aí, ao alcance e prontamente disponível? Outrolado_

. . .

Paulo Roberto Elias

Paulo Roberto Elias é professor e pesquisador em ciências da saúde, Mestre em Ciência (M.Sc.) pelo Departamento de Bioquímica, do Instituto de Química da UFRJ, e Ph.D. em Bioquímica, pela Cardiff University, no Reino Unido.

0 resposta

Ótima matéria Paulo, ainda mais se aproveitarmos o gancho e citar o descaso do Governo Federal que optou por adotar um “pseudo” supercomputador chamado de Egeon, (em substituição ao mainframe Tupã), causando limitação no potencial de fazer previsões climáticas a longo prazo, ao contrário do Tupã do INPE que dispunha dessa capacidade. O governo achou melhor “sucatear” o mainframe Tupã no final de 2021, e comprar outro (Egeon) “menos poderoso” em seu lugar. Tudo pensando na “economia”, mas para conceder um pacote de benefícios em ano eleitoral, neste quesito não existe problema de caixa. Difícil aceitar essas coisas…

Oi, Rogério,

Também acho. Eu não sei se você sabe, mas o atual governo continua a política do seu antecessor de sucatear a universidade pública e os salários de que nelas trabalham. Na época da ditadura, que eu vivi na década de 1970, houve muito investimento na compra de novos equipamentos, escolhidos pelo corpo docente. Eu fiz a minha tese de mestrado com um desses equipamentos, escolhido por um colega meu, aliás químico brilhante, e que faleceu em um acidente, e nem pode aproveitar aquilo.

É uma tremenda ironia ter visto governos de força investirem na ciência, e depois assistir os seus pares “democráticos” entrarem na vida pública com ódio da academia. Tudo na vida acadêmica mudou para pior, e quanto mais o tempo passa mais será difícil reconstruir o que já foi e ainda será perdido.

Eu não tenho mais quase contatos depois que me aposentei, mas leio nos jornais que a atual reitora da UFRJ já avisou que se as verbas de manutenção continuarem escassas, a UFRJ vai fechar as portas! E eu não duvido que esta declaração seja realista.

Ótima matéria Paulo, ainda mais se aproveitarmos o gancho e citar o descaso do Governo Federal que optou por adotar um “pseudo” supercomputador chamado de Egeon, (em substituição ao mainframe Tupã), causando limitação no potencial de fazer previsões climáticas a longo prazo, ao contrário do Tupã do INPE que dispunha dessa capacidade. O governo achou melhor “sucatear” o mainframe Tupã no final de 2021, e comprar outro (Egeon) “menos poderoso” em seu lugar. Tudo pensando na “economia”, mas para conceder um pacote de benefícios em ano eleitoral, neste quesito não existe problema de caixa. Difícil aceitar essas coisas…

Oi, Rogério,

Também acho. Eu não sei se você sabe, mas o atual governo continua a política do seu antecessor de sucatear a universidade pública e os salários de que nelas trabalham. Na época da ditadura, que eu vivi na década de 1970, houve muito investimento na compra de novos equipamentos, escolhidos pelo corpo docente. Eu fiz a minha tese de mestrado com um desses equipamentos, escolhido por um colega meu, aliás químico brilhante, e que faleceu em um acidente, e nem pode aproveitar aquilo.

É uma tremenda ironia ter visto governos de força investirem na ciência, e depois assistir os seus pares “democráticos” entrarem na vida pública com ódio da academia. Tudo na vida acadêmica mudou para pior, e quanto mais o tempo passa mais será difícil reconstruir o que já foi e ainda será perdido.

Eu não tenho mais quase contatos depois que me aposentei, mas leio nos jornais que a atual reitora da UFRJ já avisou que se as verbas de manutenção continuarem escassas, a UFRJ vai fechar as portas! E eu não duvido que esta declaração seja realista.