O crescimento da microinformática teve o poder de transformar vidas. Hoje usamos um celular sem saber que lá dentro tem um computador rodando um sistema operacional avançado.

Teria sido inevitável que, depois de anos potencialmente restritos aos computadores de 8 bits, os quais foram muito importantes no sentido formador, os usuários brasileiros iriam migrar para plataformas de 16 bits, notadamente para aquelas baseadas na arquitetura compatível com microcomputadores IBM-PC.

Por pura coincidência, quem usou microcomputadores MSX na década de 1980 deu sorte ao migrar para a plataforma IBM, porque a Microsoft baseara o seu sistema operacional de disco em uma cópia do CP/M, e o MSX-DOS era, por seu turno, uma versão resumida do MS-DOS, sistema usado nas máquinas da IBM.

É hoje um fato histórico que a IBM se lançou tarde ao mercado de microcomputadores e quando o fez não teve sucesso algum. Mas, aprendeu lições as mais variadas, entre elas de como montar uma máquina de 16 bits com peças já disponíveis nas prateleiras e também de, ao contrário da Apple, tornar a sua arquitetura aberta.

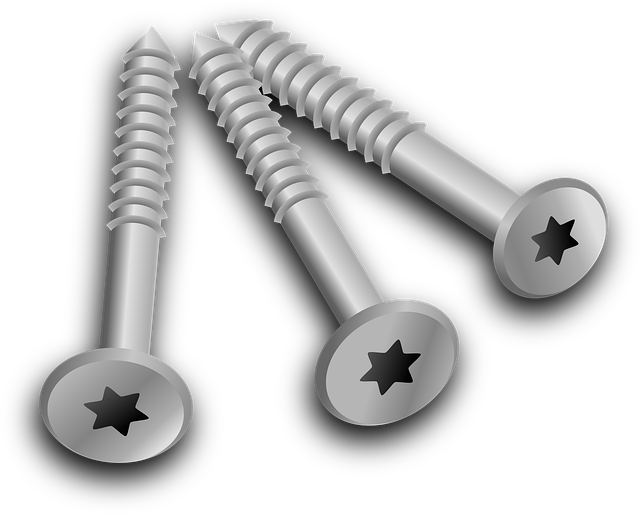

Este tipo de arquitetura iria eventualmente permitir que fabricantes desenhassem e montassem computadores do tipo “IBM-PC compatíveis”. Mais tarde, quando todos os componentes foram colocados à venda separadamente, um usuário final poderia montar ele mesmo a sua própria máquina, desde que soubesse previamente como ela precisava ser montada e depois configurada adequadamente. Em outras palavras, não bastava apenas montar componentes, era preciso programa-los para que funcionassem de forma harmônica dentro do computador.

Tudo isso só mudou com o advento do “plug & play”, ou seja, ligar e rodar. Mas, logo no início esses componentes eram muito mal projetados, e por isso ganharam o apelido de “plug & pray”, isto é, ligar e rezar! Componentes com este tipo de topologia eram dotados de jumpers ou DIP-switches, que nos permitiriam configura-los manualmente, e assim evitar que eles não funcionassem como deviam.

Quando em Cardiff, eu ajudei um professor do departamento a se livrar de um problema deste tipo. Ele mandara instalar uma placa de expansão de memória no seu computador, mas ela não funcionou. Chegou a pensar em mandar retira-la, mas um dos meus orientadores, a quem eu emprestei tudo o que eu havia aprendido nesta área, me pediu para ir lá e dar uma olhada.

A vida da gente é cheia de situações pitorescas! Quando eu cheguei na sala do professor, ele me diz que iria dar aula e que eu ficasse à vontade na mesa dele. Depois de ver o que estava havendo eu acabei descobrindo que a folha de instruções daquela placa de baixo custo veio com um mapeamento de DIP-switches todo errado. Veja que nos computadores desta época, o usuário iria dar partida e ver o BIOS inspecionar e testar a memória RAM instalada, e exibir o resultado no monitor. Se houvesse um cartão de expansão instalado em um slot, ele seria testado também. E o que estava acontecendo com o computador do professor era que esta placa de expansão não estava sendo lida.

Para resolver isso, eu precisei remapear todos os DIP-switches e isto me deu muito trabalho, tentando identificar as configurações de cada switch. Quando o professor volta da sua aula, eu ainda estava fazendo isso, e ele comenta “você ainda está aí?”, quando então eu pedi um tempo para terminar o que estava fazendo. Não adianta explicar a alguém que não sabe do que se trata o que está havendo, ou porque este tipo de componente não funciona. Depois de tudo acertado, bastou mapear a placa do jeito que deveria ser, e então o computador leu o slot, testou e colocar o resultado na tela.

Por aí se vê como foi penoso se montar um computador e fazê-lo rodar sem problemas de compatibilidade entre componentes. Eu me lembro muito bem quando eu ouvi de um técnico da Dell me dizer que eles testavam dúzias de placas antes de qualquer novo projeto, para evitar que o cliente gastasse dinheiro e depois enfrentasse todo tipo de problema!

O computador no trabalho científico e em outras aplicações

Ao final da década de 1970 ficou óbvio que o trabalho pessoal nos laboratórios iria ganhar uma poderosa ferramenta, se fosse usada uma plataforma de microcomputação. Muita gente não sabe que um “computador” fora criado como uma máquina para corrigir erros de cálculo, vide Charles Babbage ou Konrad Zuze. O matemático Alan Turing foi quem previu que o computador poderia se tornar uma máquina universal, ou seja, capaz de realizar múltiplas tarefas, e assim o foi.

Uma enorme vantagem da computação de dados no campo científico é exatamente a possibilidade de tratar esses dados com expressiva precisão de cálculo. Um simples computador de 8 bits tem precisão suficiente para garantir bons resultados. Ao contrário das calculadoras de bolso, tão populares na década de 1970, um computador corretamente programado permite o total controle de processamento exigido, desde a entrada dos dados até o resultado final dos cálculos.

Consciente disso tudo, eu rapidamente aprendi passos rudimentares de programação em uma máquina HP-9810A e informatizei a minha tese de mestrado. Na defesa, um cientista, que eu prefiro não declinar o nome, criticou o meu trabalho, me acusando de “exagerado”, e afirmando que com uma simples calculadora de bolso ele teria resolvido todos os cálculos estatísticos. O meu irmão mais velho, que trabalhou com mainframes, saiu de lá revoltado, porque ele sabia que as calculadoras de bolso tinham uma série de problemas, e assim seria inconcebível compara-las a um computador,

Esta falta de visão, diga-se de passagem, não era incomum na comunidade científica, e eu a vi durante muitos anos. Em Cardiff, um dos orientadores não usava computadores (me disse que um dia iria aprender e que eu iria ajudá-lo a realizar isso), mas era sempre interessado em tudo o que avançava no laboratório. Um outro orientador não chegava nem perto de um computador, e era engraçado ouvir as secretárias do departamento reclamarem de ter que digitalizar tudo o que ele escrevia à mão.

Se existe uma coisa muito importante que a informática me deu desde o início foi começar a entender o raciocínio lógico, base de todo algoritmo de programação. Por causa disso, a minha interface de comunicação com este orientador que não gostava de computadores foi complicada.

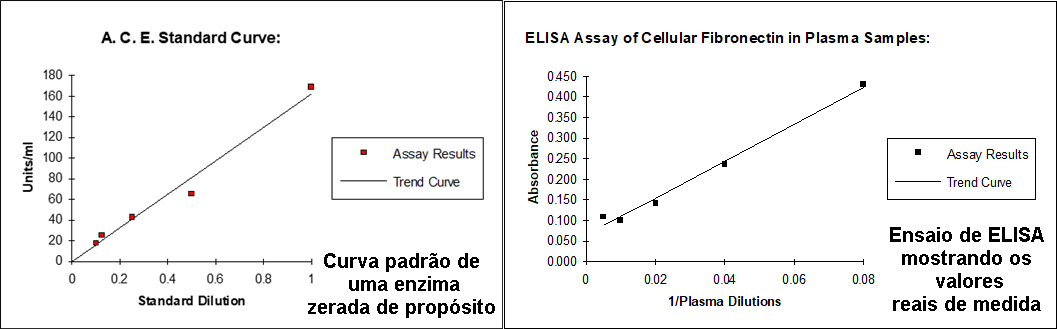

Um dia, ele se queixou comigo que as minhas curvas padrão de medidas fotométricas não passavam pelo zero. Em tese, ele teria razão, porque a lei de Beer dita que quando uma solução com concentração zero era medida a absorbância (absorção de luz pela substância na solução) seria obrigatoriamente zero, portanto passando pelo zero da curva. Só que, na prática, toda e qualquer medida espectrofotométrica tem um erro experimental, motivo pelo qual se costuma medir cada ponto da curva em triplicata, e lançar na curva a média desse valor.

Mas, só isso não basta. Para se ter absoluta certeza de que os valores medidos se encaixam na lei de Beer é preciso lançar mão da regressão linear, que calcula e corrige o afastamento de cada ponto da curva de calibração e computa os erros no cálculo das amostras desconhecidas. Ou seja, é a estatística ajudando a corrigir os erros experimentais. Eu aprendi isso muito antes de chegar em Cardiff, mas naquela tese eu modifiquei as curvas para agradar este orientador, sem ele, é claro, saber que todos os meus valores de medida eram corrigidos. Quando eu trabalhei com ELISA, um bom cientista da área me disse que em alguns casos era preciso usar regressão potência, porque a linear não era suficiente!

Abaixo eu mostro o exemplo de dois gráficos, um deles “zerado”, como pedido pelo meu orientador, o outro com os valores reais medidos em um ensaio. A curva chamada de “Trend” é a curva obtida com a correção do erro experimental:

Apesar das idiossincrasias, eu sempre fui muito grato aos meus orientadores, porque eles são balizadores experimentados e honestos de um trabalho científico complexo e de um manuscrito mais complexo ainda. Lá fora, eles só liberam o candidato para defender a sua tese quando todos os requisitos são satisfeitos. E eu dei sorte de só ter tido três revisões de manuscritos antes da defesa. Um colega da UFRJ, de grande capacidade intelectual, teve, segundo ele, dez revisões antes da defesa.

A informática, infelizmente, chegou muito tarde na vida de muitos professores e cientistas, aqui e lá fora, e muito dessa recusa tem a haver com a ausência deste tipo de cultura. Mas, não deixa de ser contraditório um intelectual não alargar o seu campo de visão, e isso foi o que eu vi por anos a fio na academia.

A importância do processador de textos em ambiente gráfico

Outra implicância deste orientador, esta bem mais amena, foi quando ele viu uma das versões de um capítulo do manuscrito da minha tese formatado em Word For Windows. Eu aprendi o básico da editoração gráfica (“desktop publishing”) antes de escrever a versão definitiva da minha tese e apliquei estes conhecimentos na montagem de cada página.

Este tipo de editoração, antes restrito a programas como Ventura ou Page Maker, foi incorporado na interface gráfica do Word For Windows 2.0. Ao ver a página impressa, o orientador me disse que eu estava escrevendo um livro, e ele tinha razão. Mas, tendo passado por uma tese de mestrado datilografando as páginas com máquina de escrever IBM de bola, na qual para se trocar a fonte ou para se inserir uma letra grega era preciso ter e trocar por uma bola adequada, eu não iria ignorar este novo tipo de recurso.

No mestrado, se eu errasse uma única referência bibliográfica eu teria que redatilografar todo o restante, um trabalho insano e tedioso! Sem falar em erros de ordenação, feitas manualmente! Nada mais natural do que usar o Word para fazer isso sem nenhuma dificuldade! Ainda mais, porque eu sou péssimo datilógrafo!

Esta “novidade” de usar editoração gráfica no computador foi, eu soube depois, inédita no departamento, mas quando as pessoas mais perto viram o resultado, todas saíram correndo para fazer o mesmo, e logo depois o próprio departamento recomendou que todos os manuscritos de tese fossem feitos daquela maneira!

A verdade é que todos os avanços na área de microinformática ajudaram o desenvolvimento das pesquisas em geral, não só no laboratório ou na pesquisa de campo. Por causa disso mesmo, não me causou surpresa ao saber que computadores avançados, como os chamados super computadores, estavam em pleno uso pelas universidades e centros de pesquisa!

Uma experiência pessoal

Eu fui, digamos assim, um entusiasta do MSX, escrevi trabalhos para revistas de banca de jornal e livros sobre ele, mas ao sair do país, o MSX se tornou uma simples memória que eu iria não exatamente apagar, porque, bem ou mal, foi para mim uma escola, mas para deixar aquela plataforma para trás, em busca do que se apresentava na minha frente como a natural evolução do microprocessamento.

Eu já descrevi parte desta estória em outro texto, mas deixei de lado alguns detalhes: em território britânico, os computadores de 8 bits nem eram mais vendidos, porque, entre outras coisas, a relação custo-benefício simplesmente não compensava!

O meu primeiro computador pessoal de 16 bits foi um Amstrad PC1512, com CPU Intel 8086, rodando poderosos 8 MHz de velocidade. Esse micro foi muito popular na época. Ele trabalhava com dois drives 5 ¼” e um disco rígido cujo espaço não me lembro mais. O monitor era âmbar, compatível com EGA, e quebrava um galho.

Dentro de casa, o PC1512 serviu para todo mundo e me ajudou a me adaptar à nova plataforma. Todos os discos do MSX rodaram nesses drives. Só que eu precisei logo atualizar e depois ampliar o meu antigo programa de estatística, partindo do MSX-Basic para o Basic do IBM-PC, que tinha muito mais recursos.

Abaixo, eu mostro algumas das poucas fotos que sobraram desta época. À esquerda, o meu saudoso e querido primo Carlos Alberto, que trouxe de Warwickshire o computador para a minha casa, e ao lado, a minha filha mais velha se “exibindo” com a máquina nova já instalada:

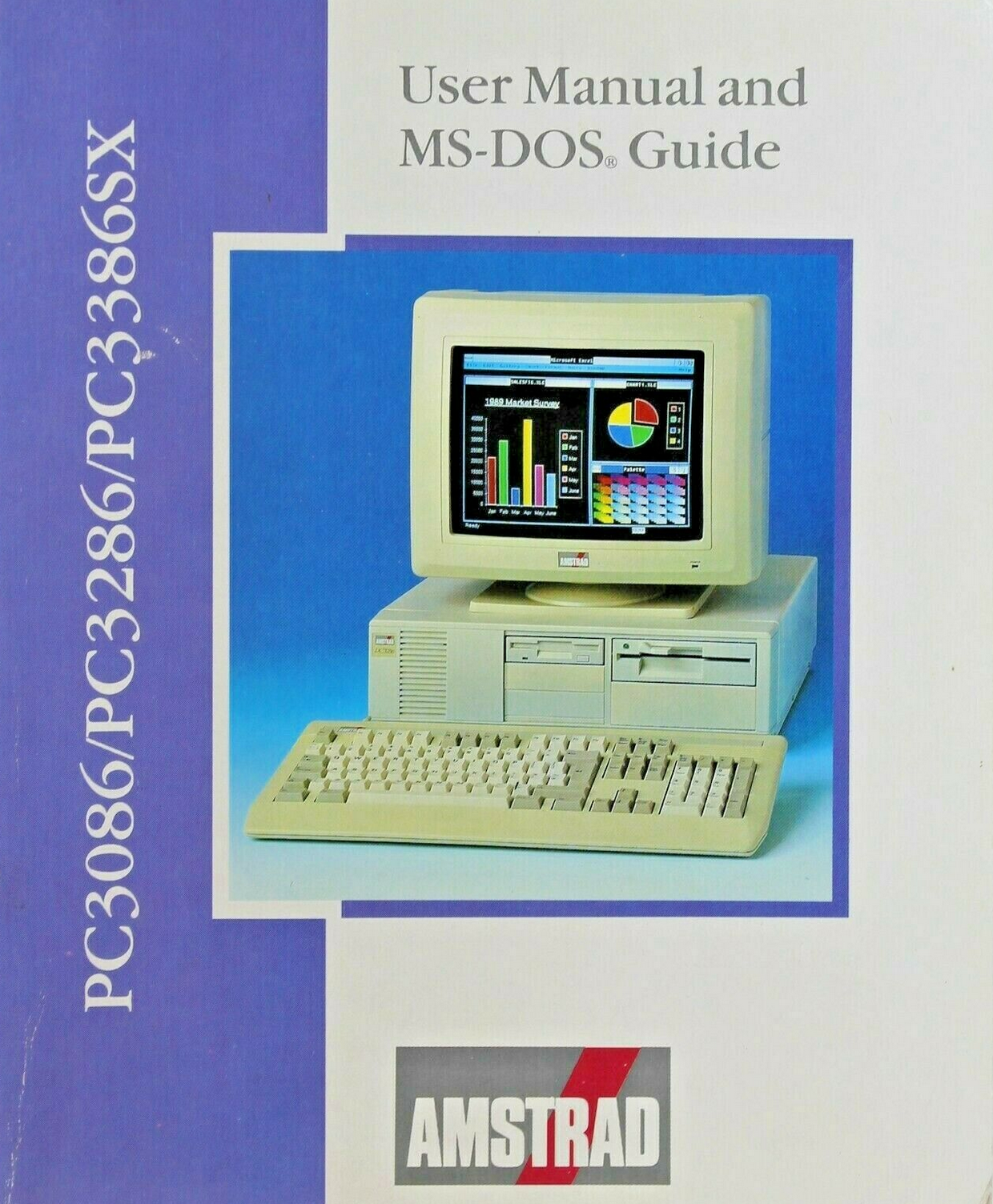

A dinâmica de mudanças drásticas de processadores e outros recursos empurraram o PC1512 para outro tipo de usuário. No meu ambiente de trabalho eu usava um computador com CPU Intel 80286, mas em casa eu pulei do 8086 para um Amstrad com CPU Intel 8386SX, a qual me permitiu alcançar novos horizontes. Outros avanços aconteceram quando eu parti para um micro com o processador Intel 80486DX.

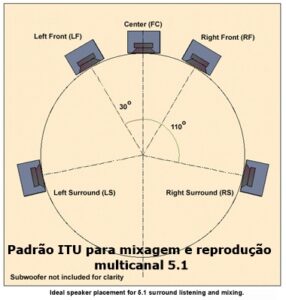

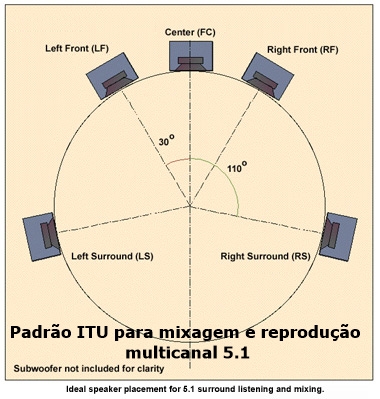

Um deles se referiu à montagem de uma rede MIDI dentro de casa. O MSX também tinha uma rede deste tipo para o consumidor, mas eu nunca me interessei por ela. A rede MIDI para PC era montada através de um cartão adaptador, instalado em um slot de expansão.

A gente comprava um kit, com cabos de ligação e programas. Embaixo, eu mostro uma foto com a rede MIDI já montada para o meu filho, que começou a se interessar por música erudita desde cedo. E esta foi uma forma de estimulá-lo a se aprofundar mais:

Eu não guardei fotos do meu belo Amstrad 80386SX. O computador era mesmo muito bonito, veio com monitor VGA (poderia ter sido SVGA), com um disco rígido de melhor qualidade e drive 3 ½”, que eu precisava usar. Na Internet, eu consegui achar e compartilho abaixo, uma imagem daquela época, com a capa do manual:

Processadores Intel durante muitos anos não tinham coprocessamento aritmético. As versões “SX” de processadores posteriores permitiriam que o usuário instalasse por fora um coprocessador aritmético na placa mãe e transformasse o processador “SX” em um “DX”. A Intel derrubou o preço desse componente, por causa da concorrência, e foi por isso que eu me animei em comprar e instalar um deles. Nesta mesma época, o Windows 3.0 já havia sido lançado e a sua interface gráfica e os programas escritos para este ambiente sofriam no computador sem um coprocessador aritmético.

Uma vez instalado, a diferença era da água para o vinho. O Word For Windows, que usava métrica de fontes, levantou voo. O Excel, então, nem se fala. Foi exatamente neste momento que eu me lembrei que os computadores haviam sido concebidos para fazer cálculos!

Até no processador 80486 existiam versões SX e DX, mas com a queda eventual dos preços, não mais compensava comprar ou mandar montar um computador com CPU 80486SX. A última versão deste processador que eu tive foi um 80486DX, que rodava a 60 MHz, uma velocidade e tanto.

Essas coisas ficam tanto para trás, que nunca mais ninguém consegue se lembrar do passado distante, comigo partindo de uma CPU Zilog Z80A, rodando a aproximadamente 3.58 MHz, e no final alcançando 60 MHz, com coprocessador aritmético incluído.

Alan Turing tinha razão: um computador não precisaria ficar restrito a uma calculadora avançada. Ele é claramente útil como tal, mas os programas para ele escritos nos mostraram que se pode alcançar tudo o que a imaginação de alguém permite. O computador é, até hoje, uma máquina capaz de múltiplas tarefas, e as faz com uma perfeição, valorizando o trabalho de quem é, por natureza, criativo!

Eu sempre tenho essa sensação de que o povo hoje tem um computador nas mãos, na forma de um telefone celular, mas visto apenas como um telefone com recursos. E quando este povo grava um vídeo e manda para uma emissora de TV, ele ou ela agem como repórter sem nunca na vida ter sido um! Outrolado_

. . .

Paulo Roberto Elias

Paulo Roberto Elias é professor e pesquisador em ciências da saúde, Mestre em Ciência (M.Sc.) pelo Departamento de Bioquímica, do Instituto de Química da UFRJ, e Ph.D. em Bioquímica, pela Cardiff University, no Reino Unido.