A quantidade de displays atualmente disponíveis para uso com computadores é enorme, e permite a quem monta ou usa fazer uma escolha na melhor relação custo/benefício. Historicamente a conexão computador com tela de TV ajudou muita gente a usar um micromputador dentro de casa.

Quando na década de 1970 Steve Wozniak começou a desenvolver o primeiro microcomputador Apple, para torna-lo exequível ele deixou projetada uma saída de vídeo, que facilitaria a conexão da máquina a um display a ser adquirido pelo usuário. Quando em 1977 foi desenvolvida a segunda geração, chamada de Apple II, Wozniak e seus colaboradores tiveram que implementar uma saída de vídeo mais sofisticada, incluindo o sinal NTSC para algum tipo de TV.

A ideia de transmitir vídeo na forma de um sinal convencional de TV foi o que, em última análise, permitiu que muita gente adquirisse um microcomputador e pudesse usa-lo sem necessariamente investir em um monitor. No Apple II uma subportadora de cor foi acrescentada, dando assim um toque de modernidade à reprodução daquele tipo de imagem.

Essas foram etapas nas quais os usuários daquele momento tiveram que passar. No meio da década de 1980 eu comecei a usar um microcomputador MSX Expert, que tinha um chip dedicado à saída de vídeo, e que poderia assim ser usado com qualquer TV colorida. O Expert era montado no padrão proposto, com um chip de vídeo Texas Instruments TMS9918. E foi assim que eu o conectei nos primeiros meses de uso. A Gradiente havia lançado um monitor de fósforo verde, que eu depois adquiri e montei, de modo a poder lançar mão de uma placa de 80 colunas, que era instalada em um slot de expansão para cartuchos.

Evolução

No padrão IBM-PC ou Mac o uso de monitores dedicados se tornou quase que compulsório, até porque os padrões de resolução de imagem e quantidade de cores geradas iria aumentar com o decorrer dos anos. O detalhe é que, com esta evolução, nem todo monitor colorido era capaz de acompanhar a modificação de geração de imagens, impedindo assim o usuário rodar certos jogos ou aplicativos.

Os monitores da época eram feitos com tubos de raios catódicos (CRT) e eletrônica com capacidade de sincronismo com as saídas de vídeo dos computadores. Isto obrigou o estabelecimento de padrões como VGA, Super VGA, EGA, etc., e para saber que telas poderiam ser reproduzidas em um dado monitor usava-se programas capazes de gerar os principais padrões de tela. Quem quiser pesquisar no YouTube este assunto vai acabar achando alguém rodando um programa deste tipo para fazer testes com monitores CRT antigos.

No quesito resolução, um monitor desta época usava uma medida de pontos por polegada (“dots per inch”) na tela, o que tornou a classificação dos displays um tanto ou quanto confusa. Posteriormente, este tipo de medida foi substituído por pixel por polegada, em referência à unidade RGB da formação da imagem. Em contrapartida, o critério de medida anterior em pontos por polegada continuou a ser usado para a definição de impressoras.

O uso de monitores CRT de alta resolução foi importante em um dado período da minha vida como usuário final, mas esta conquista foi penosa e durou vários anos. Os primeiros monitores coloridos que eu vi aqui eram exageradamente caros e desajeitados. E lá fora, o fator que pesou contra foi o alto preço praticado para monitores de melhor qualidade.

O meu primeiro monitor colorido de tubo só reproduzia VGA, portanto bastante limitado. Mas, ele fazia parte de um computador Amstrad 386SX. Quando eu depois montei um 80486 com componentes de prateleira eu optei por um monitor de tubo Philips muito mais evoluído, capaz de reproduzir qualquer tela daquela época.

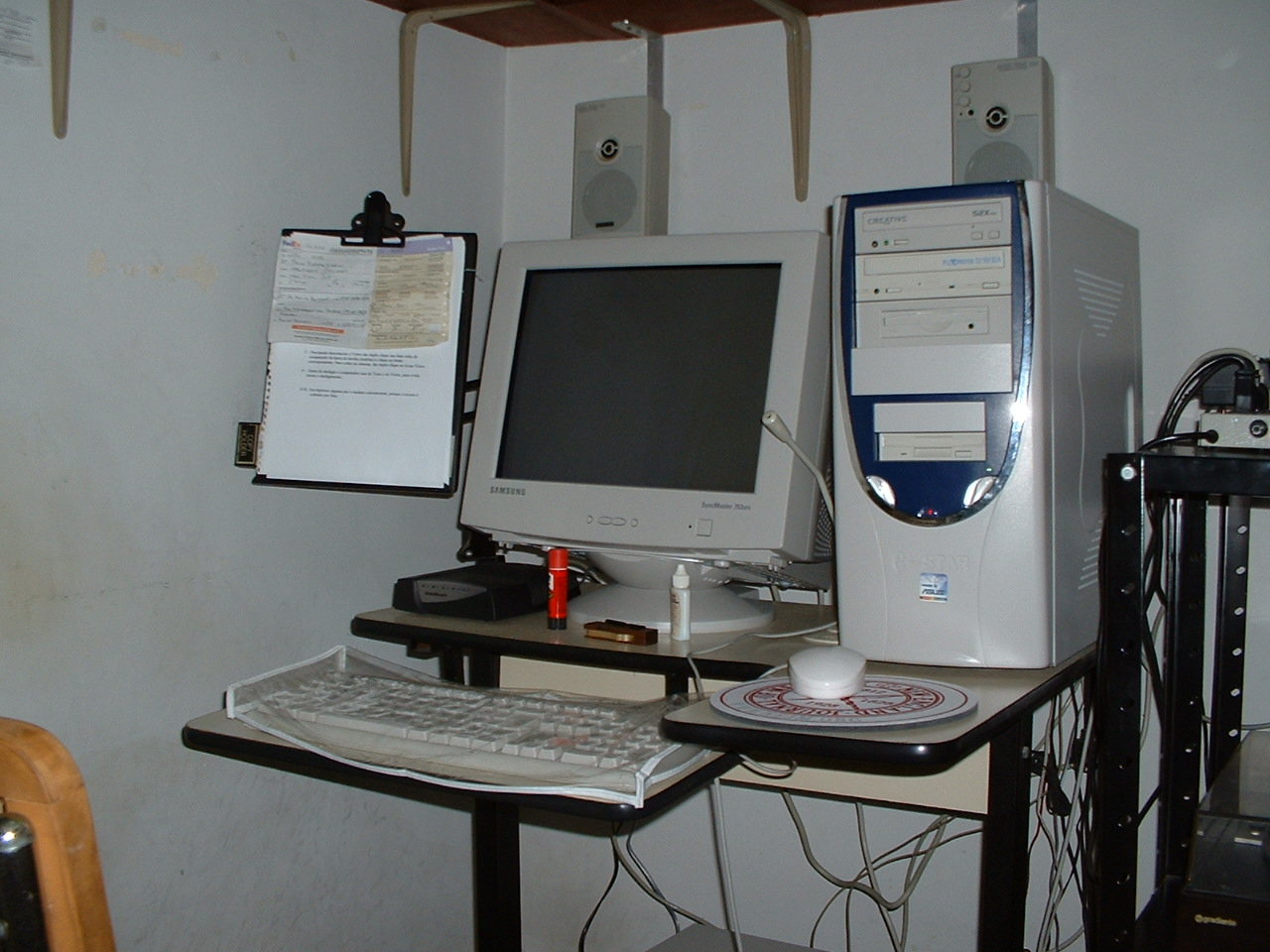

Olhando nos meus documentos fotográficos antigos, eu achei uma foto tirada em 13/11/2002, segundo informações nos metadados. Não faz tanto tempo assim. Ela mostra o melhor monitor CRT que eu usei, com a sua gigantesca tela de 19 polegadas, fabricado pela Samsung.

Olhando a foto com atenção já dá para ver a presença de um modem DSL na minha mesa e, bem ao lado, um toca-discos com o qual eu remasterizei e restaurei os meus últimos LPs. Que coisa, hein…

Monitores LCD

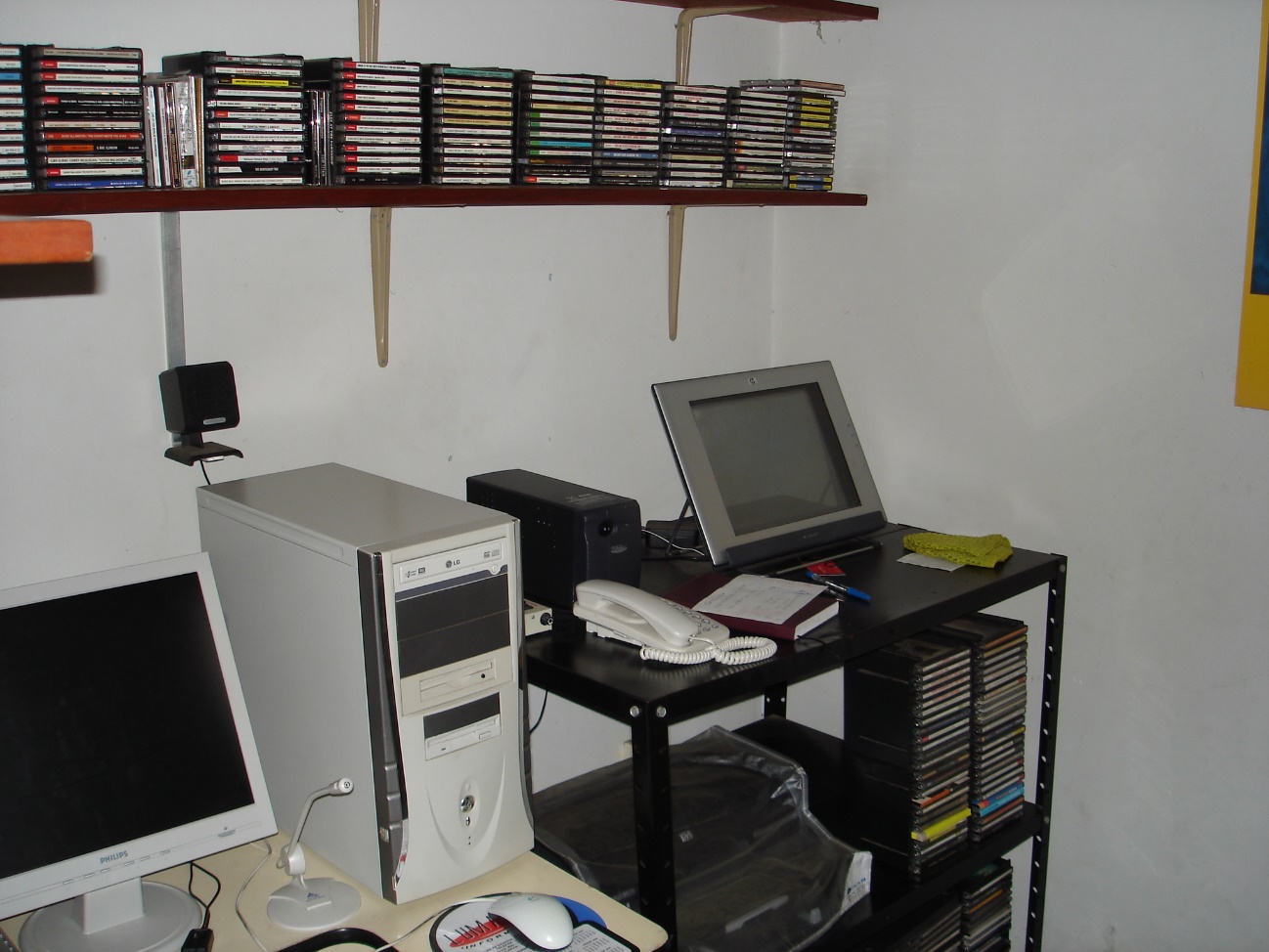

Ainda citando a minha experiência, e contando com as imagens das fotos antigas, esta agora registrada em 16/11/2005, eu achei aquela que mostra o meu primeiro monitor LCD, fabricado pela Philips:

Em 2005, as telas LCD não tinham boa reputação. E na verdade, o manual daquele monitor afirmava que se a tela tivesse até 10 pixels mortos a garantia do display não seria coberta e nem permitiria a troca do monitor.

O pixel classificado como “morto” (do inglês “dead pixel”) se referia ao pixel de cristal líquido permanentemente desligado (sem alimentação elétrica), obstruindo a passagem da luz de fundo do monitor. A tecnologia LCD forma um pixel através de filtros RGB. A camada de cristal líquido trabalha como um interruptor da passagem da luz de fundo (“backlight”) para o display. Quando este “interruptor” fica imóvel e aberto a luz do fundo mostra na tela um ou mais pontos coloridos, de um ou mais dos subpixels RGB. Com o LCD permanentemente fechado (“dead pixel”), aparecia um ponto negro na tela.

Este problema na construção de telas LCD levou tempo para ser resolvido, mas até hoje pode se transformar em uma tremenda dor de cabeça. Eu comprei em 2016 um monitor profissional Dell UP3216Q, e ele chegou com uma lista colorida vertical, discreta, mas bastante visível. Foi um parto sensibilizar o suporte da Dell que era um defeito no LCD da tela. No final, um técnico foi mandado na minha casa, viu pessoalmente o problema e autorizou a troca.

Esta experiência com a Dell me mostra até hoje que telas LCD ainda são tecnicamente problemáticas. Quando a luz de fundo fica nas bordas (tipo “Edge-Lit”) as chances de vazamento de luz nos cantos chegam a ser constrangedoras, e não há nada que se possa fazer, que eu saiba, para resolver isso, porque se trata de uma dispersão mal feita dos LEDs montados nas bordas. É o caso desse caríssimo modelo da Dell. No momento em que o computador emite sinal de vídeo mas ainda sem imagem se pode ver a diferença de luz nas bordas. É claro que a gente aprende a sublimar este tipo de problema e se concentra no trabalho, caso contrário só mesmo trocando de monitor.

A introdução do monitor LCD em 2005 foi cercada de dúvidas quanto à sua performance. Nesta época eu fazia parte de um fórum onde eu conhecia muita gente pela Internet. Lá me perguntaram o que eu estava achando, especificamente sobre a reprodução da gama de cor do meu Philips. Na época eu a achava satisfatória, mas na verdade a capacidade de reprodução de cores em escala avançada depende também da placa gráfica usada na montagem, e isso só ficou mais claro anos depois.

De qualquer forma, por uma série de razões, em anos subsequentes o CRT caiu em desuso e foi substituído pelos displays LCD, estes já com tecnologia bem mais convincente, em todos os sentidos. Com a troca do CRT pelo display LCD afastou-se aquele monitor pesado e inconveniente da mesa de trabalho!

De volta à TV, com a TV-Monitor

Eu me lembro, quando anos atrás, eu tive um contato com um representante técnico da Samsung e conversei com ele sobre a limitação em tamanho de telas de monitores LCD para computadores. E ele me diz que isso era problema superado. Porque, lá na Samsung eles deixaram os monitores convencionais de lado e conectaram todos os computadores em televisores.

Alguns fatores técnicos facilitaram este tipo de aplicação: um deles se referia ao aumento da resolução, que já tinha suporte no Windows e em outros sistemas operacionais. O outro se referia ao conector usado. Inicialmente se usou conector VGA, tipo DB-15, com entrada de áudio em separado, mas somente em alguns poucos aparelhos de TV. Com a introdução do HDMI este conector VGA morreu, até porque as placas gráficas passaram a dispor das interfaces necessárias para outros tipos de conectores.

Notem que na época do monitor CRT os modelos mais avançados eram dotados de entrada RGB separada, mas isso vinha com um alto custo à balcão. Com a conexão de vídeo por HDMI a gente nem se dá mais conta desse tipo de empecilho, e com custo infinitamente menor!

A própria Samsung, LG e outros fabricantes passaram a oferecer o que era chamado de TV-Monitor, que nada mais era do que uma TV LCD convencional dotada de entrada HDMI dedicada. Esta entrada era pré-ajustada para impedir o chamado “overscanning” da imagem, mantendo assim todos os pixels originais na área visível da tela. A TV-Monitor saiu de linha, os últimos modelos tinham uma resolução muito mais baixa do que a capacidade dos adaptadores gráficos, embora a imagem fosse razoavelmente satisfatória.

Não foi surpresa a ausência da fabricação da TV-Monitor. Na realidade, qualquer TV com ajuste para controlar o overscanning permite ligar o computador a ela sem nenhum problema quanto à visibilidade integral da imagem.

Tipos de TV ou monitores para uso atualmente com computadores

Embora a tela OLED tenha (e ainda tem) limitações na retenção da imagem na tela e esta limitação contornada com recursos como desvio de pixel e outros, o seu uso como monitores ainda não é, na minha opinião, recomendável.

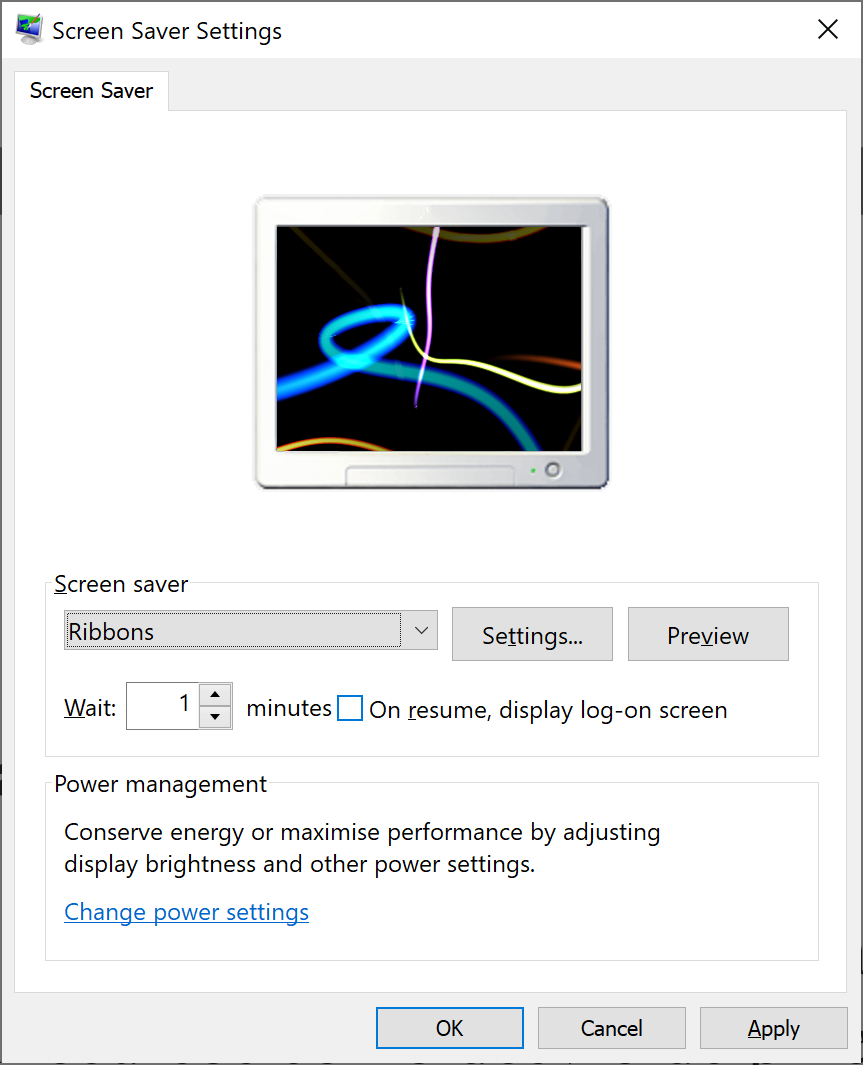

É verdade que o Windows tem até hoje o chamado protetor de tela, acessível no painel de controle:

Este tipo de proteção deixou de ser default quando o Windows é instalado simplesmente porque há décadas que ele não tem mais razão de ser. Em telas OLED ele passa novamente a ser útil, caso o monitor necessite.

Os monitores e as TVs LCD atuais tornaram a relação custo/benefício amplamente favoráveis à sua aplicação em informática. A luz de fundo, que passou a ser emitida por LEDs, sofreu significativos avanços com a correção por pontos quânticos que corrigem erros no seu espectro de emissão. Além disso, telas HDR são suportadas integralmente no ambiente Windows, dispensando drivers para esta finalidade.

Além disso, os adaptadores gráficos recentes só faltam falar. As acelerações de hardware são avanços importantes, facilitando inclusive a performance do computador como um todo, dependendo do aplicativo. Eventuais limitações da TV, TV-Monitor ou Monitor dedicado são amplamente contornáveis por causa desses adaptadores.

Por outro lado, a preferência que, a meu ver, deve ser dada aos monitores dedicados tem prevalência quanto ao tipo de aplicação pretendida, sem falar que nestes tipos de monitor a conexão é muito mais flexível, e assim o usuário pode dispor, por exemplo, de DisplayPort ou USB-C, além de conexões HDMI.

Quem monta computadores e já passou por displays limitados vê já há algum tempo uma miríade de opções. A escolha pode inclusive ter um peso maior na questão financeira. Mas é confortável saber que televisores de tela avantajada podem ser usados com conforto e com alta resolução de imagem, provavelmente com custo menor do que um monitor dedicado. Tudo vai depender de quem monta, que tipo de uso pretende, e de quanto se quer ou se pode gastar. Outrolado_

. . . .

Paulo Roberto Elias

Paulo Roberto Elias é professor e pesquisador em ciências da saúde, Mestre em Ciência (M.Sc.) pelo Departamento de Bioquímica, do Instituto de Química da UFRJ, e Ph.D. em Bioquímica, pela Cardiff University, no Reino Unido.

0 resposta

Tenho visto empresas hoje em dia que, quando contratam o funcionário para trabalhar em casa de “home office”, compram um monitor Dell dedicado (desses na faixa dos R$5k) e enviam como parte do kit de equipamentos de trabalho, junto com notebook, etc.

Eu, particularmente, acho a ideia da TV como monitor bem mais interessante pra quem vai comprar do próprio bolso. Fora que normalmente vai ser uma tela bem maior, o que pode ser mais interessante dependendo do uso.

Tenho visto empresas hoje em dia que, quando contratam o funcionário para trabalhar em casa de “home office”, compram um monitor Dell dedicado (desses na faixa dos R$5k) e enviam como parte do kit de equipamentos de trabalho, junto com notebook, etc.

Eu, particularmente, acho a ideia da TV como monitor bem mais interessante pra quem vai comprar do próprio bolso. Fora que normalmente vai ser uma tela bem maior, o que pode ser mais interessante dependendo do uso.