Ligar um computador a uma TV é possível e fácil de fazer. Na era moderna da censura à cópia de conteúdo tanto os adaptadores gráficos dos computadores quanto as TVs são equipados com saída e entrada de sinal por HDMI com proteção HDCP.

Em tempos remotos, era preciso usar um aplicativo para driblar este tipo de censura, quando o se queria reproduzir era alguma mídia de vídeo previamente protegida.

Tem momentos da vida de todo usuário onde conectar um computador a uma TV não basta. Existem limitações de reprodução de imagem, que impedem aplicações de atingirem um nível de resolução e reprodução de cores compatíveis com a qualidade do trabalho pretendido, como, por exemplo, a edição de fotografias.

Graças aos avanços da tecnologia de displays existem já há algum tempo monitores de alta resolução, que atingem todos os objetivos não só de usuários avançados como até mesmo de entusiastas que querem obter imagens exemplares sem se envolver em trabalhos gráficos profissionais.

As diferenças básicas entre TVs e monitores

Existem as chamadas TV/Monitores (eu já usei uma por muito tempo), que chegam a um nível satisfatório de qualidade de imagem no quesito resolução, com possibilidade de calibração da imagem inclusive. A vantagem principal deste tipo de equipamento está basicamente no custo, em relação ao tamanho da tela.

Entretanto, raramente uma TV/Monitor poderá alcançar o nível de qualidade necessária a um trabalho profissional, quando então será preciso sacrificar o tamanho da tela pela capacidade de desempenho na imagem final obtida.

Sem entrar em muitos detalhes técnicos, bastaria dizer que a diferença na faixa de escala de cinza entre uma TV e um monitor dedicado é suficiente para determinar as demais limitações de desempenho.

A TV alcança bons níveis na representação da imagem, porém elas trabalham em sua maioria com 8 bits de resolução. A exceção fica por conta das novas TVs UHD HDR do tipo “high end”, que têm sido lançadas recentemente no mercado. Entre os novos modelos, existem alguns que se aproximam de um monitor dedicado.

É preciso observar que cada pixel é composto por três subpixels nas cores Vermelho, Verde e Azul (RGB), que são as cores primárias do espectro de cor visível.

Com 8 bits de resolução, a combinação de tons em cada subpixel será de 2^8 = 256 combinações possíveis. Como são três canais de cores (RGB) um pixel terá 2^24 = 16 777 216 possíveis matizes para a formação de cor. 16 milhões de cores ultrapassaria teoricamente o limiar de observação humana, mas cada tom de cor individualmente continua restrito a 256 combinações, limitando assim a resolução final obtida.

O prejuízo maior desta limitação está na transição de tons da mesma cor, muitas vezes visíveis a olho nu na forma de bandas.

Subindo a resolução para 10 bits, o espectro de cores reproduzido muda radicalmente. Serão no total 30 bits por pixel (3 x 10), dando um total de 2^30 = 1 073 741 824 de cores.

Quando a imagem está restrita a 8 bits, a faixa dinâmica de contraste trabalha entre 16 a 235 no sinal RGB, a chamada “faixa limitada”, e a faixa completa reproduz um sinal entre 0 e 255 (faixa completa ou “Full Range”).

Lembrando que 8 bits é igual a 1 byte e que cada pixel RGB terá três combinações de subpixels, um sinal com preto absoluto será representado por RGB (0,0,0) e, em contrapartida, o branco absoluto será representado por RGB (255,255,255).

Em um display ideal, contraste e brilho seriam ajustados de tal forma que um sinal contendo RGB (0,0,0) exibiria um nível de preto sem qualquer emissão de luz e um sinal RGB (255,255,255) uma imagem branca com luminância equilibrada entre as três cores. Atualmente, somente as telas com tecnologia OLED conseguem o preto absoluto, devido ao apagamento completo dos pixels.

Com sinais de 8 bits, a obtenção de preto e branco absolutos é teoricamente impossível. Nas TVs de hoje com capacidade para aceitar sinais de 10 bits, é prudente limitar a entrada para “Faixa Limitada” ou “Limited Range”, se o usuário quiser reproduzir, por exemplo, um disco Blu-Ray convencional, limitado a 8 bits. Em não o fazendo, ele correrá o risco de obter uma distorção da imagem na reprodução da faixa de cores, alteração do ajuste de gama, temperatura de cor, etc.

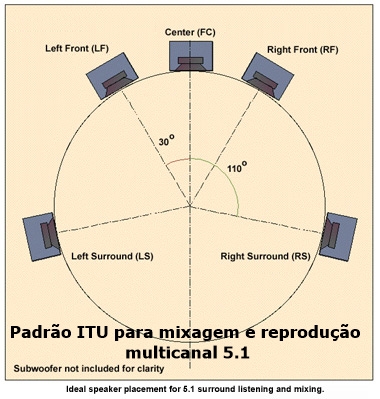

Na interligação entre um computador e um monitor é preciso que tanto o adaptador gráfico quanto o monitor aceitem trabalhar com sinais de 10 bits:

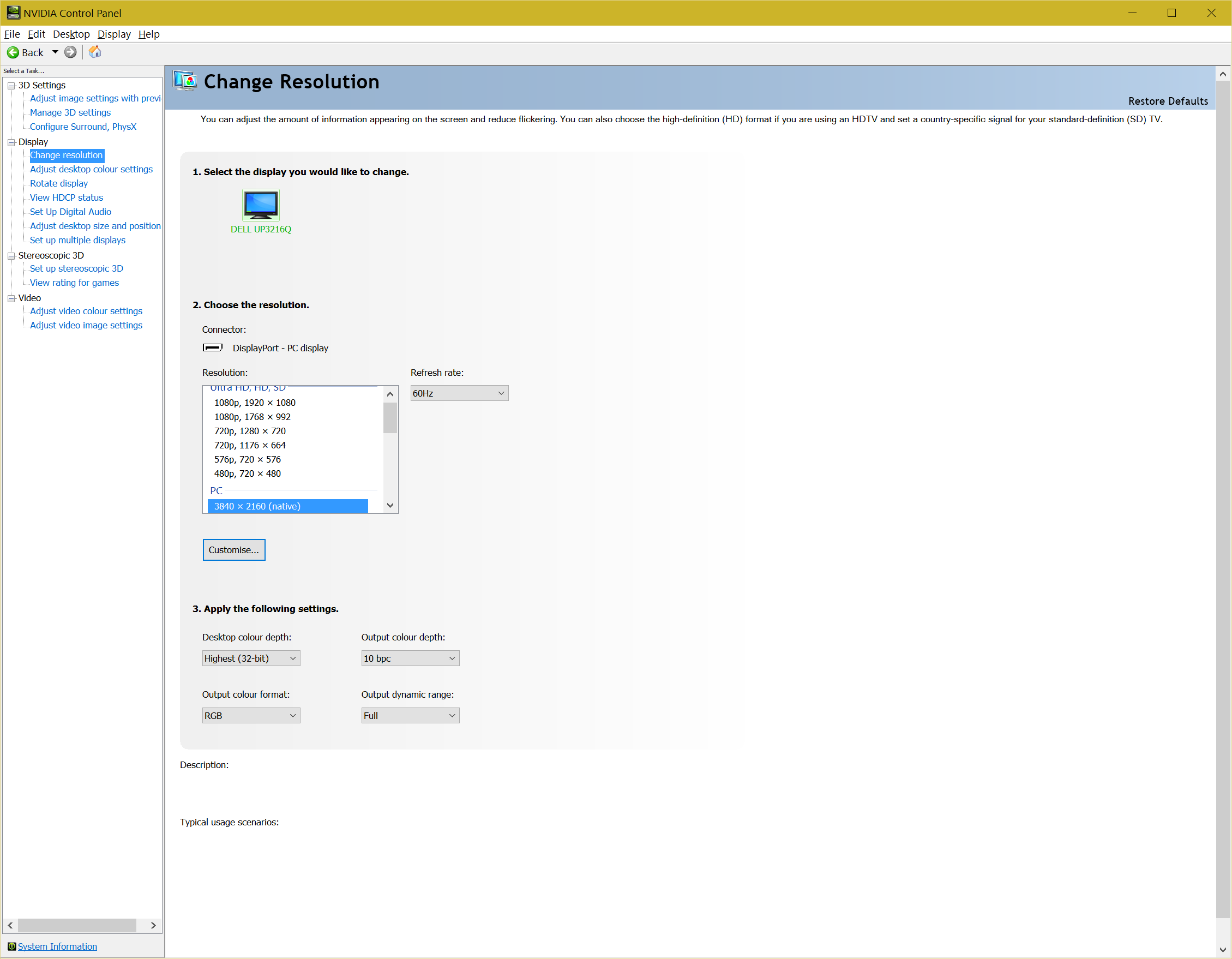

Nos drivers atualmente usados pela Nvidia (mostrado na figura acima) o display em uso será normalmente identificado e a respectiva escala de resolução acertada automaticamente. Na escala superior, com o rótulo “Ultra HD, HD, SD”, estão os valores de resolução pertinentes às TVs usadas como monitores, e na escala inferior, “PC”, estão os valores usados pelos monitores dedicados.

Se um monitor for ligado e o driver o identificar como TV (escala de cima), é possível que haja uma incorreção no software interno do monitor, e neste caso o usuário terá que alterar o ajuste manualmente.

Quando um monitor de alta resolução é corretamente identificado, ainda assim será necessário acertar alguns detalhes:

O máximo de desempenho é conseguido quando a resolução de saída é ajustada para 10 bpc (bits por canal), e a faixa dinâmica ajustada como “Full”, tal como mostrado na figura acima.

Itens como a calibração feita com o uso de colorímetros ou a escolha de um espaço de cor, por exemplo, ficarão por conta do usuário, através do menu do monitor ou de software que cumpre a mesma finalidade.

O uso de colorímetro é importante para trabalhos profissionais, mas se o monitor é corretamente calibrado na fábrica, o que não é incomum, o usuário pode se fiar nos modos de tela sem maiores preocupações.

As vicissitudes do mercado consumidor

Monitores de alta resolução são muito caros, o que poderá inibir o seu uso disseminado. Por outro lado, quando indicado para aplicações amadoras de nível avançado ou profissionais, ainda resta investir em um bom adaptador gráfico para o computador.

Infelizmente, os fabricantes de adaptadores se voltaram nos últimos sei lá quantos anos para o público interessado em joguinhos. E a partir daí os nomes de fantasia começaram a pipocar com as palavras “gaming” ou “super clocked” (com referência ao aumento de velocidade da GPU), que nada ajudam o usuário que deseja escolher um adaptador destinado a trabalhos com imagens, fotografia ou vídeo.

O marketing voltado para jogos empurra a maioria dos analistas para comparar o desempenho dos adaptadores em jogos diversos, ao invés de focarem, ou pelo menos dedicarem uma parte da análise, em mostrar como o adaptador trabalha com vídeo ou fotografia.

Monitores com resolução mais elevada irão necessitar de ajustes de escala no ambiente do sistema operacional. O Windows 10 faz isso automaticamente, mas permite alguns ajustes customizados que melhor possam atender à observação do usuário.

O investimento em um monitor de alta resolução, a meu ver, compensa quando o nível de trabalho é demandante, mas se não for o caso, poderá se transformar em um desperdício financeiro e do equipamento. E neste caso, uma TV ou TV/monitor darão o resultado desejado, com um tamanho de tela que os monitores costumam não ter.

Existem monitores no mercado com relação de aspecto 21:9, que são interessantes para vários tipos de aplicação. E adaptadores de vídeo com capacidade para ligar vários monitores simultaneamente, todos ajustáveis individualmente.

Entre as conexões digitais disponíveis, é recomendável dar preferência aos cabos DisplayPort, capazes de negociar a melhor resolução e frequências de varredura sem restrições.

A conexão por HDMI também funciona muito bem, mas é preciso ter certeza de se casar as versões da cadeia de transmissão. Neste momento, a versão mais atual é a 2.0. Em qualquer hipótese, é aconselhável indagar ao suporte do fabricante do adaptador se a versão HDMI disponível atende aos requisitos de ajuste de imagem pretendidos.

Monitores de alta resolução são ótimos para a observação de material de imagem ou vídeo, como referência para qualquer parâmetro de qualidade.

O tempo foi implacável com os bons monitores

Na época da famigerada lei de reserva da informática, imposta por empresários ligados ao regime militar, foi proibida a importação de computadores e periféricos. Ao longo da década de 1980 eu e meus amigos nos juntávamos para ver nas feiras o que era oferecido pela indústria nacional.

Havia uma empresa cujo nome não me recordo que fabricou um monitor um monitor VGA colorido de tubo, para uso profissional. O preço de uma peça dessas era muito alto, e assim a maioria de todos nós que tínhamos um micro em casa usávamos monitor monocromático e/ou ligávamos em alguma TV com o uso de cabos de vídeo composto, e aí sim conseguíamos ver cor.

Nos anos seguintes eu estava fora do país, quando então comecei a ver a realidade que a reserva de mercado brasileira nos privou. Lá pelas tantas, o nosso departamento adquiriu um monitor Silicon Graphics, de alta performance, com entrada RGB, usado para, se não me engano, aplicativos de modelagem molecular. O preço de um monitor desses era impagável, tanto assim que somente um foi comprado.

O restante da década de 1990 viu crescer o aparecimento de monitores de tubo com 19 polegadas, em um nível tão bom ou melhor do que aquele super monitor da Silicon Graphics. E no final, os primeiros monitores LCD vieram à tona, precedidos da péssima reputação que as telas tinham, de apresentar uma cor esmaecida e tempo de resposta dos pixels muito alta, exibindo um arraste visível na tela.

Mas as telas LCD eram planas e leves, ao contrário dos monitores de tubo, cujas telas nunca foram planas ou leves. O tempo se encarregou de aperfeiçoar as telas de LCD, diminuindo o tempo de resposta e corrigindo a gama de cores. Junto com essas melhorias vieram as primeiras conexões digitais entre computadores e monitores. O conector DVI trouxe conexões analógicas, digitais e depois híbridas, permitindo assim qualquer configuração com o monitor em uso.

A abolição da conexão analógica tem tudo a ver com o uso de um microcomputador. Não seria cabível transmitir sinal de outra maneira, quando a geração do mesmo acontecia dentro do adaptador gráfico em ambiente digital.

Quem passou por tudo isso poderá ter agora uma vaga lembrança dos tubos, mas a fama justa que eles tiveram me levam a crer que ainda existe muita gente por aí que não consiga passar sem um! [Webinsider]

. . . . .

Leia também:

- Pontos quânticos

- Fabricantes de TVs com HDR abandonam o suporte a 3D

- HDR avança nas telas de TV feitas no Brasil

- Mais textos de Paulo Roberto Elias

Paulo Roberto Elias

Paulo Roberto Elias é professor e pesquisador em ciências da saúde, Mestre em Ciência (M.Sc.) pelo Departamento de Bioquímica, do Instituto de Química da UFRJ, e Ph.D. em Bioquímica, pela Cardiff University, no Reino Unido.

2 respostas

Oi, Fábio,

Eu também tive monitores de tubo de alto nível, e muita gente que eu conheço ficou com o pé para trás com o LCD. Os primeiros monitores realmente eram muito ruins, mas os de hoje te garanto são excelentes, dependendo do modelo. O único problema, para variar, é o preço!

Eu demorei a abandonar o meu 17″ tela plana desajeitado e pesadíssimo pq a imagem dele era MUITO superior a dos primeiros LCD. Só uns 3 ou 4 ano atrás quando os LCDs realmente bons já estavam a preço de banana é que aceitei trocar.