Um microprocessador trabalha com limites e tolerâncias derivadas do seu design e objetivo. Burlar estes limites pode inviabilizar a performance de um computador ou outro equipamento que dependa deste tipo de componente.

Quando se lida com informática e se quer saber o mínimo sobre ela, uma das coisas que se aprende é que um computador pessoal só se tornou possível com o desenvolvimento dos microprocessadores. Por definição, um microprocessador é um chip do tipo circuito integrado, capaz de realizar múltiplas tarefas. A computação e o processamento de dados é uma delas. Para tal ele precisa ser programado para executar tarefas.

Nos dias atuais, é difícil lembrar das limitações que foram enfrentadas nos primeiros microcomputadores. A escassez de memória quando, por exemplo, um sistema operacional de discos exigia míseros 64 Kbytes de RAM, caso contrário ele não rodava.

Para quem não é da área, nenhum desses conhecimentos chega de graça, e se existe uma coisa triste que eu aprendi quando comecei a me interessar por microcomputadores foi de que a máxima “conhecimento é sinônimo de poder”, se aplicavava literalmente no aprendizado deste campo de estudo.

Nas aulas práticas do Núcleo de Computação Eletrônica da UFRJ (NCE) foram poucos aqueles que eu conheci que queriam compartilhar conhecimento. Os monitores eram em sua maioria alunos do Instituto de Matemática, e o nosso professor de Basic também era de lá. Ora, eu comecei a minha vida acadêmica como monitor, depois fui chefe da monitoria no meu departamento por dois anos, substituindo uma colega cujo marido estava muito doente e ela de licença. Eu sei, por experiência, quanto tempo eu gastei não só treinando monitores, mas principalmente os ensinando a nunca esconder qualquer informação dos alunos no laboratório, coisa que os monitores da Matemática faziam sem pudor!

Uma boa parte do conhecimento sobre como um microprocessador funciona ajuda até hoje a se entender os meandros e as vicissitudes da informática que o usuário que não é da área vai ter que eventualmente aprender a driblar, ou então se livrar delas sem ser prejudicado!

Basta citar a guerra de velocidade entre os fabricantes de CPU. A AMD, que eu me lembre, foi a primeira a citar a concorrente Intel, exibindo a alegada superioridade dos seus processadores Ryzen, e continua a fazê-lo até hoje, impiedosamente.

Para o deslumbrado e para o desavisados o discurso da AMD pode até ser convincente, mas para o usuário entusiasta e experimentado não!

O Precision Boost Overdrive é um embuste!

Com o advento dos processadores Ryzen de segunda geração, a AMD introduziu um algoritmo sofisticado no UEFI BIOS das placas-mães, chamado de Precision Boost Overdrive, ou PBO, agora na sua segunda versão.

A AMD convocou um tal Robert Hallock, até o ano passado era gerente de marketing da empresa, para demonstrar no YouTube o extraordinário recurso dos Ryzen, cerca de uns 4 anos atrás:

Depois, o mesmo Hallock voltou à cena para encantar todo mundo, com recursos revolucionários do Precision Boost Overdrive 2:

Um recurso fabuloso da segunda versão é o de alterar a curva de resposta do processador, de modo a conseguir mais performance com menor temperatura e voltagem. Apenas que este novo recurso não se aplica a qualquer CPU Ryzen, portanto de extensão limitada.

O que o nosso bom Robert Hallock não conta nestes vídeos é que o uso do Precision Boost Overdrive, e os potenciais danos recorrentes dele, anulam a garantia do processador Ryzen!

Em e-mail recente com um técnico brasileiro da AMD ele me fala que o ajuste “AUTO” (ajuste a critério da placa mãe) de PBO no BIOS do computador é o mesmo que “Desabilitado”, aparentemente por imposição da AMD.

Além disso, existe em muitas placas-mães um segundo menu de ajuste de PBO, no qual aparece um aviso de que o ajuste pode danificar a máquina, e por isso o usuário tem que “aceitar” prosseguir com o restante dos ajustes.

Depois de aceitar os riscos, uma série de menus e ajustes permitem o usuário otimizar o funcionamento do PBO. Entre os ajustes avançados existe na segunda versão do PBO aparece a anunciada “Otimização da Curva”:

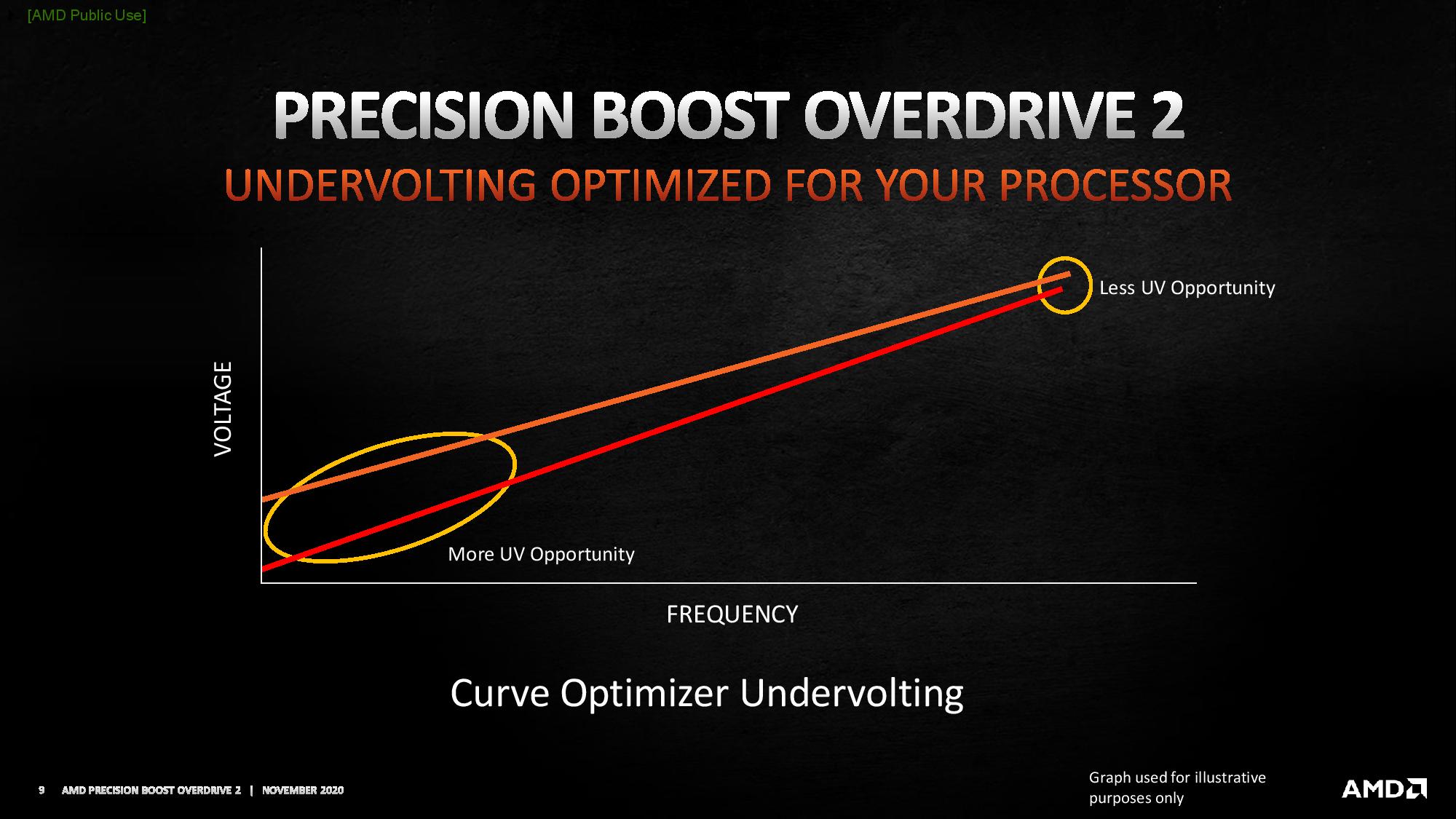

O atrativo do ajuste da curva é que agora é possível abaixar a voltagem da CPU e ao mesmo tempo manter a sua velocidade de batimento (frequência):

O ajuste é audacioso e, em tese, tudo o que se quer no aperfeiçoamento de performance de uma CPU. E é fácil se entender por quê:

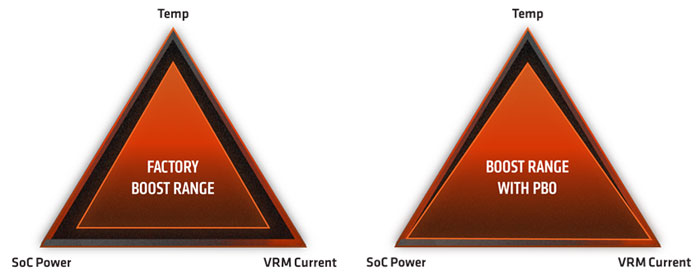

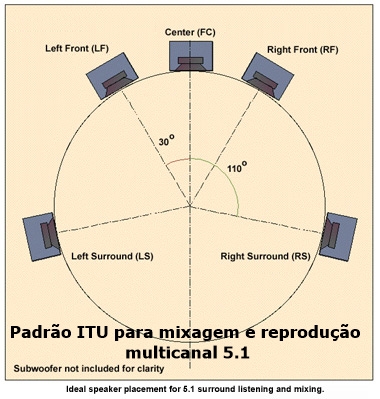

Para rodar um programa gravado no microprocessador, quanto maior for a sua velocidade melhor. Um chip deste tipo trabalha com a ajuda de um circuito que determina o número de batimentos (do relógio ou “clock”) executados por segundo. Normalmente, estes valores são expressos, neste caso das CPUs modernas, em GHz. Para se conseguir isso, é preciso aumentar a voltagem de alimentação do chip, mas este aumento acarreta também um aumento da temperatura no chip. O que o Precision Boost Overdrive iria oferecer seria a otimização da relação entre Velocidade (Clock), Voltagem e Temperatura, através do controle dos reguladores de tensão da placa-mãe:

Parece ótimo, não é não? Mas, então fica a seguinte pergunta: se eu puder fazer o Ryzen rodar ainda mais rápido, sem sacrificar o seu desgaste pelos aumentos de voltagem e temperatura, porque então a AMD não quer correr o risco e intimida o usuário com a perda de garantia?

A ausência dos alegados benefícios

Na realidade, este ajuste do PBO não traz nenhum benefício ao usuário que usa o computador para trabalho. Para o “gamer” o aumento de quadros por segundo também não justificaria a perda de garantia, caso ele ou ela tenham um mínimo de bom senso!

E por quê? Uma CPU Ryzen já sai da fábrica com a capacidade de processamento elevada. Além disso, a velocidade de fábrica (“stock”) pode perfeitamente aumentar com o aproveitamento de algoritmos seguros, escritos e incluídos no UEFI BIOS de uma placa-mãe de qualidade. Ou seja, se o usuário não se interessa ou não quer gastar tempo tentando entender ajustes complicados, é só deixar esses ajustes em “Auto”!

Todo microprocessador pode sofrer danos com uma voltagem excessiva e/ou com uma velocidade além da sua capacidade de batimento (“clock”). Além disso, o efeito imediato de uma CPU trabalhando além da sua capacidade se reflete no travamento de execução do sistema operacional. O computador pode simplesmente parar de funcionar, e se a CPU continuar estressada, ela vai impedir o próprio computador de rodar. É por isso que os fabricantes de placa-mãe incluem no hardware um meio de voltar o BIOS para as suas configurações de fábrica, conservadoras por natureza. Se a CPU ainda estiver hígida, isto é, sem danos, o computador volta a rodar normalmente.

Uma CPU só não faz verão

Um computador moderno deve reunir componentes que, por si só, já rodam com alta performance, como a placa gráfica, memória RAM, drives, etc. Todos esses componentes interagem quando um programa é rodado no ambiente operacional, e se a máquina for bem construída, com componentes compatíveis, o sistema operacional rodará também com total estabilidade!

O risco do chamado “overclocking”, tão procurado por entusiastas, é o de estar a um passo de inviabilizar o funcionamento de qualquer componente, fazendo o sistema como um todo ficar instável.

A estabilidade do sistema operacional, debaixo de uma carga de trabalho pesada, é o sinal que indica que todos os componentes estão funcionando nas suas tolerâncias e limites. O usuário que não quiser perder o seu trabalho, deve se assegurar que este status de funcionamento da máquina foi atingido!

Quando recentemente, após instalar um banco de memória de 3600 MHz, em contato por e-mail com o suporte da AMD eu questionei e pedi orientações sobre o limite da minha Ryzen 9 3900X de somente aturar uma memória de 3200 MHz de velocidade.

Inicialmente, o técnico disse que eu teria instabilidade na máquina, mas nenhuma tela preta (Windows 11) havia aparecido na minha frente até então. Além disso, o Windows acusou a extensão de 32 Gbytes e a velocidade do banco de memória conseguidas, e o aplicativo CPU-Z, tradicionalmente usado nestes casos, mostrou que a placa-mãe havia ajustado todos os timings da memória corretamente. Claro que eu tomei o cuidado de consultar a tabela de QVL (lista de vendedores de memória testadas) do fabricante da placa-mãe. Assim, somente a CPU poderia impedir que a memória funcionasse como devia.

Foi com a estabilidade do sistema que me provou que eu poderia sim, usar um banco de memória de 3600 MHz no meu sistema. Em um dado momento da troca de mensagens, o técnico acabou me dizendo que memórias acima de 3200 MHz não tinham sido ainda sido testadas com este processador!

Coisas deste tipo tem me provado que é sempre aconselhável tentar saber onde se está pisando, principalmente em uma área de conhecimento que não é a nossa, e que impõe dificuldades naturais para se entender qualquer coisa, ainda mais em uma pessoa de raciocínio lento como o meu.

Engraçado que a microinformática atingiu níveis nunca antes previstos, mas as pessoas que assistem esses shows de propaganda querem mais. E no processo, se arriscam a inviabilizar uma máquina de alta performance. Outrolado_

. . .

Paulo Roberto Elias

Paulo Roberto Elias é professor e pesquisador em ciências da saúde, Mestre em Ciência (M.Sc.) pelo Departamento de Bioquímica, do Instituto de Química da UFRJ, e Ph.D. em Bioquímica, pela Cardiff University, no Reino Unido.