Mudanças importantes e fundamentais vêm acontecendo nos dispositivos de armazenamento de dados usados na informática, um dos fatores mais críticos do funcionamento de qualquer sistema.

Ao longo dos anos o usuário que passou pela fase da microinformática de 8 bits está vendo já há algum tempo uma verdadeira revolução no tratamento de programas e arquivos que rodam em diversos equipamentos, sem falar nos servidores das chamadas nuvens, que desempenham o mesmo papel.

Eu fui do tempo em que para carregar um programa no micro ou salvar arquivos se era obrigado a fazer uso de uma fita cassete, por causa das limitações do equipamento em uso. Foi uma experiência frustrante, por vários motivos: primeiro, porque o padrão de velocidade de uma fita cassete é 1 7/8 polegadas por segundo, o que torna crítica a resposta de alta frequência, segundo porque em se tratando de leitura ou gravação de dados o ajuste de azimute era super restrito, a ponto de às vezes não se conseguir ler uma fita gravada em outro equipamento.

Eu usei durante algum tempo o deck cassete Data Corder, fabricado pela Gradiente. Ele tinha um furo na tampa de maneira a se alterar o azimute da cabeça de leitura. O ajuste preciso deveria ser feito com uma fita padrão com sinal de 10 KHz, mas estas eram difíceis de conseguir. O deck era conectado ao microcomputador MSX Expert, através de um soquete DIN (veja na ilustração abaixo uma seta indicando o local), e o transporte da fita (leitura ou gravação) era comandado direto na tela do micro.

A propósito dos recursos do MSX Expert e dos problemas de leitura de fitas cassete eu publiquei um artigo com o título “Gerador de Áudio”, na revista MSX Micro número 9 (1987), que pode ser achado digitalizado no site Datassete, para quem tiver curiosidade ou interesse.

Na época do MSX meus amigos e eu formamos um grupo animado com as perspectivas de usar um microcomputador como ferramenta de trabalho. A UFRJ havia acenado com um curso de introdução à informática, com CP/M e programação em Basic, novidades que a maioria de nós professores não conhecia. Inscrevi-me na primeira turma. Curiosamente, dos cinquenta professores que estavam lá, menos de vinte ficaram para a segunda aula. Motivo? O assunto era para lá de árido. Eu cheguei a ouvir uma colega professora me dizer “Eu nunca vou aprender isso!…” E se mandou!

Mas, eu e outras pessoas persistimos e lutamos contra a ignorância, para aprender conceitos que alguns achavam (equivocadamente) ser “coisa para gênios”. Eu descobri logo cedo que o assunto demandava muito esforço para os que não eram da área, como eu.

Ficou óbvio logo cedo também que um dos aspectos mais importantes da computação de dados era a preservação do trabalho efetuado. Olhando com atenção a história da informática fica evidente que esta preocupação existe desde os primeiros inventores. Na era moderna Konrad Zuse, por exemplo, usou filme 35 mm descartado para perfurar códigos de dados e assim guardar os seus programas de cálculos e resultados.

Desnecessário dizer que o uso de fita cassete não era só frustrante, mas inconfiável! A indústria da informática naquela época já havia partido para os discos flexíveis (floppy disc). Eu mesmo usei no meu curso da universidade um floppy (disco flexível) gigantesco de 8 polegadas, de face única, mas logo a seguir apareceram no mercado os discos flexíveis de 5 1/4 de polegada, de dupla face.

E quando eu disse aos meus amigos que iria comprar um drive para discos de 5 1/4 polegadas, eles me perguntaram por que. Depois que todos correram atrás, a resposta foi achada por eles próprios na prática: o disco flexível era brutalmente mais rápido e prático do que uma fita cassete. Claro que alguns daqueles drives tinham problemas, mas pelo menos não era preciso saber onde ficava o ajuste de azimute.

A corrida atrás dos discos

Olhando a história da informática em retrospectiva, um dos caminhos que mais foi trilhado na busca da eficiência no armazenamento de dados foi o uso de discos. Os primeiros discos rígidos (a base de pratos) foram de uso exclusivo dos mainframes, pesados e cheios de problemas. Os discos flexíveis foram atrativos no uso de microcomputadores de 8 e 16 bits, e tomaram impulso nas décadas de 1980 e 1990, ficando depois obsoletos.

Um formato de drive que se tornou temporariamente popular foi o Zip Drive, fabricado pela Iomega. O drive usava o Zip Disk, que conseguia armazenar 100 MB de dados, daí o sucesso em relação dos floppies, que chegavam no máximo a 1.44 MB. Em curto espaço de tempo o Zip Disk alcançou 250 MB de memória, com uma taxa de transferência de cerca de 1 Mbyte por segundo.

O Zip Drive podia ser instalado em baias de 3 1/2 polegadas ou de 5 1/4 com adaptadores. Drives externos foram fabricados pela Iomega, flexibilizando o uso dos discos.

Alguns percalços determinaram o abandono deste tipo de mídia: primeiro, que o disco de uma hora para a outra parava de ler, e segundo, que outras mídias, como, por exemplo, o CD-R, começaram a aparecer com amplas vantagens de armazenamento e durabilidade.

Outros tipos de tecnologia de disco também tiveram pilhas de problemas e eu passei por alguns deles. Os primeiros discos rígidos para desktop de 16 bits usavam tecnologia MFM (codificação Modified Frequency Modulation), que era uma bomba prestes a estourar a qualquer momento. E quando estourava, sai de baixo.

Ainda na década de 1990 esses discos MFM estavam por lá. E quando eu comecei a minha tese em Cardiff ninguém do departamento entendia o que estava se passando nos computadores do laboratório. Foi quando então o meu orientador da área me pediu para tomar conta. Na época se usava uma suíte de ferramentas chamada PC Tools, que rodava em MS-DOS. Esta ferramenta corrigia um desalinhamento do drive MFM, retificando o percurso das cabeças.

A gente sabia que era preciso realinhar, quando alguns arquivos já não eram mais lidos e o computador acusava erro. Foi aí que eu passei um memorando recomendando a todos os estudantes do laboratório para fazer cópia de segurança do material de tese em floppy. Logo eu percebi que muita gente lá não deu bola, demonstrando inequivocamente falta de consciência da gravidade do problema, e porque não dizer, falta de confiança na pessoa que fez aquele tipo de recomendação!

O realinhamento do drive MFM funcionava bem, porém tinha um limite de vezes para ser usado, e quando este limite chegava o drive não podia mais ser recuperado pelas ferramentas que se dispunha.

Bem que eu avisei! Um dia, eu me deparo com uma estudante de doutorado chorando copiosamente, porque o drive de um dos computadores do laboratório tinha acabado de pifar e ela havia perdido a tese toda!

Aquele computador estaria liquidado também se não fosse pelo fato de que a Seagate já vendia drives com tecnologia RLL (codificação Run Lenght Limited), mais robusta, dispensava realinhamento de cabeças, etc. A adaptação do drive era factível com a inserção de uma controladora RLL da própria Seagate em um dos slots de expansão da placa mãe. Com os novos drives RLL o estacionamento (“parking”) das cabeças era automático, evitando aquelas batidas que costumavam danificar os pratos contendo dados importantes.

A gente pensa hoje em termos de gigabytes, mas programas e arquivos daquela época estavam em dimensões bem menores, na ordem dos kilobytes. Por isso, a perda de um disco rígido era brutal, por causa do número de arquivos perdidos.

Cópias de segurança, as chamadas backups, eram e ainda são chatas de fazer, mas o esforço sempre compensa. Pode parecer exagero, mas até hoje eu tenho duas cópias de segurança, às vezes três, se eu contar a mídia ótica, que é infinitamente mais segura do que qualquer outro tipo de disco.

A evolução para a mídia em estado sólido

Era inevitável que acontecesse. Embora discos tenham sido fáceis de lidar e relativamente baratos no decorrer do tempo, a tendência era eliminar de vez toda e qualquer parte móvel dos drives.

Os primeiros drives em estado sólido (SSD ou Solid State Drive) foram lançados anos atrás com preço elevado e profunda desconfiança com relação às suas durabilidades. Até hoje, experts recomendam deixar espaço vazio em um drive SSD ou equivalente, de modo a facilitar o acúmulo de “lixo” derivado da correção de dados armazenados no drive.

O tempo vem mostrando que o quesito durabilidade de um SSD é na realidade subestimado, sendo que é perfeitamente possível que um drive sólido dure mais do que um drive convencional rotativo.

Existem vantagens óbvias no uso de um drive em estado sólido: o consumo de energia é muito menor, e no que tange a acesso à informação, o trânsito de dados tanto para escrita quanto para leitura atinge valores impossíveis de serem conseguidos por outros meios.

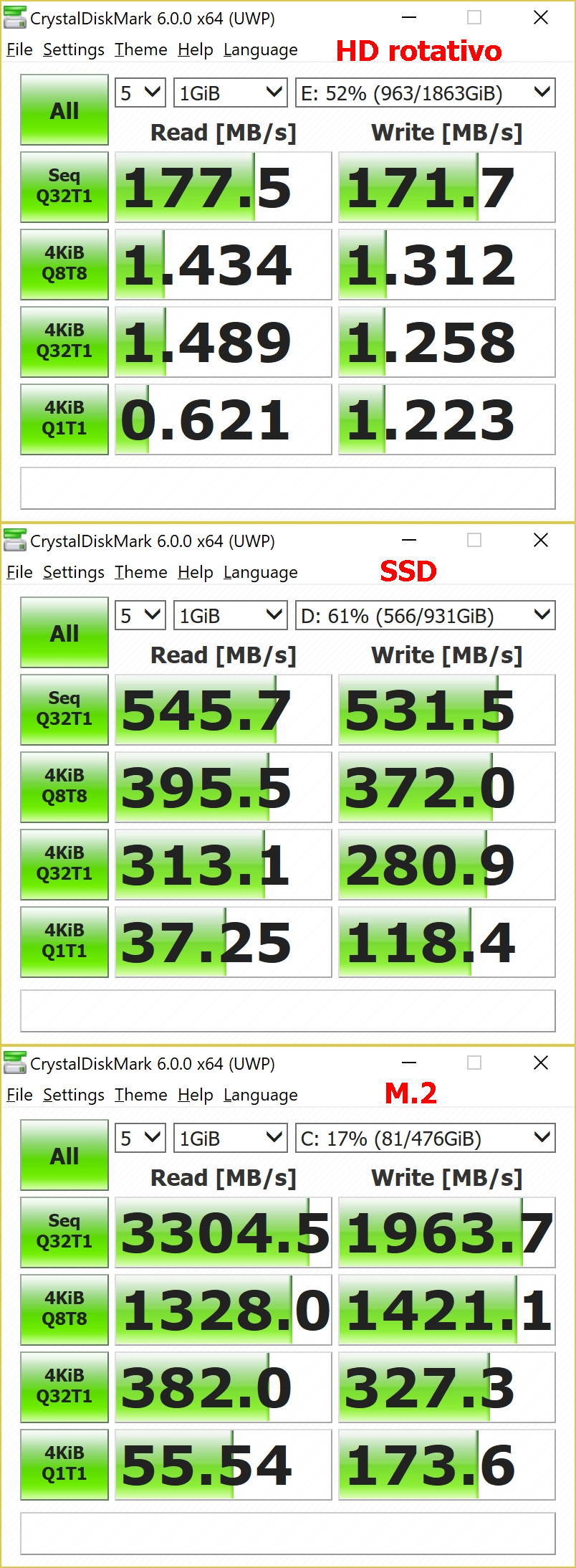

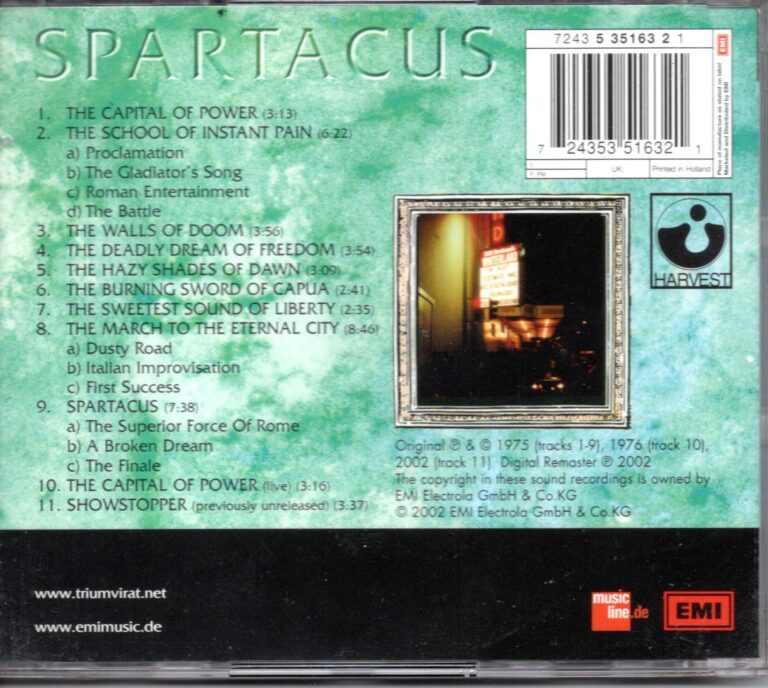

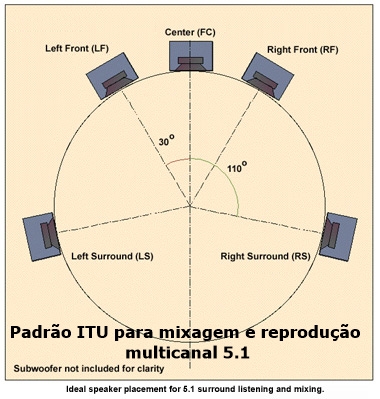

Na figura abaixo isso pode ser observado na sequência de valores máximos obtidos por testes entre um drive sólido rodando a 7 200 rpm, um SSD no barramento Sata 3, e um drive M.2 rodando em um slot ligado ao barramento PCI-E com quatro pistas de acesso para a controladora da CPU:

Pelos valores máximos obtidos com esta ferramenta de teste, nota-se a evolução de performance entre os três drives. Tomando a primeira taxa de transferência de dados medida, entre um drive convencional e um SSD a diferença atinge o triplo, e entre o SSD e o M.2 no barramento acima especificado a diferença é de 6 vezes o valor da leitura de dados.

Estes valores variam entre marcas e modelos, e também nas características de instalação entre cada tipo de placa mãe, onde cada componente (CPU, memória, chipset, etc.) tem peso significativo sobre este desempenho.

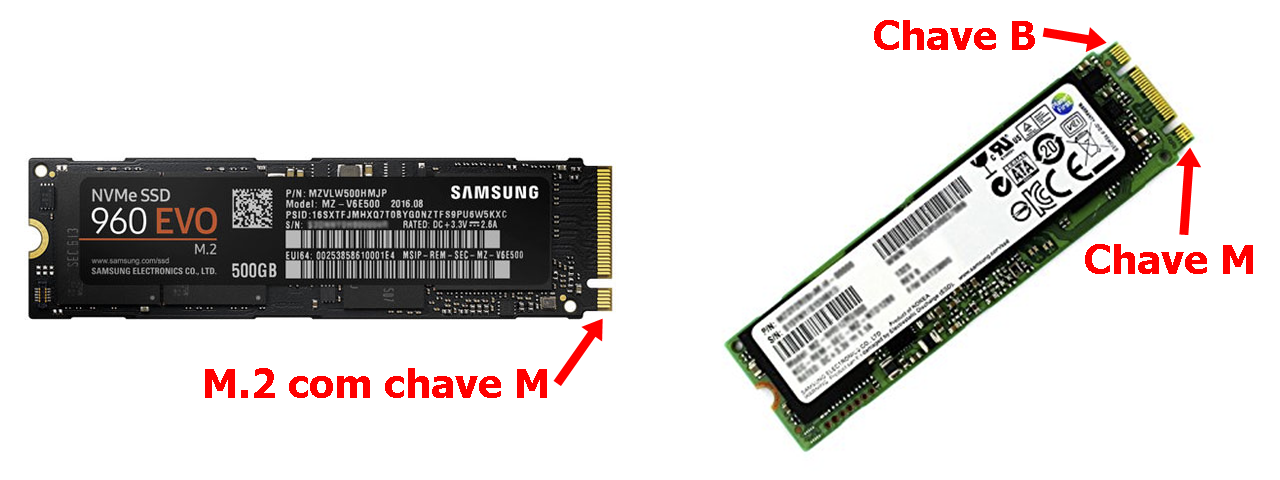

Na arquitetura de uma placa mãe mais recente e mais moderna a inserção de um drive M.2 é feita em um slot dedicado. Existem vários tipos de drive M.2, e quando o usuário está interessado em comprar um, é preciso ter cuidado para não comprar o drive errado.

Cada drive tem previsão para inserção em um dado slot. Chaves no soquete, classificadas como M e B servem de guia na hora da instalação. Na maior parte das vezes o drive vem com chave M apenas.

Os gargalos da informática

Há muitos anos atrás o meu irmão costumava dizer que “não tem um micro igual ao outro”, e ele tinha razão. A maior preocupação que existe até hoje quando se monta um microcomputador em casa é evitar os chamados “gargalos”. Como “gargalo” entenda-se qualquer componente ou barramento que diminua a velocidade de trânsito de dados.

Gozado que na bioquímica existe fenômeno idêntico: quando se estuda a biotransformação de uma dada substância, indo do ponto A ao Z, cada etapa desta transformação tem uma velocidade determinada pela atividade enzimática a ela pertinente e até a fatores de controle do ambiente celular. O processo como um todo é chamado de via metabólica, composto pelo encadeamento dessas reações. No final, a velocidade de uma via é determinada (ou limitada, se quiserem) pela reação mais lenta.

Em um microcomputador basta apenas um componente, seja hardware ou até software, ser mais lento, para prejudicar a performance do equipamento como um todo.

Evitar gargalos é quase impossível, mas quem monta evita o que puder. É neste ponto que dispositivos de armazenamento como esses drives sólidos desempenham um papel importante e perfeitamente evitável.

O drive que contém os dados que carregam o sistema operacional ou outros componentes deve permitir a leitura do que está lá o mais rápido possível. Uma forte evidência de que existe um gargalo entre o drive onde está o sistema operacional e a CPU (ou o resto do computador, se quiserem) é mostrada quando alguém retira um drive rotativo de um notebook qualquer e o substitui por um SSD ou M.2. Basta dar partida a frio no sistema, que a diferença é notada na mesma hora!

Infelizmente, os gargalos provocados por drives de armazenamento não são os únicos e seria preciso escrever um longo artigo sobre isso, que obviamente não cabe neste já prolixo espaço. Basta dizer que a interação CPU-GPU tem sido um dos fatores mais importantes no desempenho de um computador, e a cada ano que passa existe uma evolução cada vez mais rápida de ambos os lados!

Outrolado_

Paulo Roberto Elias

Paulo Roberto Elias é professor e pesquisador em ciências da saúde, Mestre em Ciência (M.Sc.) pelo Departamento de Bioquímica, do Instituto de Química da UFRJ, e Ph.D. em Bioquímica, pela Cardiff University, no Reino Unido.

0 resposta

Outra novidade esta na area Dados e Armazenamento. Com a atualizacao, as informacoes mais importantes sobre consumo de rede e armazenamento tem uma visualizacao mais rapida. Por outro lado, a tela inicial e as funcoes principais do aplicativo nao apresentam novidades.