O paradigma “quanto maior, melhor” na inteligência artificial

Share on facebook

Share on twitter

Share on linkedin

Share on whatsapp

Share on telegram

Share on pocket

Share on facebook

Share on twitter

Share on linkedin

Share on whatsapp

Share on telegram

Share on pocket

Mais lidas

Triumvirat, o rock progressivo na Alemanha

fevereiro 23, 2026

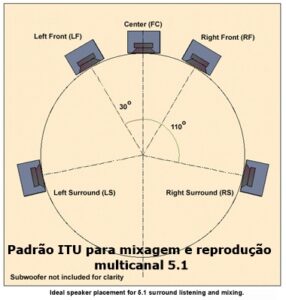

Digital Music Products

fevereiro 18, 2026

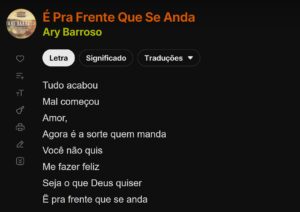

Pra frente é que se anda

fevereiro 11, 2026

Um nobreak das arábias

fevereiro 4, 2026

CPUs antigas e obsoletas, que não deixam a menor saudade

fevereiro 2, 2026

Escrevi meu primeiro e-book Kindle. E agora, acontece o quê?

janeiro 27, 2026

Mais conteúdos

Marca e vendas não são a mesma coisa

março 3, 2026

Triumvirat, o rock progressivo na Alemanha

fevereiro 23, 2026

Digital Music Products

fevereiro 18, 2026

Pra frente é que se anda

fevereiro 11, 2026

A pesquisa de IA tem sido dominada por uma corrida em direção à escala, o paradigma “quanto maior, melhor”, concentrando toda energia e dinheiro em uma única solução.

Um paper muito interessante, “Hype, Sustainability, and the Price of the Bigger-is-Better Paradigm in AI”, discute o atual paradigma de bigger-is-better, onde usa-se cada vez mais escala computacional e volume de dados para evoluir o estado da arte em IA, concentrado hoje nos LLM.

A massiva escala computacional pode ser observada quando se estima que a geração de um único token, pelas versões mais atuais do GPT demanda 1 trilhão de operações aritméticas. Para gerar um poema de poucas centenas de palavras, ou 1.000 tokens usa-se 1 quatrilhão de operações aritméticas.

O fato é que nos últimos anos, a pesquisa de IA tem sido dominada por uma corrida em direção à escala, o paradigma “quanto maior, melhor”. As BigTechs estão presas em uma competição para construir clusters de computação cada vez maiores para treinar modelos de máquinas cada vez mais massivos em grandes conjuntos de dados.

No entanto, o paradigma “quanto maior, melhor” também embute resultados indesejáveis, incluindo danos ao progresso no longo prazo da IA, concentrando toda energia e dinheiro em uma única solução.

A mentalidade do maior-é-melhor criou um ciclo de auto reforço na pesquisa de IA: ela estabelece normas que recompensam o trabalho focado em escala e cria benchmarks que, por sua vez, exigem modelos ainda maiores e maiores recursos computacionais. Por outro lado, conferências e publicações de IA são pressionados a demandar experimentos em escala cada vez maiores para comparar resultados com modelos existentes.

Soluções ineficientes

O paradigma maior-é-melhor não só cria barreiras de acessibilidade, concentrando a evolução da IA nas mãos das BigTechs, mas também frequentemente leva a soluções ineficientes. Apesar de suas capacidades impressionantes, modelos maiores nem sempre são a abordagem ideal para todos os desafios de aprendizado de máquina. LLMs estão mostrando resultados impressionantes em muitas tarefas diferentes, mas não são necessariamente o melhor modelo para todos os problemas.

Por exemplo, árvores de decisão e XGBoost são mais adequados para dados tabulares e podem superar LLMs, usando uma fração dos custos computacionais. Mesmo modelos de transformadores menores baseados em BERT podem ser muito mais adequados do que LLMs autorregressivos em algumas tarefas relacionadas à linguagem, como classificação de documentos.

Em muitos casos, as aplicações de ML exigem soluções simples e econômicas para problemas “narrows” e bem definidos. Como são modelos caros e de uso geral, os LLMs são inadequados para essas aplicações.

Sair dessa armadilha e abrir novas direções de pesquisa e desenvolvimento de outros modelos de IA que podem beneficiar o setor como um todo.

Como o estudo enfatiza:” “We believe that scientific understanding and meaningful social benefits of AI will come from de-emphasizing scale as a blanket solution for all problems, instead focusing on models that can be run on widely-available hardware, at moderate costs”. [Webinsider]

. . .