Cerca de 190 anos se passaram desde que os computadores foram criados como calculadora de precisão, transformando-se em máquinas com múltiplas aplicações. Todos os princípios de seus pioneiros permanecem até hoje.

No filme Star Trek IV, o engenheiro Scott tenta falar com o computador, para provar uma teoria que lhe permite fabricar o “alumínio transparente”, mas não consegue. A seguir, o médico McCoy, tentando ajudar, lhe entrega um mouse. Aí, Scott tenta de novo e nada! O engenheiro da fábrica fica impaciente e manda Scott usar o teclado, ao que ele imediatamente diz: “O teclado? Que antiquado!”.

A anedota do filme é óbvia, e até parece que os roteiristas estavam projetando uma situação que só iria acontecer muitos anos depois. Mas, na realidade, o tempo passa tão rápido que provavelmente quase ninguém se dá conta de como a tecnologia avança, às vezes lentamente, às vezes rápido demais. Se a gente parar para pensar, a informática hoje na nossa frente está aí, passando por vários períodos e etapas, por cerca de 190 anos, evoluindo constantemente. Quase dois séculos, o que nos faz meditar como este campo do conhecimento apareceu e como ele evoluiu:

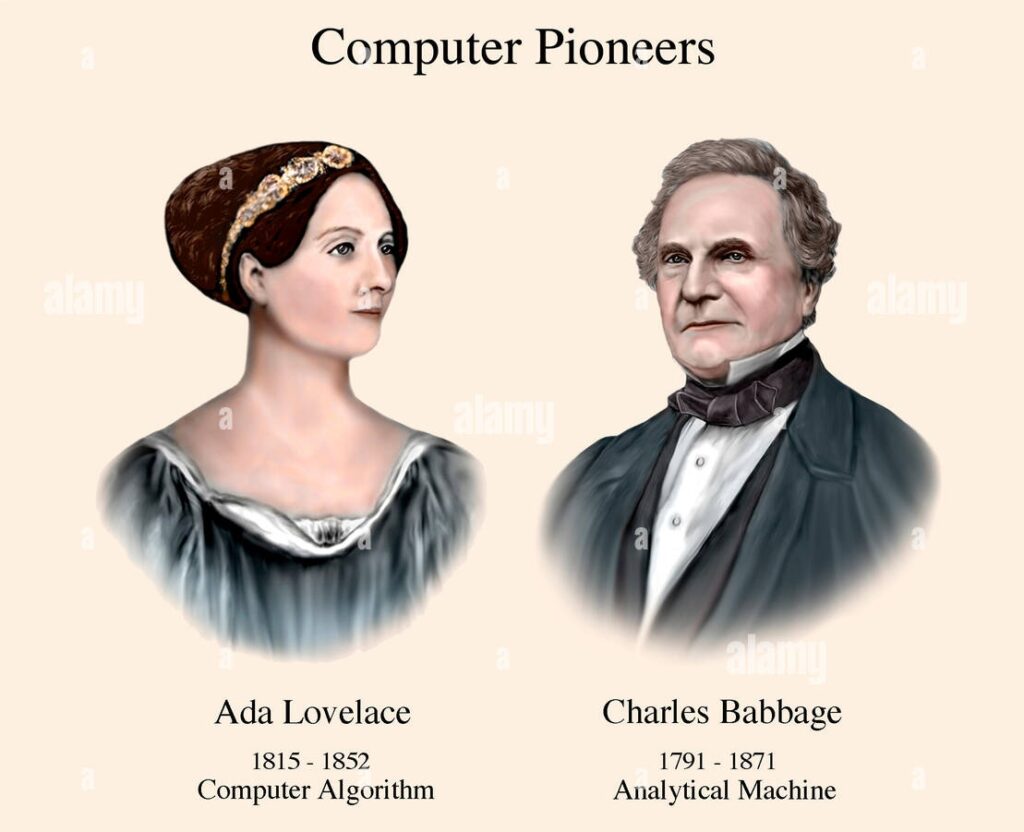

A primeira coisa que sempre me saltou aos olhos foi o sentimento de preconceito, presente no espírito de muita gente ao redor desta tecnologia. Charles Babbage, por exemplo, teve o financiamento do seu projeto mais ambicioso negado pelo governo da época. Um dos políticos influentes daquele momento e que discursou contra ele chegou a dizer algo tipo “essa invenção do Babbage não tem futuro”. A frase original foi estampada, na década de 1990, em uma das paredes do Science Museum, em Londres, para mostrar ao público a falta de visão dos políticos.

E não foi só ele que passou por isso: Konrad Zuse construiu o primeiro computador programável digital, usando relês de telefonia, e quando pensou em mudar para válvulas os homens do terceiro reich negaram o financiamento. Ele disse em entrevista que nada eletrônico tinha chance de avançar, a não ser que objetivasse algum fim militar. Típico.

Na área acadêmica que eu vivi, também muitos colegas não conseguiam ver o computador pessoal como uma importante arma para vencer problemas analíticos os mais diversos.

A visão de quem antevê o futuro

Babbage era um visionário, e muito adiante do seu tempo. Dispositivos mecânicos de cálculo já existiam antes deles, mas muito limitados e sem recursos. Ele percebeu e conferiu que todos os livros contendo tabelas de cálculos estavam cheios de erros. Assim, vislumbrou uma forma de acabar com isso. E foi por este motivo que ele desenvolveu uma máquina, chamada de diferencial, que foi projetada não só para fazer cálculos sofisticados como também imprimir os resultados!

A segunda versão desta máquina foi montada e estava disposta no Museu da Ciência de Londres lá pelos idos de 1991. Eu fui lá com a minha família, mas demos azar, porque ela foi retirada para algum tipo de manutenção. Entretanto, o repúdio do político que deu rasteira em Babbage estava lá em um mural enorme!

Babbage morreu antes de ver o progresso do seu trabalho. E as suas ideias pararam no tempo por cerca de 100 anos, quando então, trabalhando sozinho, Konrad Zuse montou o primeiro computador elétrico, digital, programável, na sala de estar da casa dos pais. Zuse percebeu que fazer a sua máquina calcular em base decimal era inviável. Para resolver isso, ele usou relês de telefonia, peças que só admitem dois estados: ligado e desligado, e com eles conseguiu a realização de cálculos em base binária.

E daí para a frente, esta foi a forma com a qual todos os computadores trabalham até hoje: nos computadores modernos, os relês foram substituídos por válvulas, depois por transistores, depois por circuitos integrados, até chegar aos microprocessadores que usamos hoje, todos calculando em base binária, e com altíssima precisão.

Um amigo de Zuse mostrou a ele que as válvulas também são interruptores de energia, mas ligando e desligando com uma velocidade mil vezes maior do que um relê. E quando Zuse fez um projeto nesta direção, o seu financiamento lhe foi negado.

Muitos anos pós guerra se passaram sem que Zuse fosse reconhecido, com justiça, como o criador do computador digital moderno. Tal como Babbage, ele havia pensado em tudo. Babbage usara cartões perfurados, inventados por Jacquard para a fabricação de tecidos, para codificar programas. Zuse usou filme 35 mm descartado para fazer o mesmo.

O sistema digital de cálculos desenvolvido por Zuse está aí até hoje, dentro de processadores com bilhões de transistores como interruptores dos zeros e uns. E esta capacidade aumenta a cada ano que passa!

Cartões perfurados foram usados por anos a fio. Na minha época de faculdade, circa 1971, alguns colegas de turma arrumavam trabalho na IBM perfurando cartões, mas o processo em si era falho e estressante, logo depois abandonado. Quem se sentiu aliviado com isso foram os programadores, que passaram a digitar e armazenar seus programas em dispositivos de memória.

Um outro avanço importante de Konrad Zuse foi a criação de uma linguagem de programação de alto nível, a Plankalkül, que nunca viu a luz do dia, porque não haviam sido criados os compiladores. Mas, a ideia de se poder programar em uma linguagem de alto nível, usando termos próximos do usuário, ficou para sempre!

O microcomputador no dia a dia da gente

Embora a maioria das pessoas nunca tenha usado um computador pessoal na vida, elas o fazem sem saber, ao colocar nas mãos um telefone celular, cuja interface com o usuário nunca demanda a digitação de qualquer comando.

Por incrível que pareça, o conceito de interface gráfica vem da década de 1960, principalmente com os trabalhos de Doug Engelbart, que criou o mouse. Durante anos, o mouse foi ignorado e só voltou à atenção dos projetistas quando os pesquisadores do Xerox Parc quiseram criar um computador que fosse fácil de usar até por uma criança.

A psicologia infantil mostrou evidências de que uma criança aprende com o tato e com a visão. E foi com base nesta premissa que eles começaram a planejar símbolos que melhor representassem o que precisa ser feito pela máquina. Na prática, “abrir um arquivo” ou “fechar um arquivo”, etc., em vez de comandos, foram representados por ícones, e está assim até hoje. O mouse serviu para manipular objetos ou ícones na tela.

O envolvimento pessoal com a máquina

Eu já estou anos fora do ambiente acadêmico, mas até hoje eu não sobrevivo sem o meu computador pessoal. Foi ele que me ajudou em todos os meus projetos de pesquisa, todos os meus manuscritos, e, porque não dizer, no meu lazer com áudio e autoração de discos.

O meu envolvimento pessoal com a informática vem antes da época do MSX, para o qual eu fiz alguns programas em Basic, que rodaram durante muito tempo. Estes programas me ajudaram a fazer operações analíticas no laboratório que demandavam precisão de resultados, portando sempre foram úteis. A informática e o processamento de dados sempre me atraíram, no sentido de conseguir resultados com muito menos esforço e com total confiabilidade.

Seguindo o que muita gente conhecida da minha época fez, eu comecei a montar computadores na década de 1990, ao invés de comprar uma máquina pronta. Isto foi feito por mim e vários amigos, para se poder ter maior controle na qualidade dos componentes instalados.

Quando os primeiros notebooks foram lançados, muita gente achou estranho que um outrora entusiasta como eu, nunca tivesse me interessado em comprar um. Eu fui indagado várias vezes sobre isso, e me vi obrigado a explicar que a arquitetura de um notebook é fixa e proprietária, pouca coisa se pode alterar do original.

Um computador de mesa, em contrapartida, é formado por componentes modulares separados e/ou integrados, seguindo princípios de arquitetura formulados por von Neumann, os quais têm objetivos específicos e podem ser trocados a qualquer momento, por interesse do usuário.

A informática está longe de ser um vício

Existe um conceito psicossocial sobre vício, que, a meu ver, na área de informática, não se aplica. Porque um computador é, antes de mais nada, uma ferramenta! Os pioneiros desta tecnologia sempre procuraram uma maneira de tornar o computador uma máquina de uso universal, de modo a atender vários tipos de aplicação.

E, de fato, o computador é a única máquina capaz de realizar múltiplas tarefas, facilitando assim o dia a dia de todo mundo, não obstante o uso pessoal nunca estar ao alcance de qualquer um, até mesmo com a introdução das interfaces gráficas.

Em casa, eu ensinei os meus filhos a não se amedrontar no uso de uma máquina programável. Porque ela está na frente de todo mundo diariamente, e é intimidadora. Quem cria a interface com o usuário, nem sempre o faz com clareza, e assim qualquer um pode empacar na escolha de uma opção na tela, sem saber o que fazer.

No ambiente do computador pessoal, o grau de dificuldade de uso varia. Alguns programas tem uma curva de aprendizado íngreme. Talvez, em um futuro que ainda está em andamento, os algoritmos de inteligência artificial possam de fato ajudar a quem trabalha, evitando todo tipo de dificuldade. Por enquanto, a ajuda é pífia, mas o que os 190 anos de criação e desenvolvimento do processamento de dados nos ensinam é que nada é impossível no campo da informática! [Webinsider]

. . .

Gary Kildall, pioneiro esquecido dos sistemas operacionais de disco

Paulo Roberto Elias

Paulo Roberto Elias é professor e pesquisador em ciências da saúde, Mestre em Ciência (M.Sc.) pelo Departamento de Bioquímica, do Instituto de Química da UFRJ, e Ph.D. em Bioquímica, pela Cardiff University, no Reino Unido.