Ferramenta Nightshade protege imagens da inteligência artificial

Share on facebook

Share on twitter

Share on linkedin

Share on whatsapp

Share on telegram

Share on pocket

Share on facebook

Share on twitter

Share on linkedin

Share on whatsapp

Share on telegram

Share on pocket

Mais lidas

A intrigante realidade da inteligência artificial

abril 24, 2024

Sabor artificial de ChatGPT

abril 23, 2024

Rebel Moon: rebelde sem causa, mas com consequências

abril 22, 2024

Personalização e experiência para o cliente: a hora é agora

abril 16, 2024

A informática mudou o mundo

abril 15, 2024

Mais conteúdos

Sugar, um seriado sem açúcar

abril 27, 2024

A intrigante realidade da inteligência artificial

abril 24, 2024

Sabor artificial de ChatGPT

abril 23, 2024

Criadores que não querem que seu trabalho apareça em imagens geradas por AI usam ferramenta Nightshade para proteger suas criações.

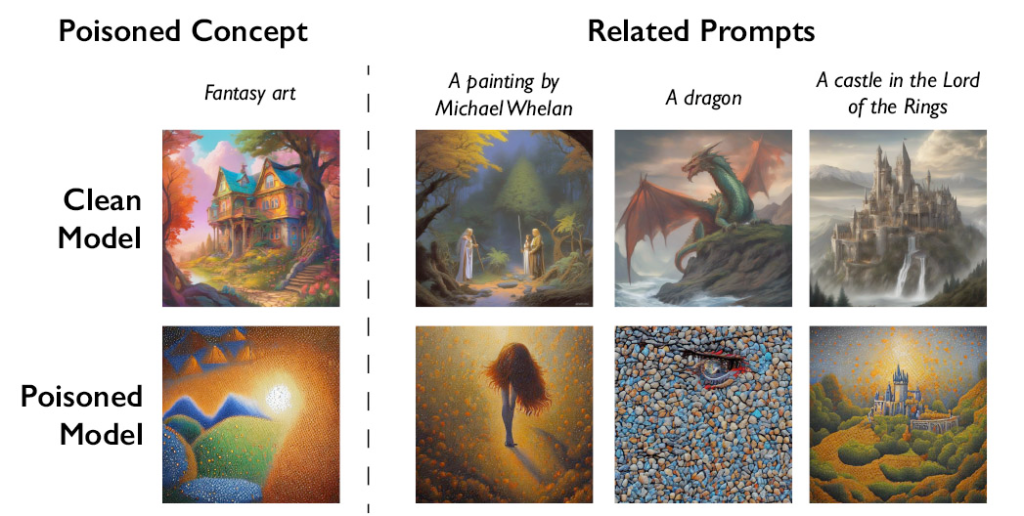

Quem com ferro fere… Para os modelos geradores de imagens, as imagens modificadas por uma nova ferramenta chamada Nightshade são iguais a todas as outras em seu conjunto de dados.

Mas, diferentemente das inúmeras obras de arte que foram usadas para treinar esses sistemas, as imagens alteradas pelo Nightshade introduzem dados imprecisos que envenenam esses modelos por dentro, fazendo com que funcionem mal de maneiras imprevisíveis.

Nightshade faz isso explorando as vulnerabilidades de modelos populares como DALL-E, Midjourney e Stable Diffusion, que são treinados em enormes conjuntos de dados de imagens extraídas da Internet aberta, muitas vezes sem o consentimento de seus criadores.

A ferramenta, desenvolvida na Universidade de Chicago, funciona adicionando pixels invisíveis a imagens que, embora indetectáveis ao olho humano, influenciam a forma como são percebidas pelos algoritmos, interrompendo a capacidade do modelo de gerar uma imagem precisa em resposta a um prompt de texto.

Quando os pesquisadores testaram o ataque nos modelos mais populares, descobriram que, depois que o Stable Diffusion recebeu apenas 50 imagens “envenenadas” de cães, a saída para “cães” começou a refletir criaturas com membros extras e faces distorcidas.

Se forem introduzidas amostras alteradas em números suficientes, os pedidos de fotos de carros resultarão, em vez de carros, em fotos de vacas; chapéus virarão bolos; e bolsas se transformarão em torradeiras.

A primeira ferramenta do gênero, Nightshade representa uma mudança radical na batalha pelos direitos de propriedade intelectual, com os artistas passando a assumir uma postura ofensiva que vai além da simples defesa do seu trabalho.

Se um número suficiente de pessoas optar por aplicar o Nightshade às suas imagens e infectar os enormes bancos de dados nos quais os modelos de IA são treinados, isso poderá causar um grande impacto nos modelos dos geradores de imagens, forçando empresas como a OpenAI a pensar duas vezes antes de treinar seus modelos em obras sem consentimento. [Webinsider]